Microsoft Research wprowadza Splitwise, nową technikę zwiększającą wydajność procesora graficznego w modelach wielkojęzycznych

2 minuta. czytać

Opublikowany

Przeczytaj naszą stronę z informacjami, aby dowiedzieć się, jak możesz pomóc MSPoweruser w utrzymaniu zespołu redakcyjnego Czytaj więcej

Kluczowe uwagi

- Splitwise to przełom w efektywności i zrównoważonym rozwoju wnioskowania LLM.

- Oddzielając fazę monitu i tokenu, Splitwise odblokowuje nowy potencjał w wykorzystaniu procesora graficznego i umożliwia dostawcom usług w chmurze szybszą obsługę większej liczby zapytań przy tym samym budżecie mocy.

Duże modele językowe (LLM) przekształcają dziedziny przetwarzania języka naturalnego i sztucznej inteligencji, umożliwiając zastosowania takie jak generowanie kodu, agenci konwersacyjni i podsumowywanie tekstu. Jednak modele te stwarzają również poważne wyzwania dla dostawców usług w chmurze, którzy muszą wdrażać coraz więcej jednostek przetwarzania grafiki (GPU), aby sprostać rosnącemu zapotrzebowaniu na wnioskowanie LLM.

Problem polega na tym, że procesory graficzne są nie tylko drogie, ale także energochłonne, a możliwości zapewnienia energii potrzebnej do ich działania są ograniczone. W rezultacie dostawcy usług w chmurze często stają przed dylematem: albo odrzucić zapytania użytkowników, albo zwiększyć koszty operacyjne i wpływ na środowisko.

Aby rozwiązać ten problem, badacze z Microsoft Azure opracowali nowatorską technikę zwaną Podzielone, którego celem jest zwiększenie wydajności i trwałości wnioskowania LLM poprzez podzielenie obliczeń na dwie odrębne fazy i przydzielenie ich różnym maszynom. Możesz przeczytać szczegółowo o tej technice w ich „Splitwise: wydajne generatywne wnioskowanie LLM przy użyciu podziału faz„praca naukowa.

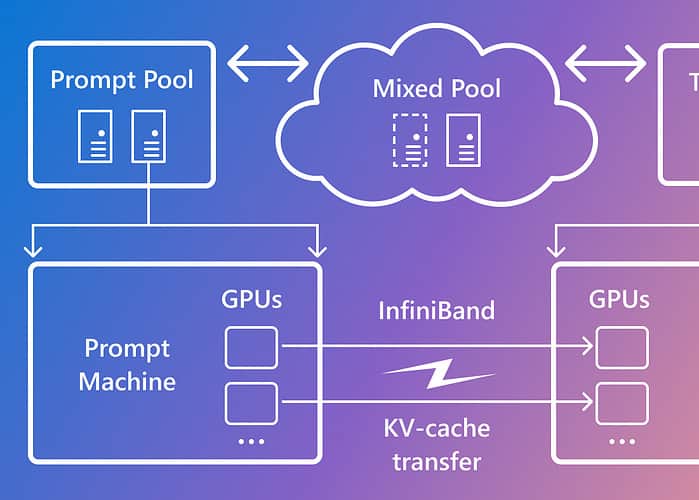

Splitwise opiera się na obserwacji, że wnioskowanie LLM składa się z dwóch faz o różnych charakterystykach: fazy podpowiedzi i fazy generowania tokenu. W fazie podpowiedzi model równolegle przetwarza dane wejściowe użytkownika, czyli monit, wykorzystując dużą ilość mocy obliczeniowej procesora graficznego. W fazie generowania tokenu model generuje sekwencyjnie każdy token wyjściowy, wykorzystując dużą przepustowość pamięci GPU. Oprócz rozdzielenia dwóch faz wnioskowania LLM na dwie odrębne pule maszyn, firma Microsoft użyła trzeciej puli maszyn do mieszanego przetwarzania wsadowego w fazach podpowiedzi i tokenu, których wielkość ustalana była dynamicznie na podstawie wymagań obliczeniowych w czasie rzeczywistym.

Korzystając z Splitwise, Microsoft był w stanie osiągnąć następujące wyniki:

- 1.4x większa przepustowość przy 20% niższych kosztach w porównaniu z obecnymi konstrukcjami.

- 2.35x większa przepustowość przy tym samym budżecie kosztów i mocy.

Splitwise to przełom w efektywności i zrównoważonym rozwoju wnioskowania LLM. Oddzielając fazę monitu i tokenu, Splitwise odblokowuje nowy potencjał w wykorzystaniu procesora graficznego i umożliwia dostawcom usług w chmurze szybszą obsługę większej liczby zapytań przy tym samym budżecie mocy. Splitwise jest teraz częścią vLLM i można go również zaimplementować w innych frameworkach. Naukowcy z Microsoft Azure planują kontynuować prace nad zwiększeniem wydajności i trwałości wnioskowania LLM oraz przewidują, że dostosowane pule maszyn zapewnią maksymalną przepustowość, obniżone koszty i efektywność energetyczną.