Microsoft patentuje „Wielostopniowy nieśmiały interfejs użytkownika” zaprojektowany dla 3D Touch

4 minuta. czytać

Opublikowany

Przeczytaj naszą stronę z informacjami, aby dowiedzieć się, jak możesz pomóc MSPoweruser w utrzymaniu zespołu redakcyjnego Czytaj więcej

Microsoft buduje całkiem spore portfolio patentów na interfejs użytkownika oparty na technologii 3D Touch, przy czym najnowszym jest udoskonalenie tak zwanych nieśmiałych elementów interfejsu użytkownika, powszechnie spotykanych w wielu systemach operacyjnych.

Przykładami „nieśmiałych” interfejsów użytkownika mogą być elementy sterujące wideo, które znikają z ekranu, chyba że dotkniesz ekranu, lub paski adresu przeglądarki, które również znikają, gdy czytasz, ale nie dotykasz strony.

Cechą wspólną tych rodzajów kontroli jest to, że istnieje tylko jeden poziom interakcji – są widoczne lub niewidoczne.

Udoskonalenie Microsoftu polegałoby na dodaniu wielu etapów do interakcji, z zamiarem zebrania nie tylko poprzez dotknięcie ekranu, na przykład zbliżenie się do ekranu palcem lub najechanie na elementy sterujące, wykryte za pomocą czujników 3D Touch, które Microsoft już zademonstrował w Nokia McLaren.

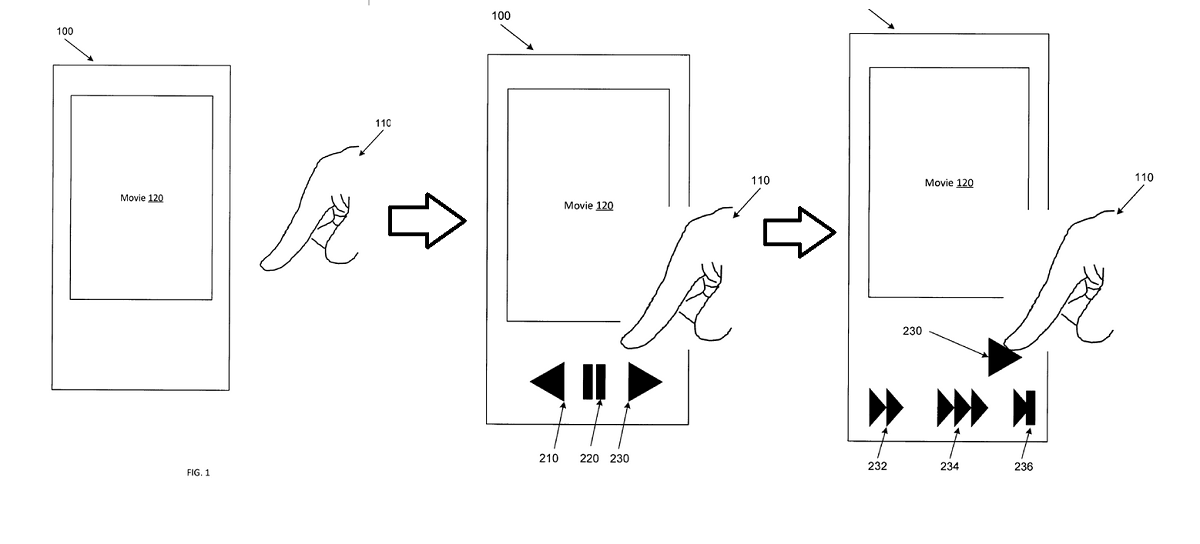

W powyższym przykładzie użytkownik zbliżyłby się do odtwarzacza wideo palcem, co odsłoniłoby elementy sterujące. Gdy zbliżą się do przycisku przewijania do przodu, różne prędkości przewijania do przodu zostaną ujawnione jako drugi etap, dzięki czemu interakcja użytkownika będzie bardziej płynna i wygodna.

Własnymi słowami patentu:

Przykładowy aparat i metody ulepszają konwencjonalne podejścia do interakcji człowiek-urządzenie, ujawniając elementy interfejsu użytkownika lub funkcje na wielu etapach zależnych od kontekstu w oparciu o rozpoznanie intencji użytkownika. Przykładowa aparatura i metody mogą opierać się na trójwymiarowych (3D) czujnikach dotyku lub zawisu, które wykrywają obecność, pozycję, orientację, kierunek ruchu lub szybkość przemieszczania się wskaźnika (np. palca użytkownika, przyrządu, rysika, pióra). Czujniki 3D mogą dostarczać informacje, na podstawie których można określić, na który obiekt, element lub region interfejsu użytkownik wskazuje, gestykuluje lub w inny sposób wchodzi w interakcję lub wskazuje zamiar interakcji. Jeżeli użytkownik nie nawigował aktywnie po urządzeniu, wówczas przykładowe urządzenie i metody mogą wyświetlać (np. wyświetlać) elementy lub działania związane z kontekstem UI, które nie były wcześniej wyświetlane. Na przykład, jeśli użytkownik ogląda wideo, może zostać wyświetlona górna warstwa elementów sterujących wideo. W przeciwieństwie do konwencjonalnych systemów, jeśli użytkownik następnie utrzymuje lub zawęża swoje skupienie na lub w pobliżu określonego elementu Ul, który właśnie został ujawniony, może pojawić się druga lub kolejna warstwa elementów lub efektów sterujących wideo. Kolejne głębsze warstwy w hierarchii mogą być prezentowane w miarę interakcji użytkownika z elementami powierzchniowymi.

Przykładowa aparatura i metody mogą ułatwiać ulepszone, szybsze i bardziej intuicyjne interakcje z szerszym zakresem elementów interfejsu użytkownika, elementów sterujących lub efektów bez konieczności stosowania trwałych afordancji ekranowych lub ukrytych gestów, które mogą być trudne do odkrycia lub nauczenia. Kontrolki jednowarstwowe, które pojawiają się po wykryciu dotyku lub gestu na ekranie, są dobrze znane. Te elementy sterujące, które są wyświetlane selektywnie po wykryciu dotyku lub gestu na ekranie, mogą być określane jako elementy sterujące „nieśmiałe”. Przykładowe urządzenia i metody ulepszają te jednowarstwowe podejścia oparte na dotyku, zapewniając wielowarstwowe nieśmiałe elementy sterujące i efekty, które są ujawniane w sposób zależny od kontekstu w oparciu o dane wejściowe, w tym interakcje dotykowe, najechanie, dotykowe lub głosowe. Interfejsy wrażliwe na najechanie mogą wykrywać nie tylko obecność palca użytkownika, ale także kąt, pod którym wskazuje palec, szybkość, z jaką palec się porusza, kierunek, w którym porusza się palec, lub inne atrybuty palca. Zatem zamiast binarnego wykrywania stanu {dotyk: tak/nie}, przestrzeń wejściowa wyższego rzędu może być analizowana w celu określenia intencji użytkownika w odniesieniu do elementu interfejsu użytkownika. Detektory zbliżeniowe 3D mogą określić, z którym obiektem lub położeniem ekranu użytkownik zamierza wchodzić w interakcję, a następnie mogą wykryć i scharakteryzować wiele atrybutów interakcji.

Nie wiadomo, czy Microsoft nadal pracuje nad 3D Touch w swoich telefonach, ale technologia ta będzie równie odpowiednia dla kamer RealSense, takich jak Windows Hello lub Hololens poprzez wykrywanie spojrzenia i śledzenie dłoni.

Czy nasi czytelnicy doceniliby interfejs użytkownika, który dynamicznie reaguje na Twoje zamiary, czy wolisz taki, który pozostaje raczej stały i przewidywalny? Daj nam znać poniżej.