Microsoft Research introduserer Splitwise, en ny teknikk for å øke GPU-effektiviteten for store språkmodeller

2 min. lese

Publisert på

Les vår avsløringsside for å finne ut hvordan du kan hjelpe MSPoweruser opprettholde redaksjonen Les mer

Viktige merknader

- Splitwise er et gjennombrudd innen LLM-slutningseffektivitet og bærekraft.

- Ved å skille forespørsels- og tokenfasen, låser Splitwise opp nytt potensial i GPU-bruk og gjør det mulig for skyleverandører å betjene flere spørringer raskere under samme strømbudsjett.

Store språkmodeller (LLM) transformerer feltene naturlig språkbehandling og kunstig intelligens, og muliggjør applikasjoner som kodegenerering, samtaleagenter og tekstoppsummering. Imidlertid utgjør disse modellene også betydelige utfordringer for skyleverandører, som trenger å distribuere flere og flere grafikkbehandlingsenheter (GPUer) for å møte den økende etterspørselen etter LLM-slutninger.

Problemet er at GPUer ikke bare er dyre, men også strømkrevende, og kapasiteten til å levere elektrisiteten som trengs for å drive dem er begrenset. Som et resultat står skyleverandører ofte overfor dilemmaet med enten å avvise brukerforespørsler eller øke driftskostnadene og miljøpåvirkningen.

For å løse dette problemet har forskere ved Microsoft Azure utviklet en ny teknikk kalt Splitwise, som tar sikte på å gjøre LLM-slutning mer effektiv og bærekraftig ved å dele beregningen i to distinkte faser og allokere dem til forskjellige maskiner. Du kan lese om denne teknikken i detalj i deres "Splitwise: Effektiv generativ LLM-slutning ved bruk av fasesplitting" forskningsoppgave.

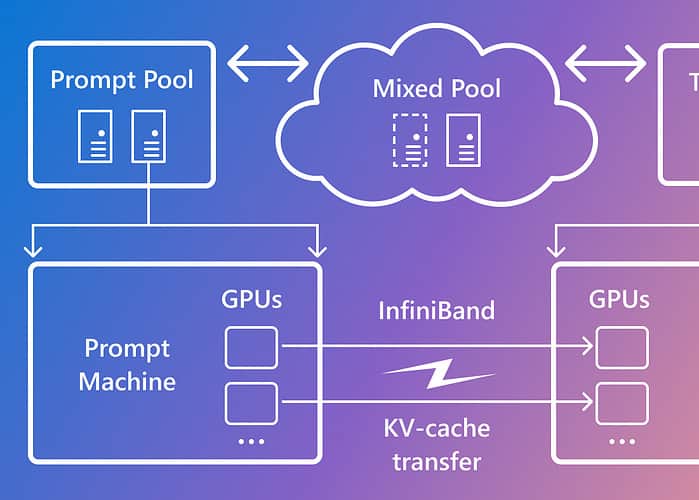

Splitwise er basert på observasjonen at LLM-inferens består av to faser med forskjellige egenskaper: promptfasen og tokengenereringsfasen. I forespørselsfasen behandler modellen brukerinndata, eller forespørsel, parallelt, ved å bruke mye GPU-beregning. I tokengenereringsfasen genererer modellen hvert utdatatoken sekvensielt, ved å bruke mye GPU-minnebåndbredde. I tillegg til å separere de to LLM-inferensfasene i to distinkte maskinpooler, brukte Microsoft en tredje maskinpool for blandet batching på tvers av prompt- og tokenfasene, dimensjonert dynamisk basert på sanntids beregningskrav.

Ved å bruke Splitwise var Microsoft i stand til å oppnå følgende:

- 1.4 ganger høyere gjennomstrømning til 20 % lavere kostnad enn dagens design.

- 2.35 ganger større gjennomstrømning med samme kostnads- og strømbudsjett.

Splitwise er et gjennombrudd innen LLM-slutningseffektivitet og bærekraft. Ved å skille forespørsels- og tokenfasen, låser Splitwise opp nytt potensial i GPU-bruk og gjør det mulig for skyleverandører å betjene flere spørringer raskere under samme strømbudsjett. Splitwise er nå en del av vLLM og kan også implementeres med andre rammeverk. Forskerne ved Microsoft Azure planlegger å fortsette arbeidet med å gjøre LLM-slutning mer effektiv og bærekraftig, og ser for seg skreddersydde maskinpooler som gir maksimal gjennomstrømning, reduserte kostnader og strømeffektivitet.