Microsoft patenterer et "Multiple Stage Shy User Interface" designet for 3D Touch

4 min. lese

Publisert på

Les vår avsløringsside for å finne ut hvordan du kan hjelpe MSPoweruser opprettholde redaksjonen Les mer

Microsoft bygger opp en ganske stor portefølje av 3D Touch-baserte brukergrensesnittpatenter, med det siste som er en foredling av de såkalte sjenerte brukergrensesnittelementene som vanligvis finnes i mange operativsystemer.

Eksempler på «Shy» brukergrensesnitt vil være videokontrollene som forsvinner fra skjermen med mindre du berører skjermen, eller nettleserens adressefelt som også forsvinner når du leser men ikke berører siden.

Felles for denne typen kontroller er at det bare er ett nivå av interaksjon – de er enten synlige eller usynlige.

Microsofts raffinement vil være å legge til flere stadier i interaksjonen, med hensikter som samles ved mer enn bare å berøre skjermen, som for eksempel å nærme seg skjermen med fingeren eller sveve over kontrollene, oppdaget med 3D Touch-sensorer som Microsoft allerede har demonstrert i Nokia McLaren.

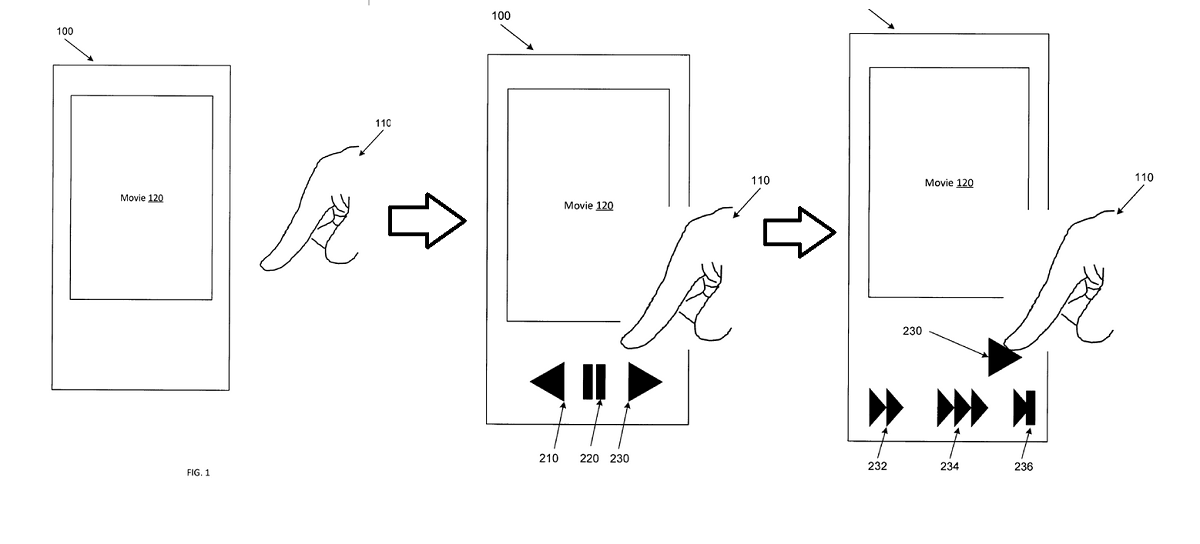

I eksemplet ovenfor ville en bruker nærme seg en videospiller med fingeren, som ville avsløre kontrollene. Etter hvert som de nærmer seg spole fremover-knappen vil forskjellige hastigheter for spole fremover bli avslørt som et andre trinn, noe som gjør brukerens interaksjon mer flytende og praktisk.

Med patentets egne ord:

Eksempler på apparater og metoder forbedres i forhold til konvensjonelle tilnærminger til menneske-til-enhet-interaksjon ved å avsløre brukergrensesnittelementer eller funksjonalitet i flere kontekstavhengige stadier basert på å forstå brukerens intensjoner. Eksempler på apparater og metoder kan stole på tredimensjonale (3D) berørings- eller svevesensorer som oppdager tilstedeværelse, posisjon, orientering, kjøreretning eller bevegelseshastighet til en peker (f.eks. brukers finger, redskap, pekepenn, penn). 3D-sensorene kan gi informasjon som kan bestemmes ved hvilket objekt, element eller område av et grensesnitt en bruker peker, gestikulerer eller på annen måte samhandler med eller indikerer en hensikt å samhandle med. Hvis brukeren ikke har navigert aktivt på enheten, kan eksempelapparater og metoder vise (f.eks. vise) kontekstrelevante brukergrensesnittelementer eller handlinger som ikke tidligere ble vist. For eksempel, hvis en bruker ser på en video, kan et topplag med videokontrollelementer vises. I motsetning til konvensjonelle systemer, hvis brukeren deretter opprettholder eller begrenser fokuset på eller i nærheten av et bestemt brukergrensesnittelement som nettopp ble avslørt, kan et andre eller påfølgende lag med videokontrollelementer eller effekter dukke opp. Påfølgende dypere lag i et hierarki kan presenteres etter hvert som brukeren samhandler med elementene på overflaten.

Eksempler på apparater og metoder kan legge til rette for forbedrede, raskere og mer intuitive interaksjoner med et bredere spekter av brukergrensesnittelementer, kontroller eller effekter uten å kreve vedvarende visninger på skjermen eller skjulte bevegelser som kan være vanskelig å oppdage eller lære. Enkeltlagskontroller som avsløres ved oppdagelse av en skjermberøring eller bevegelse er velkjent. Disse kontrollene som vises selektivt når de oppdager en skjermberøring eller bevegelse, kan bli referert til som "sky" kontroller. Eksempler på apparater og metoder forbedrer disse enkeltlags berøringsbaserte tilnærmingene ved å gi flerlags sjenerte kontroller og effekter som avsløres på en kontekstsensitiv måte basert på innganger, inkludert berørings-, sveve-, taktil- eller stemmeinteraksjoner. Hover-sensitive grensesnitt kan oppdage ikke bare tilstedeværelsen av en brukers finger, men også vinkelen fingeren peker med, hastigheten fingeren beveger seg med, retningen fingeren beveger seg i, eller andre egenskaper ved fingeren. I stedet for en binær {touch: yes/no} tilstandsdeteksjon, kan en høyere ordens inngangsplass analyseres for å bestemme en brukers hensikt med hensyn til et brukergrensesnittelement. 3D-nærhetsdetektorer kan bestemme hvilket objekt eller skjermplassering brukeren har til hensikt å samhandle med, og kan deretter oppdage og karakterisere flere attributter for interaksjonen.

Det er ikke kjent om Microsoft fortsatt jobber med 3D Touch for sine telefoner, men teknologien vil være like anvendelig for RealSense-kameraer som med Windows Hello eller med Hololens via blikkføling og håndsporing.

Ville våre lesere sette pris på et brukergrensesnitt som reagerer dynamisk på intensjonen din, eller vil du foretrekke et som forblir ganske fast og forutsigbart? Gi oss beskjed nedenfor.