Google gebruikt nu BERT-modellen om de kwaliteit van zoekresultaten te verbeteren

1 minuut. lezen

Uitgegeven op

Lees onze openbaarmakingspagina om erachter te komen hoe u MSPoweruser kunt helpen het redactieteam te ondersteunen Lees meer

Google heeft vandaag aangekondigd dat het de zoekresultaten gaat verbeteren met behulp van de BERT-techniek. Bidirectionele Encoder Representaties van Transformers (BERT) is een op neurale netwerken gebaseerde techniek voor pre-training van natuurlijke taalverwerking (NLP). In plaats van elk woord in een zin te beschouwen, zal BERT de volledige context van een woord beschouwen door te kijken naar de woorden die ervoor en erna komen. Google heeft een volgend voorbeeld gegeven van hoe BERT de zoekresultaten zal verbeteren.

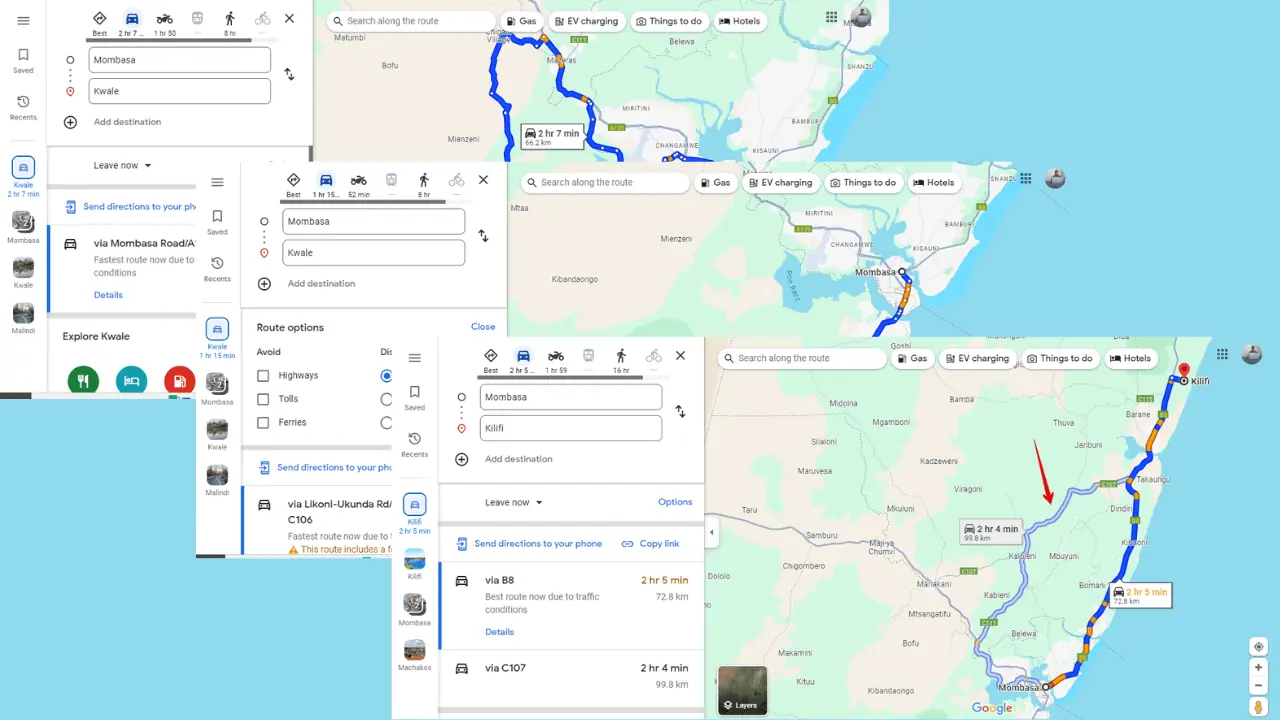

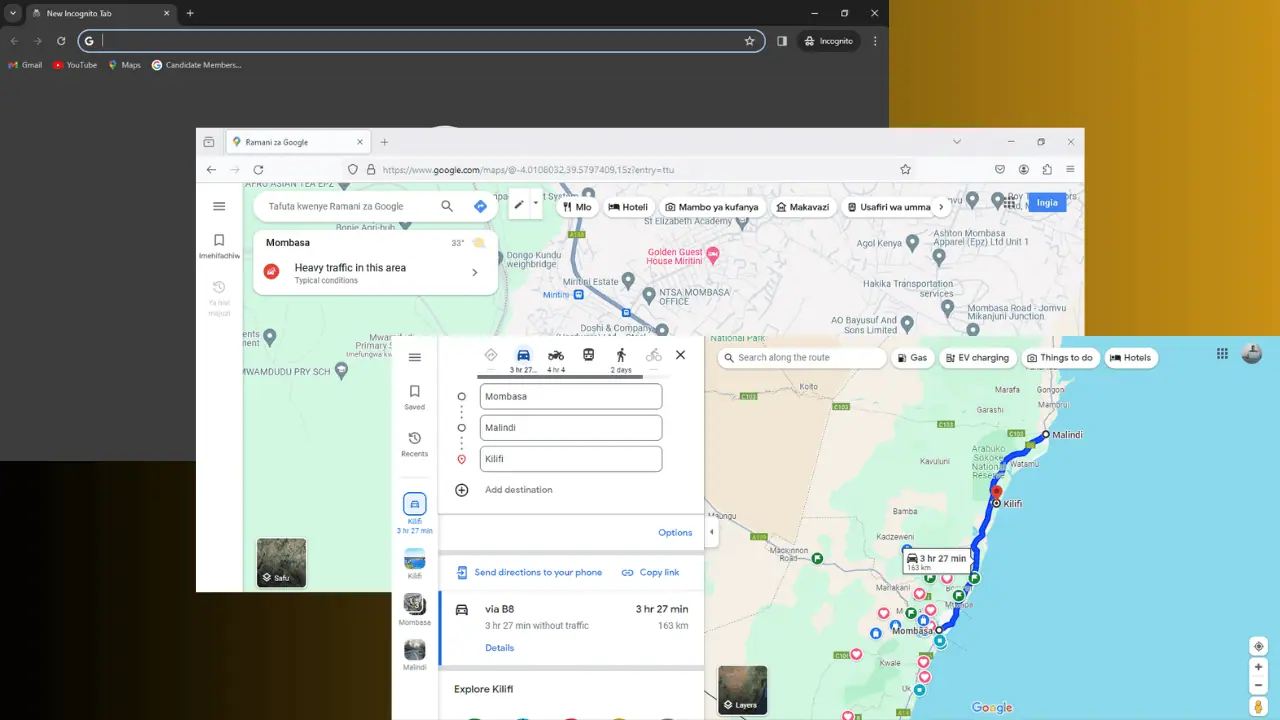

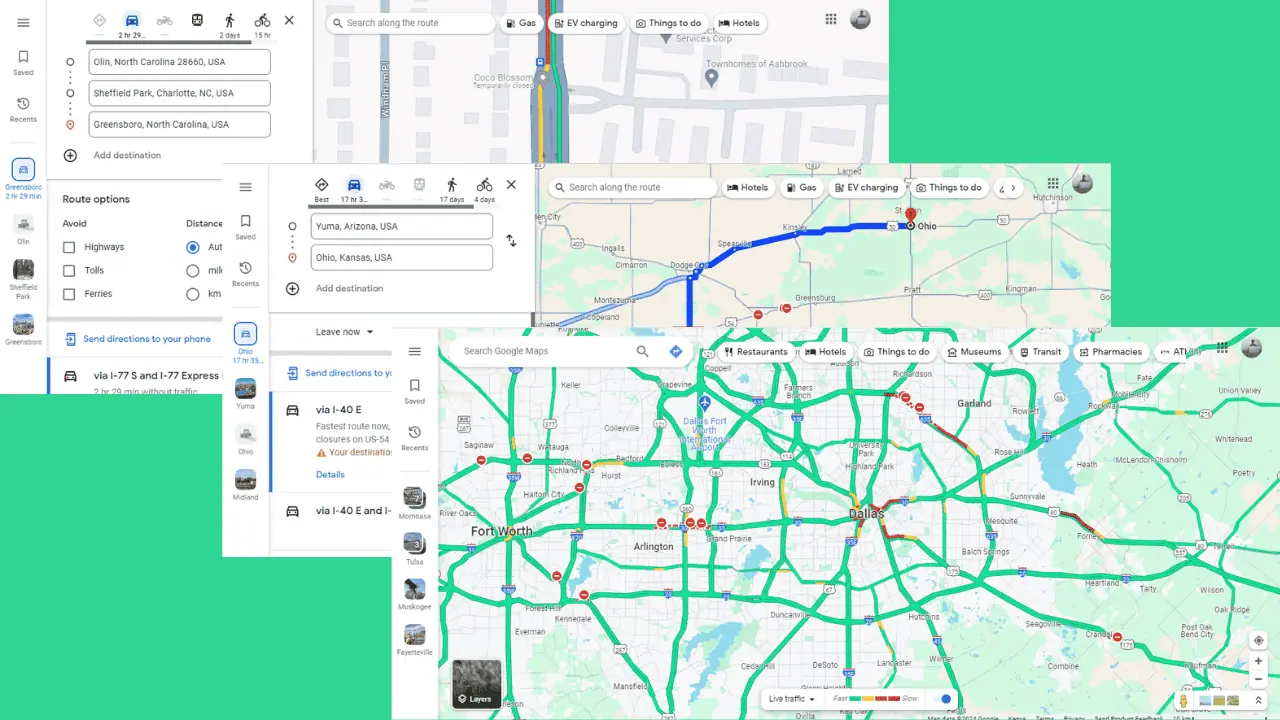

Hier is een zoekopdracht voor "Braziliëreiziger van 2019 naar de VS heeft een visum nodig." Het woord 'naar' en de relatie met de andere woorden in de zoekopdracht zijn vooral belangrijk om de betekenis te begrijpen. Het gaat over een Braziliaan die naar de VS reist, en niet andersom. Voorheen begrepen onze algoritmen het belang van dit verband niet en hebben we resultaten geretourneerd over Amerikaanse staatsburgers die naar Brazilië reizen.

Bekijk de afbeelding aan het begin van het artikel. Google kan 'staan' nu begrijpen als een fysieke activiteit en passende resultaten leveren. Google zei dat BERT Search zal helpen om één op de tien zoekopdrachten in de VS in het Engels beter te begrijpen. Google zal de komende maanden ook BERT-technologie naar meer talen en regio's brengen.

Bron: Kopen Google Reviews