Snowflake Arctic は、「エンタープライズ AI に最適な LLM」であると自負しています。それはかなり大きな主張です

今すぐHuggingFaceでSnowflakeを試すことができます

2分。 読んだ

上で公開

MSPoweruser の編集チームの維持にどのように貢献できるかについては、開示ページをお読みください。 続きを読む

キーノート

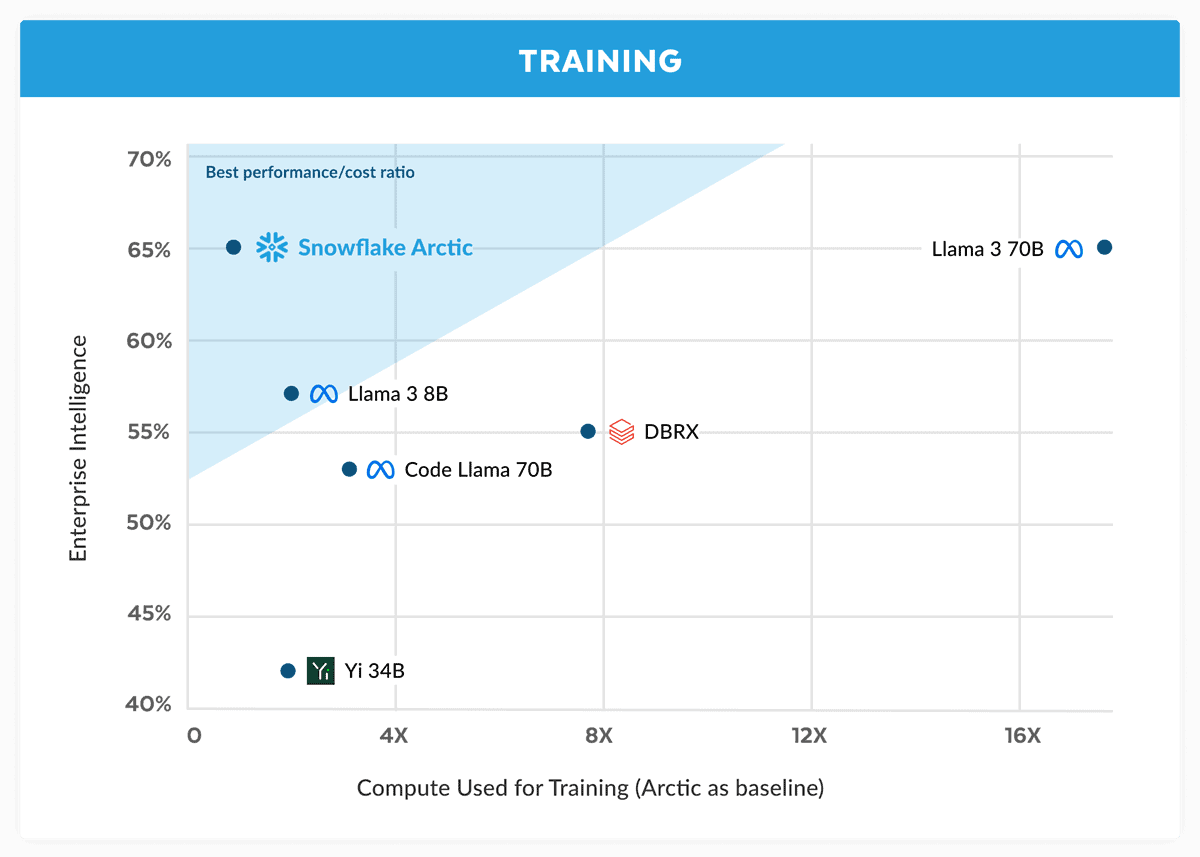

- Snowflake は Arctic を導入し、低コストで Llama 3 70B に匹敵すると主張しています。

- Arctic は、コーディングや SQL 生成などのエンタープライズ タスクに優れています。

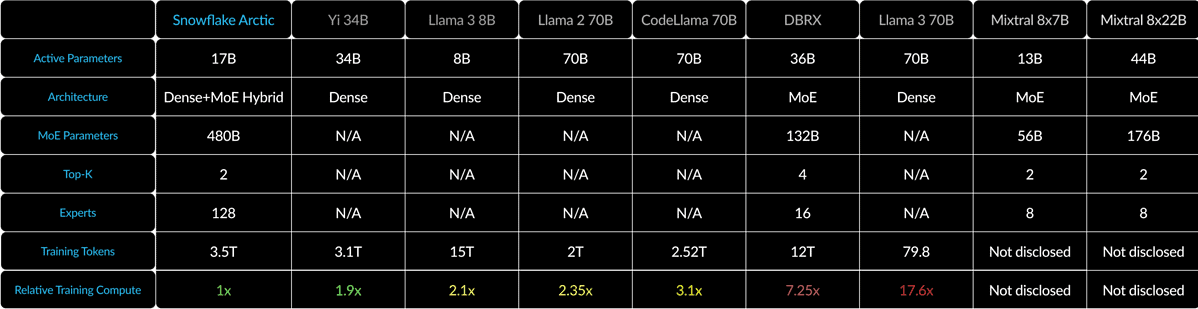

- Arctic は、Dense-MoE ハイブリッドを使用して、さまざまなバッチ サイズの効率を最適化します。

Snowflake は、当初は元 Oracle の科学者によって設立されたクラウド コンピューティングの巨人ですが、現在は AI 戦争で有力企業に挑戦しています。会社が立ち上げた スノーフレーク北極は、最新の「エンタープライズ AI に最適な LLM」であり、Llama 3 70B と同等よりも優れており、Llama 8 の XNUMXB バリアントよりも優れていると主張しました。

Snowflake は発表の中で、Arctic モデルは Llama 3 70B のパフォーマンスに匹敵するものの、コンピューティング要件とコストが低いと主張しています。これは、コーディング (HumanEval+ および MBPP+)、SQL 生成 (Spider)、命令追従 (IFEval) などの分野およびベンチマークにおけるエンタープライズ インテリジェンス タスクに最適であると宣伝されています。

特にそれを考慮すると、それは大きな主張です ラマ3 70B 重要なテストでは、GPT-4 Turbo や Claude 3 Opus などの他の主要モデルに対して良好なパフォーマンスを示しています。 Meta の次期モデルは、MMLU (主題の理解)、GPQA (生物学、物理学、化学)、HumanEval (コーディング) などのベンチマークで高いスコアを獲得していると伝えられています。

Snowflake Arctic は、Dense-MoE ハイブリッドを使用して、10B 高密度トランスと 128×3.66B MoE MLP を組み合わせています。これは合計 480B のパラメーターになりますが、アクティブに使用されるのは 17B のみで、トップ 2 ゲートで選択されます。

1 のような小さいバッチ サイズの場合、Arctic はメモリ読み取りを Code-Llama 4B と比較して最大 70 倍、Mixtral 2.5x8B と比較して最大 22 倍削減します。しかし、バッチサイズが大幅に増加すると、北極はコンピューティングに制約されるようになります。 CodeLlama 4B および Llama 70 3B と比べて、コンピューティングの負担が 70 倍少なくなります。

Snowflake Arctic を試すことができます 抱き合う顔。同社はまた、このモデルが AWS、Microsoft Azure、Perplexity などの他のモデル ガーデンにも間もなく提供されることを約束しています。