ミストラルのNeMo小型モデルがOpenAIの最新GPT-4o miniに挑む

OpenAIはつい最近GPT-4o miniをリリースした。

2分。 読んだ

上で公開

MSPoweruser の編集チームの維持にどのように貢献できるかについては、開示ページをお読みください。 続きを読む

キーノート

- Mistral AI は、OpenAI の GPT-12o mini に匹敵する、Nvidia の支援を受けた 4B モデルである NeMo をリリースしました。

- NeMo は 128k トークンをサポートし、MMLU で 68.0% のスコアを獲得しました。これは GPT-4o mini の 82% を下回っています。

- 645億XNUMX万ドルの資金を調達したMistralは、Microsoftと提携してAzure上でモデルを提供している。

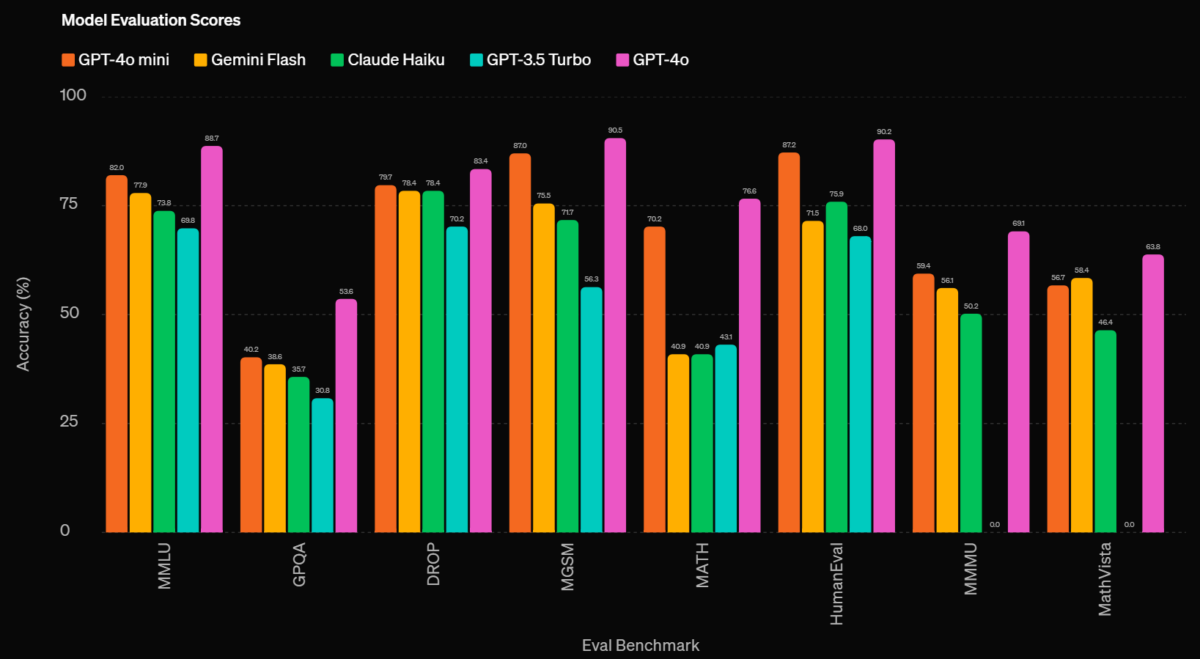

ミストラルAIは、最新の小型モデルを発表しました。 ニモNVIDIAの強力な支援を受けて、この発表はOpenAIがコストに優しい軽量モデルを発表したのと同時期に行われた。 GPT-4oミニは、Gemini Flash や Claude Haiku よりも優れたベンチマーク数値を達成しました。

この「最先端の」12Bモデルは、最大128kトークンのコンテキスト長をサポートし、推論、世界知識、コーディング精度の高性能を実現するように設計されており、現在はApache 2.0ライセンスの下で利用可能です。 ベース と 命令に合わせて調整された バージョンはHuggingFaceや他のプラットフォームでアクセスできます。

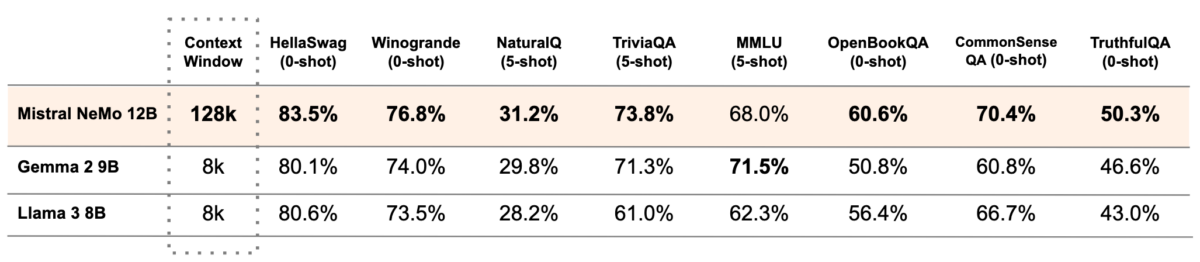

ミストラルのNeMoは、いくつかの印象的なベンチマークパフォーマンスも記録しています。モデルの全体的な知識と問題解決能力を測定するMMLUベンチマークでは、NeMoは68.0%のスコアを記録しました。これはGoogleのGemma 2に十分近いですが、OpenAIの GPT-4oミニ MMLU では 82% です。

後者は次のようになります。

多機能で多言語対応のこのモデルは、さまざまな言語で強力な機能を記録し、効率的な関数呼び出しのためにトレーニングされています。高度な Tekken トークナイザーを使用しており、特に特定の言語では、以前のモデルよりも効果的にテキストとコードを圧縮します。

Mistral は、Meta と Google DeepMind の元従業員によってわずか 645 年余り前に設立されました。同社は 2024 年 XNUMX 月に約 XNUMX 億 XNUMX 万ドルの資金調達ラウンドを実施しており、すでに AI 競争で大きな波を起こしています。

今年初め、マイクロソフトとミストラルAIも 発表の この提携により、Mistral の高度な大規模言語モデル (LLM) が Microsoft の Azure クラウド プラットフォームで最初に利用可能になります。同社はまた、Azure 上で商用モデルを提供する OpenAI にも参加しています。

ユーザーフォーラム

0メッセージ