Microsoft DeBERTaは、瞬間接着剤の読解テストで小さな人間を上回っています

2分。 読んだ

上で公開

MSPoweruser の編集チームの維持にどのように貢献できるかについては、開示ページをお読みください。 続きを読む

最近、数百万のパラメータを使用したネットワークのトレーニングで大きな進歩がありました。 Microsoftは最近、48億のパラメーターを持つ1.5のTransformerレイヤーで構成されるより大きなバージョンをトレーニングすることにより、DeBERTa(注意を解きほぐしたデコード強化BERT)モデルを更新しました。 パフォーマンスが大幅に向上したため、単一のDeBERTaモデルは、マクロ平均スコア(89.9対89.8)の点で、SuperGLUE言語処理および理解における人間のパフォーマンスを初めて上回り、人間のベースラインを適切なマージン(90.3対89.8)で上回りました。 。 SuperGLUEベンチマークは、質問応答、自然言語推論など、幅広い自然言語理解タスクで構成されています。 このモデルは、マクロ平均スコアが90.8で、GLUEベンチマークランキングのトップにも位置しています。

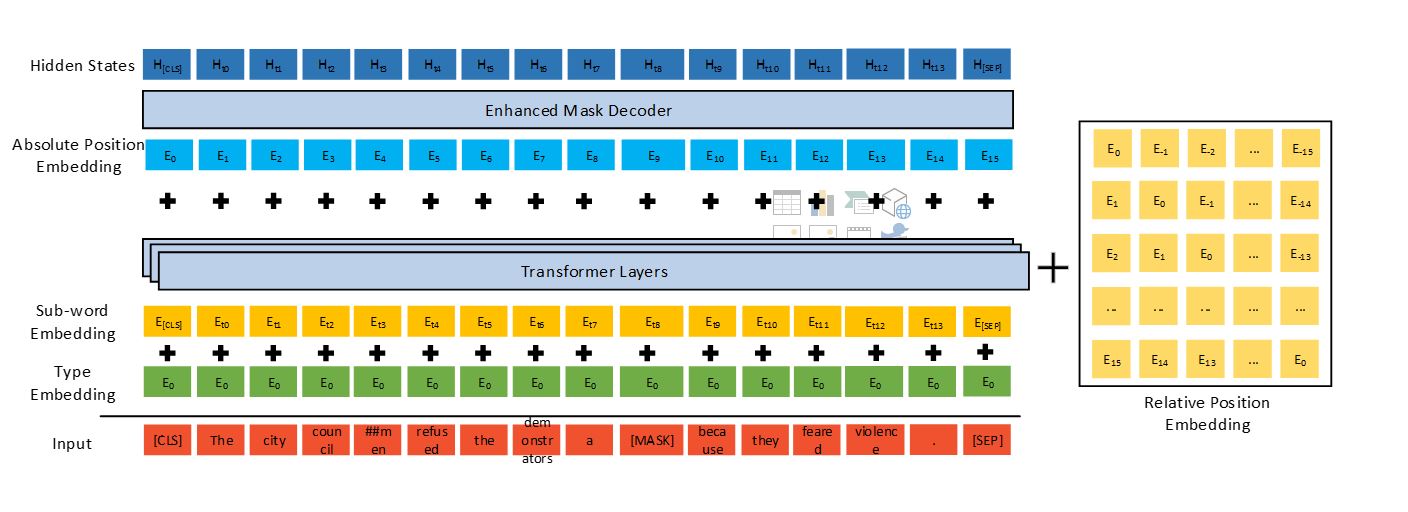

DeBERTaは、XNUMXつの新しい技術を使用して、以前の最先端のPLM(BERT、RoBERTa、UniLMなど)を改善します。解きほぐされた注意メカニズム、強化されたマスクデコーダー、微調整のための仮想敵対的トレーニング方法です。

5億個のパラメーターで構成されるGoogleのT11モデルと比較して、1.5億個のパラメーターのDeBERTaは、トレーニングと保守のエネルギー効率がはるかに高く、さまざまな設定のアプリへの圧縮とデプロイが簡単です。

SuperGLUEで人間のパフォーマンスを超えるDeBERTaは、一般的なAIに向けた重要なマイルストーンを示しています。 SuperGLUEでの有望な結果にもかかわらず、このモデルは決してNLUの人間レベルのインテリジェンスに到達していません。 人間は、さまざまなタスクから学んだ知識を活用して、タスク固有のデモンストレーションをまったくまたはほとんど行わずに、新しいタスクを解決するのに非常に優れています。

Microsoftは、Bing、Office、Dynamics、Azure CognitiveServicesなどの場所で使用されるMicrosoftTuring自然言語表現モデルの次のバージョンにテクノロジを統合し、を介して人間と機械および人間と人間の相互作用を含む幅広いシナリオを強化します。自然言語(チャットボット、推奨事項、質問応答、検索、パーソナルアシスト、カスタマーサポートの自動化、コンテンツ生成など)。 さらに、マイクロソフトは1.5億パラメータのDeBERTaモデルとソースコードを公開します。

Microsoftですべての詳細を読む こちら.