AI 用メタ次世代 MTIA チップがついに登場、さらに高速化

Google Axion チップも少し前に発表されました。

2分。 読んだ

上で公開

MSPoweruser の編集チームの維持にどのように貢献できるかについては、開示ページをお読みください。 続きを読む

キーノート

- Meta は AI に重点を置いたインフラストラクチャを構築しており、次世代 MTIA チップを発表

- その前身である MTIA v1 は、レコメンデーション モデルの効率を向上させます。

- 次世代の MTIA は実際にはより多くの電力を消費しますが、メモリと速度は向上しています。

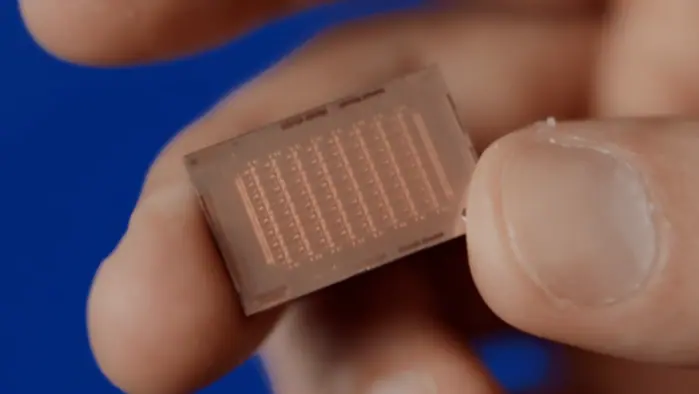

メタはちょうど 最近発表された 次世代のカスタム AI チップは、より強力で、生成 AI を念頭に置いて重点を置いていると自慢しています。それが次の MTIA チップです。

Meta Training and Inference Accelerator (MTIA) v1 は、昨年 XNUMX 月に初めて登場しました。当時、これは Meta の深層学習推奨モデルに合わせて調整された第 XNUMX 世代の AI 推論アクセラレータでした。また、Facebook や Instagram などの Meta のプロパティ全体にわたるさまざまなエクスペリエンスも刷新されました。

現在、Meta は MTIA の次のバージョンがこれまでよりも高速になることを約束しています。彼ら自身の言葉を借りれば、「ワークロードとの緊密な連携を維持しながら、以前のソリューションのコンピューティング帯域幅とメモリ帯域幅が 2 倍以上に増加します。」

への啓示で TechCrunchの, メタは、このチップがどのようなものであるかをさらに詳しく説明します。次世代 MTIA はより多くの電力を使用しますが (90 W と比較して 25 W)、より多くのメモリ (128 MB と比較して 64 MB) やより高速に動作する (1.35 MHz と比較して 800 GHz) などの優れた機能を備えています。より小さな 5nm プロセスを使用して作られており、物理的にはより大きく、より多くの処理コアを備えています。

Meta は、新しいチップが自社のデータセンターで稼働し、実稼働モデルを積極的に提供していると述べています。彼らはプログラムからの肯定的な結果を報告し、チップが単純および複雑の両方のランキングおよび推奨モデルを処理できることを強調しました。

Meta は、自社のチップはシステム全体を制御できるため、市販の GPU よりも効率的であると主張しています。

少し前にGoogleも発表しました Googleのアクシオン AI チップは、モデルを実行するための専用チップの市場に初めて進出します。インテルの新しい Gaudi 3 AI チップ また、Nvidia H50 よりも 100% 高速であると主張しています。