Opera הופך להיות הדפדפן הראשון שמשלב LLMs מקומיים

1 דקות לקרוא

עודכן בתאריך

קרא את דף הגילויים שלנו כדי לגלות כיצד תוכל לעזור ל-MSPoweruser לקיים את צוות העריכה קראו עוד

הערות עיקריות

- משתמשים יכולים כעת לנהל ולגשת ישירות לדגמי AI רבי עוצמה במכשירים שלהם, המציעים פרטיות ומהירות משופרים בהשוואה ל-AI מבוסס ענן.

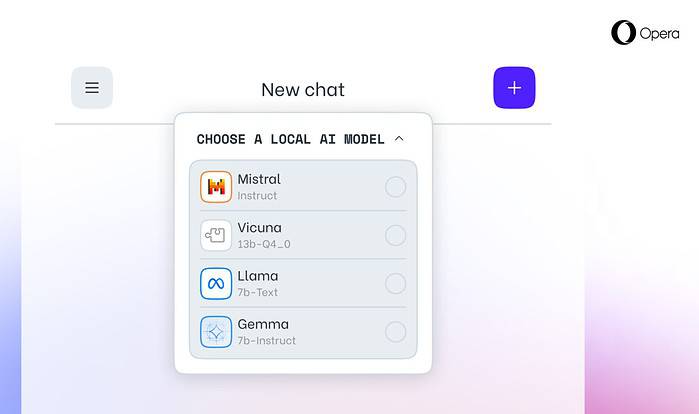

אופרה היום הודיע תמיכה ניסיונית עבור 150 מודלים מקומיים של שפה גדולה (LLMs) בתוך דפדפן המפתחים שלה Opera One. עם תמיכה זו, משתמשים יכולים כעת לנהל ולגשת ישירות לדגמי AI רבי עוצמה במכשירים שלהם, המציעים פרטיות ומהירות משופרים בהשוואה ל-AI מבוסס ענן.

בחירה ופרטיות מורחבת עם מוסדות LLM מקומיים

האינטגרציה של אופרה כוללת תכניות לימודים פופולאריות כמו Llama של Meta, Vicuna, Gemma של גוגל, Mixtral של Mistral AI ועוד רבים נוספים. LLMs מקומיים מבטלים את הצורך לשתף נתונים עם שרתים, ומגנים על פרטיות המשתמש. תוכנית ה-AI Feature Drops של Opera מאפשרת למפתחים גישה מוקדמת לתכונות החדשניות הללו.

כיצד לגשת ללימודי LLM מקומיים באופרה

משתמשים יכולים לבקר אתר המפתחים של Opera לשדרג ל-Opera One Developer, מה שמאפשר את הבחירה וההורדה של ה-LLM המקומי המועדף עליהם. בעוד שהם דורשים שטח אחסון (2-10 GB לדגם), LLMs מקומיים יכולים להציע הגברת מהירות משמעותית על פני חלופות מבוססות ענן, תלוי בחומרה.

המחויבות של אופרה לחדשנות בינה מלאכותית

"הצגת LLMs מקומיים בדרך זו מאפשרת לאופרה להתחיל לחקור דרכים לבניית חוויות וידע בתוך מרחב הבינה המלאכותית המקומית המתפתחת במהירות", אמר קריסטיאן קולונדרה, EVP Browsers and Gaming ב-Opera.