Google ora utilizza i modelli BERT per migliorare la qualità dei risultati di ricerca

1 minuto. leggere

Edizione del

Leggi la nostra pagina informativa per scoprire come puoi aiutare MSPoweruser a sostenere il team editoriale Per saperne di più

Google ha annunciato oggi che migliorerà i risultati di ricerca utilizzando la tecnica BERT. Bidirectional Encoder Representations from Transformers (BERT) è una tecnica basata sulla rete neurale per la pre-formazione dell'elaborazione del linguaggio naturale (NLP). Invece di considerare ogni parola in una frase, BERT considererà il contesto completo di una parola osservando le parole che vengono prima e dopo di essa. Google ha fornito un seguente esempio su come BERT migliorerà i risultati di ricerca.

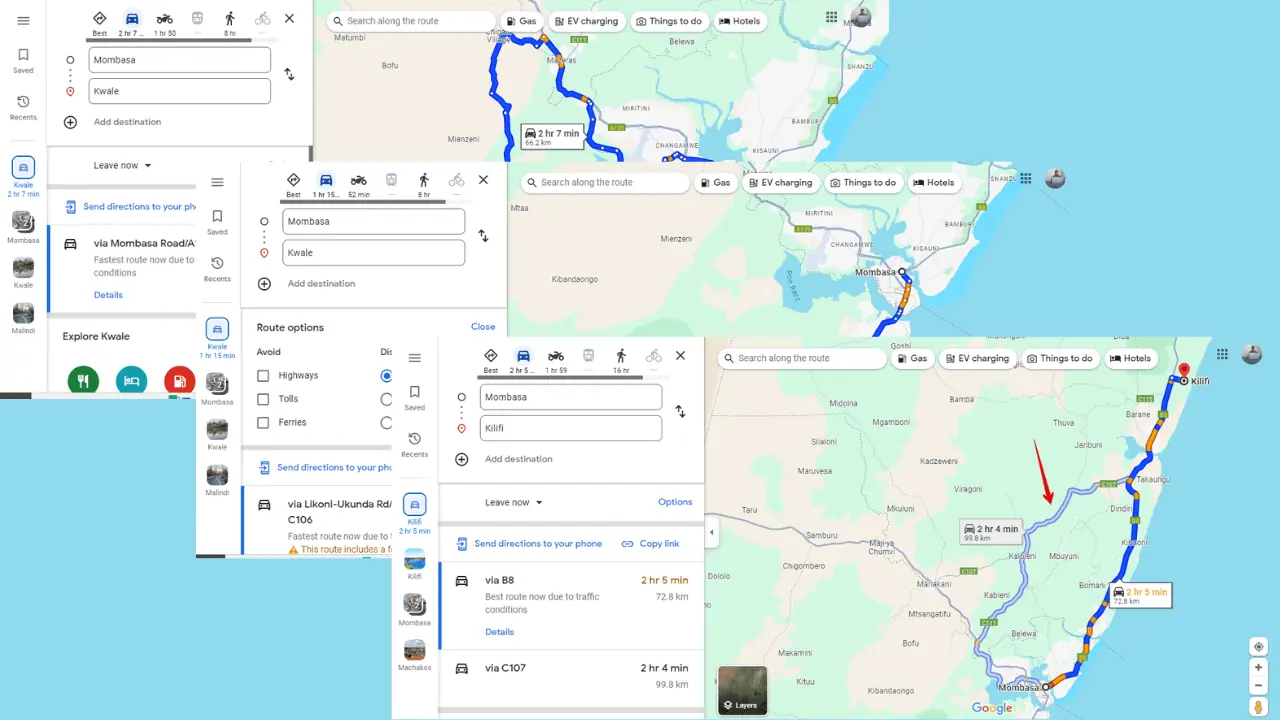

Ecco una ricerca per "i viaggiatori brasiliani del 2019 negli Stati Uniti hanno bisogno di un visto". La parola "a" e la sua relazione con le altre parole nella query sono particolarmente importanti per comprenderne il significato. Parla di un brasiliano che viaggia negli Stati Uniti e non il contrario. In precedenza, i nostri algoritmi non capivano l'importanza di questa connessione e abbiamo restituito risultati sui cittadini statunitensi che si recavano in Brasile.

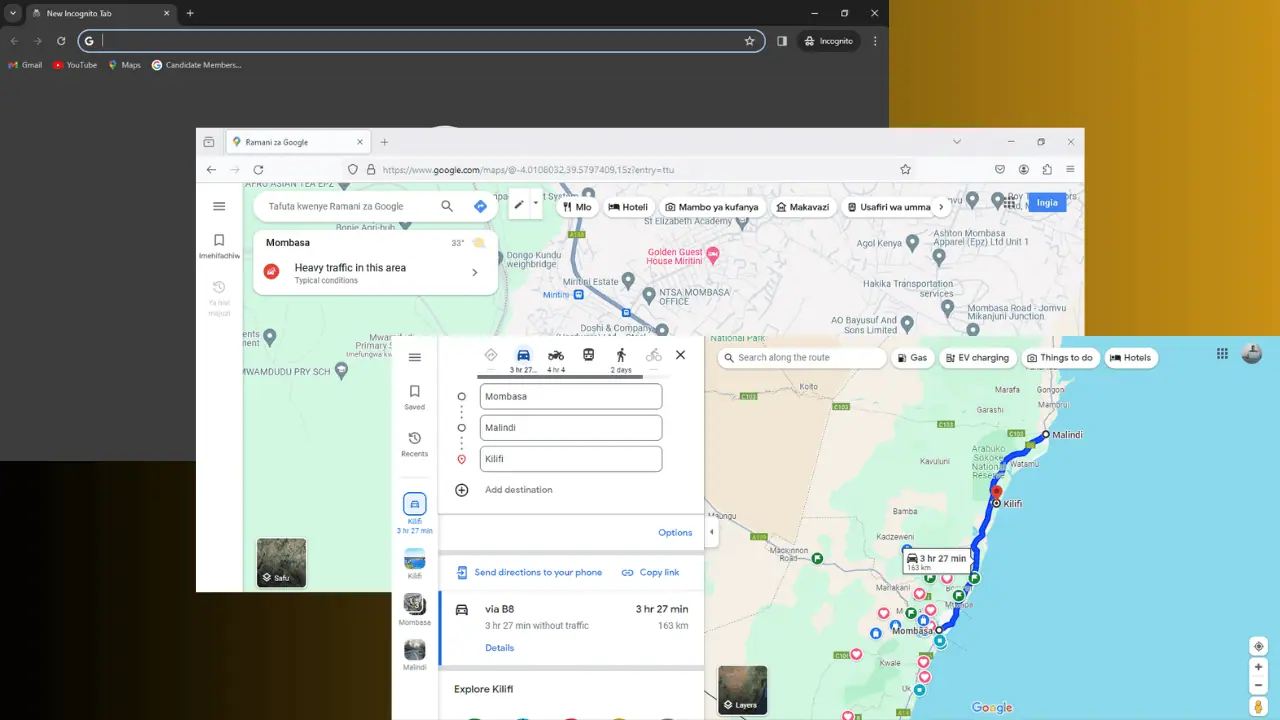

Dai un'occhiata all'immagine all'inizio dell'articolo. Google ora può interpretare lo "stare in piedi" come un'attività fisica e fornire risultati appropriati. Google ha affermato che BERT aiuterà la ricerca a comprendere meglio una ricerca su 10 negli Stati Uniti in inglese. Google porterà anche la tecnologia BERT in più lingue e regioni nei prossimi mesi.

Fonte: Google