Snowflake Arctic bangga sebagai "LLM terbaik untuk AI perusahaan". Klaim tersebut cukup besar

Anda dapat mencoba Snowflake di HuggingFace sekarang

2 menit Baca

Ditampilkan di

Baca halaman pengungkapan kami untuk mengetahui bagaimana Anda dapat membantu MSPoweruser mempertahankan tim editorial Baca lebih lanjut

Catatan kunci

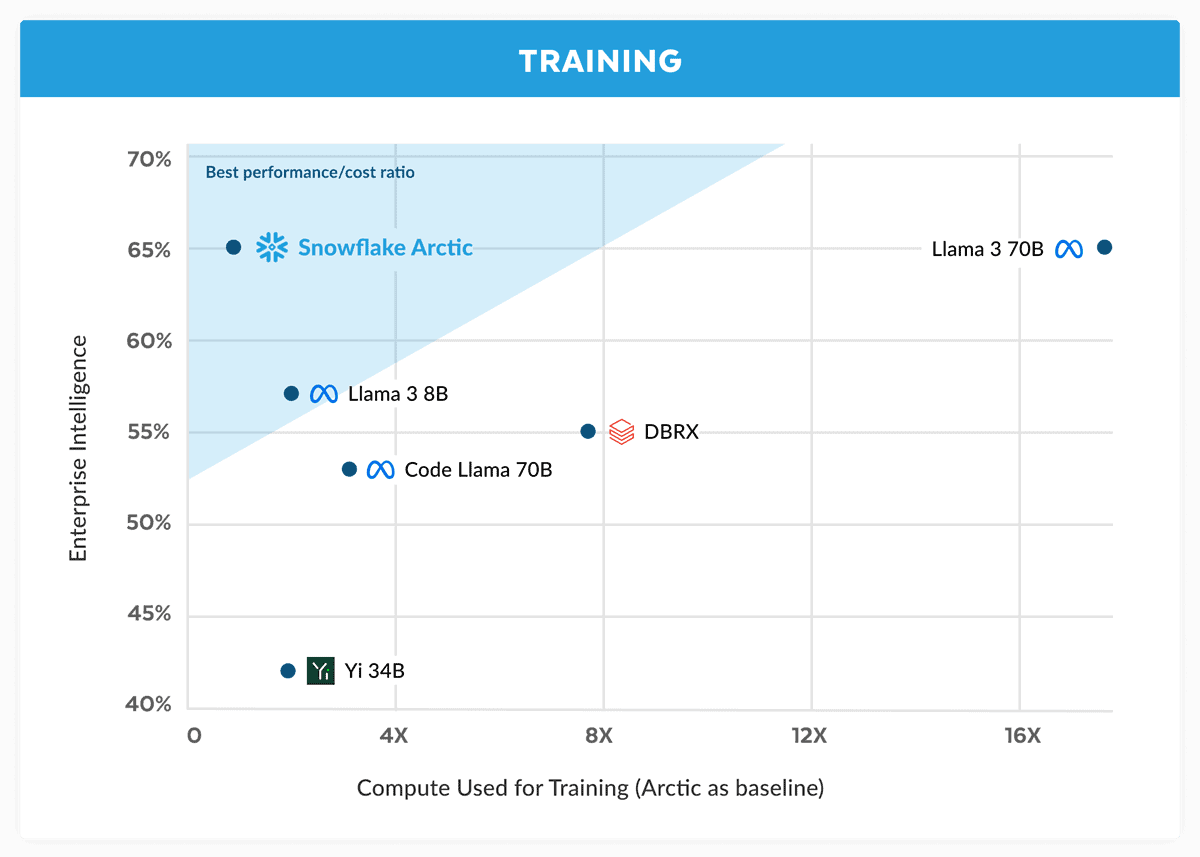

- Snowflake memperkenalkan Arctic, mengklaim bahwa ia menyaingi Llama 3 70B dengan biaya lebih rendah.

- Arctic unggul dalam tugas-tugas perusahaan seperti pengkodean dan pembuatan SQL.

- Menggunakan Dense-MoE Hybrid, Arctic mengoptimalkan efisiensi untuk berbagai ukuran batch.

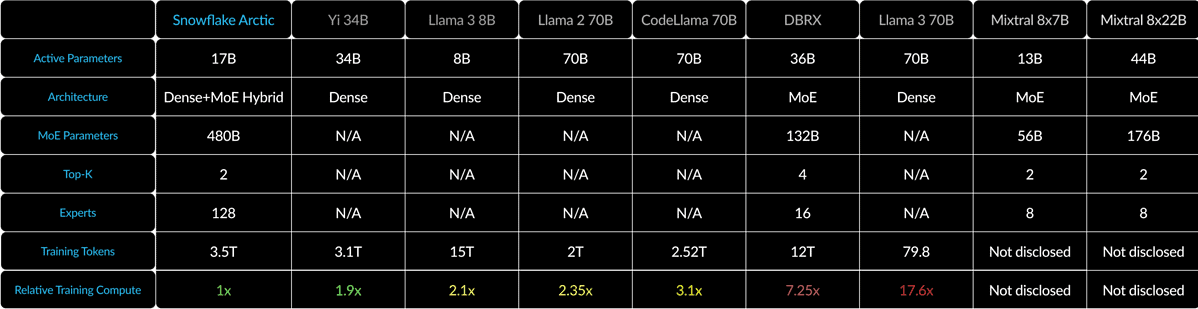

Snowflake, raksasa komputasi awan yang awalnya dibentuk oleh mantan ilmuwan Oracle, kini menantang pemain besar dalam perang AI. Perusahaan diluncurkan Kepingan salju Arktik, “LLM terbaik untuk AI perusahaan” terbarunya, dan mengklaim bahwa ini lebih baik daripada Llama 3 70B & lebih baik daripada varian 8B yang terakhir.

Dalam pengumumannya, Snowflake mengklaim bahwa model Arktik cocok dengan kinerja Llama 3 70B tetapi dengan persyaratan komputasi dan biaya yang lebih rendah. Ini disebut-sebut ideal untuk tugas intelijen perusahaan di berbagai bidang dan tolok ukur seperti pengkodean (HumanEval+ dan MBPP+ ), pembuatan SQL (Spider), dan mengikuti instruksi (IFEval).

Itu klaim yang besar, apalagi mengingat hal itu Lama 3 70B telah berkinerja baik melawan model besar lainnya seperti GPT-4 Turbo dan Claude 3 Opus dalam pengujian penting. Model Meta yang akan datang dilaporkan mendapat skor yang baik dalam tolok ukur seperti MMLU (untuk memahami mata pelajaran), GPQA (biologi, fisika, dan kimia, dan HumanEval (coding).

Snowflake Arctic memadukan transformator padat 10B dengan MLP MoE 128×3.66B menggunakan Hibrida Dense-MoE. Totalnya adalah 480 miliar parameter, namun hanya 17 miliar yang digunakan secara aktif, dipilih dengan gating 2 teratas.

Untuk ukuran batch kecil seperti 1, Arctic mengurangi pembacaan memori hingga 4x dibandingkan dengan Code-Llama 70B dan hingga 2.5x lebih sedikit dibandingkan Mixtral 8x22B. Namun, seiring dengan meningkatnya ukuran batch secara signifikan, Arktik menjadi terikat dengan komputasi. Ini menghasilkan komputasi 4x lebih sedikit dibandingkan CodeLlama 70B dan Llama 3 70B.

Anda dapat mencoba Snowflake Arctic MemelukWajah. Perusahaan juga berjanji bahwa model tersebut akan segera hadir di taman model lain seperti AWS, Microsoft Azure, Perplexity, dan banyak lagi.