Bagaimana cara menggunakan Obrolan dengan RTX, chatbot AI lokal dari NVIDIA?

6 menit Baca

Diperbarui pada

Baca halaman pengungkapan kami untuk mengetahui bagaimana Anda dapat membantu MSPoweruser mempertahankan tim editorial Baca lebih lanjut

Temukan dunia chatbot AI lokal dengan Ngobrol dengan RTX, solusi baru yang dikembangkan oleh Nvidia. Panduan ini memberdayakan pengguna untuk mengunduh, mengonfigurasi, dan memanfaatkan sepenuhnya potensi Obrolan dengan RTX, memfasilitasi interaksi dengan model AI cerdas secara offline, dan menggunakan data untuk memperkaya dialog. Oleh karena itu, ini menunjukkan kepada Anda cara menggunakan Obrolan dengan RTX.

Kami akan memandu Anda mengunduh, memasang, dan menggunakan Obrolan dengan RTX, baik dengan data Anda (file teks) maupun video YouTube, sehingga Anda dapat terlibat dalam memperkaya percakapan dan membuka wawasan berharga dari sumber offline Anda.

Prasyarat:

- Unit pemrosesan grafis (GPU) Nvidia RTX 30-series atau 40-series

- Setidaknya 100 gigabyte (GB) ruang disk kosong

- 16 gigabyte (GB) RAM sistem

- Sistem operasi Windows 11

Mengunduh Obrolan dengan RTX:

- Mulai pengunduhan: Download Ngobrol dengan penginstal RTX dari situs resmi Nvidia. File terkompresi ini berukuran sekitar 35GB, jadi pastikan koneksi internet yang andal dan waktu yang cukup untuk proses pengunduhan.

- Ekstrak isinya: Setelah pengunduhan selesai, klik kanan folder yang diunduh dan pilih “Ekstrak semua” untuk mendekompresi isinya.

- Jalankan penginstal: cari setup.exe file dalam folder yang diekstraksi dan lanjutkan instalasi dengan mengikuti petunjuk di layar.

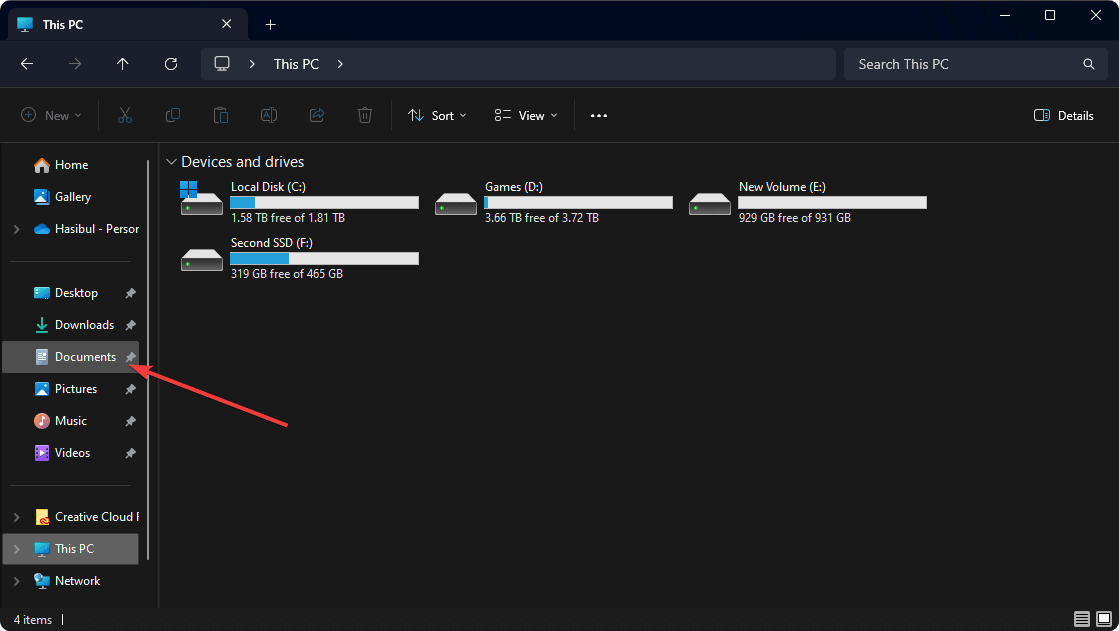

- Tentukan lokasi penyimpanan: Tentukan direktori dengan setidaknya 100 GB ruang yang tersedia untuk menyimpan Obrolan dengan RTX dan data terkait selama instalasi.

- Proses instalasi: Bersabarlah saat instalasi berlangsung, yang mungkin memerlukan waktu hingga 45 menit untuk menyelesaikannya. Sistem mungkin mengalami perlambatan sementara, khususnya selama konfigurasi model AI.

- Menginstal ulang jika terjadi kegagalan: Jika penginstalan mengalami kesalahan, cukup jalankan kembali penginstal dan pilih lokasi yang sama untuk penyimpanan data. Proses akan dilanjutkan dari titik interupsi.

- Luncurkan aplikasi: Setelah instalasi berhasil, pintasan desktop untuk Ngobrol dengan RTX akan dibuat, dan aplikasi akan diluncurkan secara otomatis di browser web default Anda. Ini adalah cara menggunakan Obrolan dengan RTX.

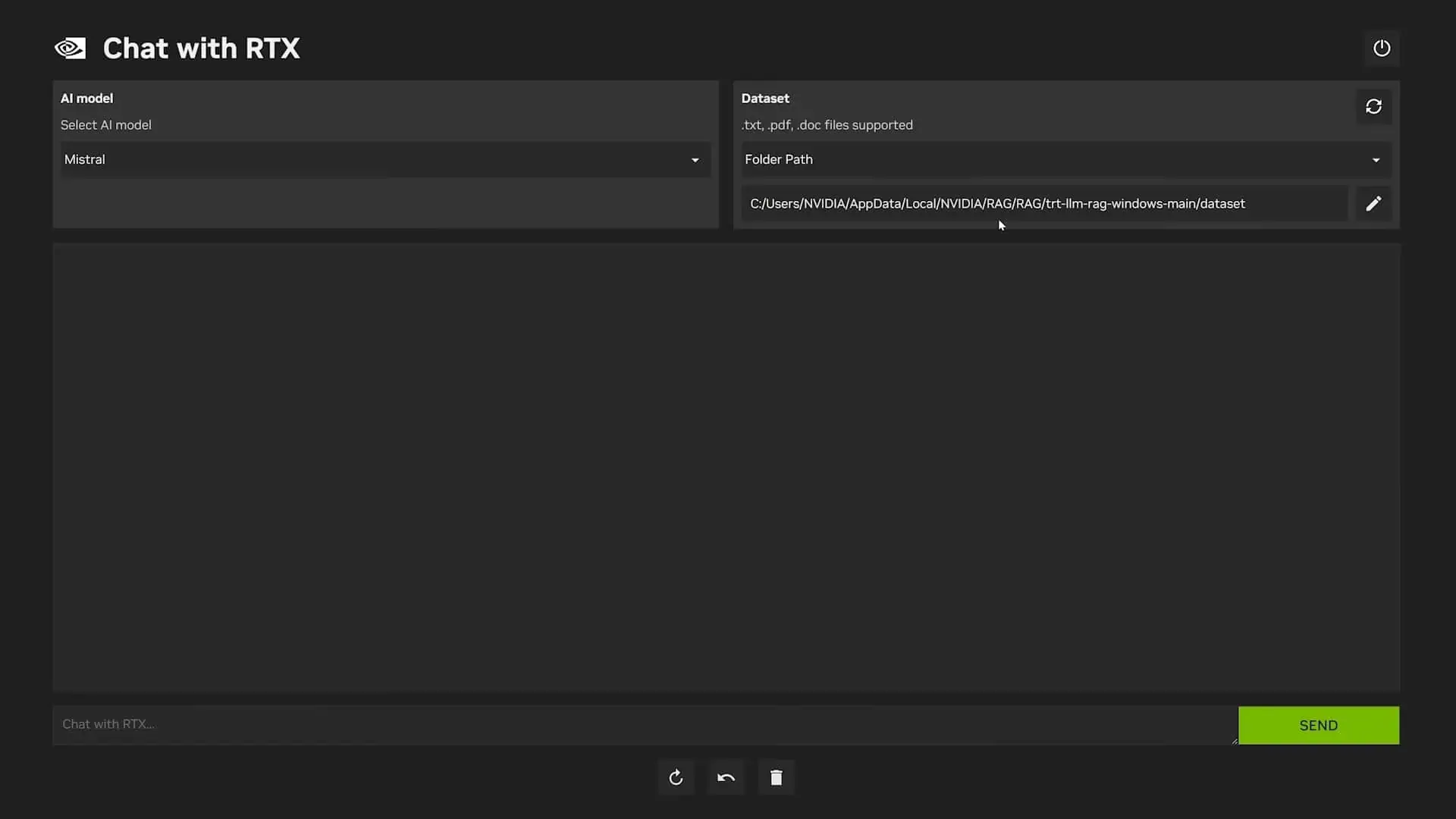

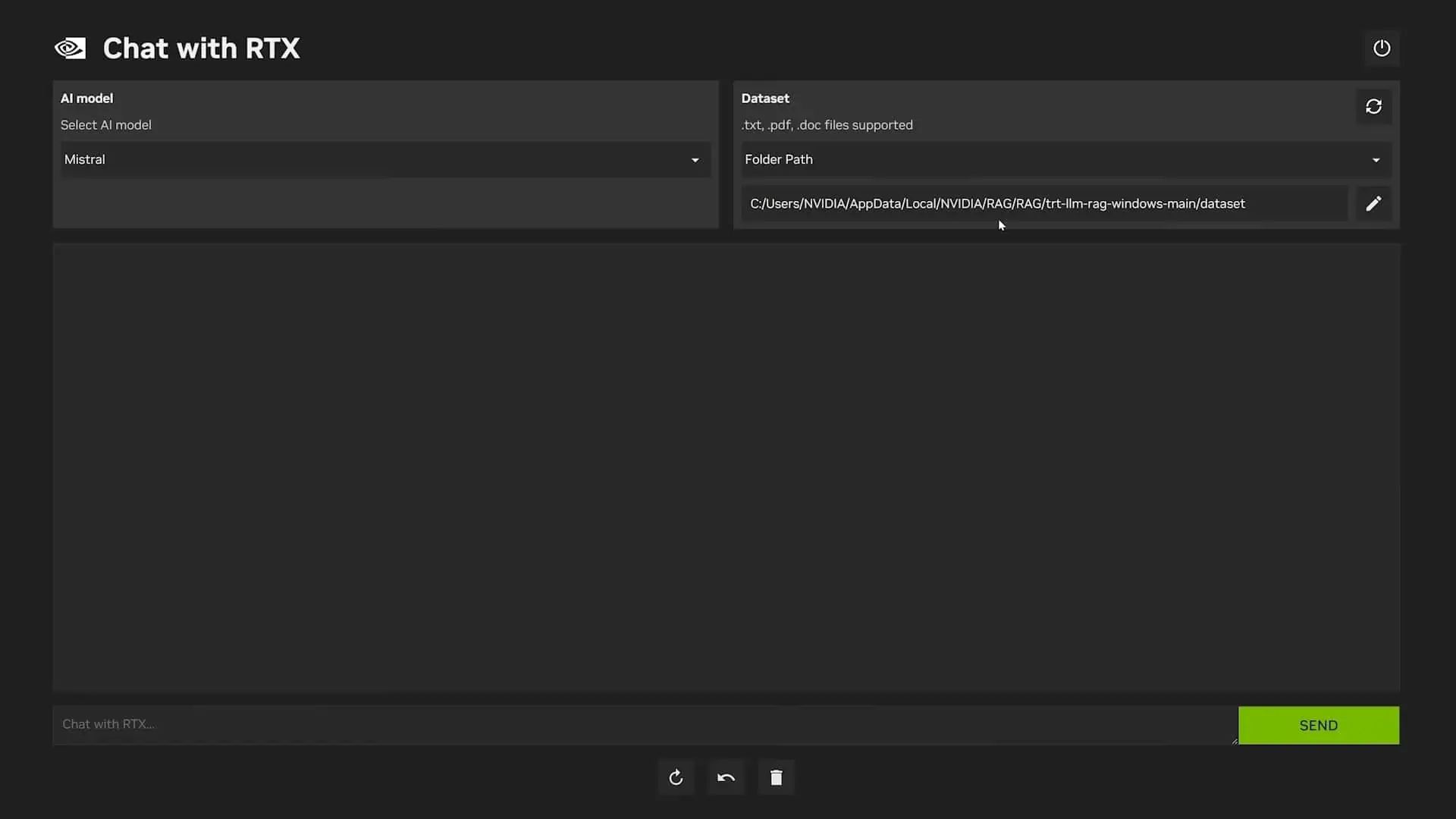

Meningkatkan Obrolan RTX dengan Data Anda

Buka seluruh spektrum Obrolan dengan kemampuan RTX dengan mengintegrasikan kumpulan data Anda ke dalam platform.

- Atur data Anda: Buat folder khusus untuk menyimpan data Anda, pastikan kompatibilitas dengan format file seperti .txt, .pdf, atau .doc.

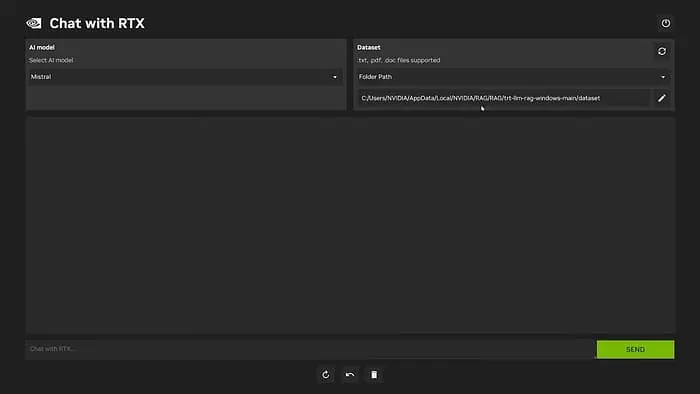

- Akses folder data: Launch Ngobrol dengan RTX dan klik ikon pena di bagian “Dataset” untuk memilih folder data Anda.

- Konfirmasi pilihan: Arahkan ke folder yang berisi data Anda dan konfirmasikan pilihan.

- Segarkan model: Segarkan model dalam Chat dengan RTX untuk memasukkan kumpulan data yang baru ditambahkan. Ulangi langkah ini setiap kali Anda menambahkan data baru atau beralih di antara kumpulan data yang berbeda.

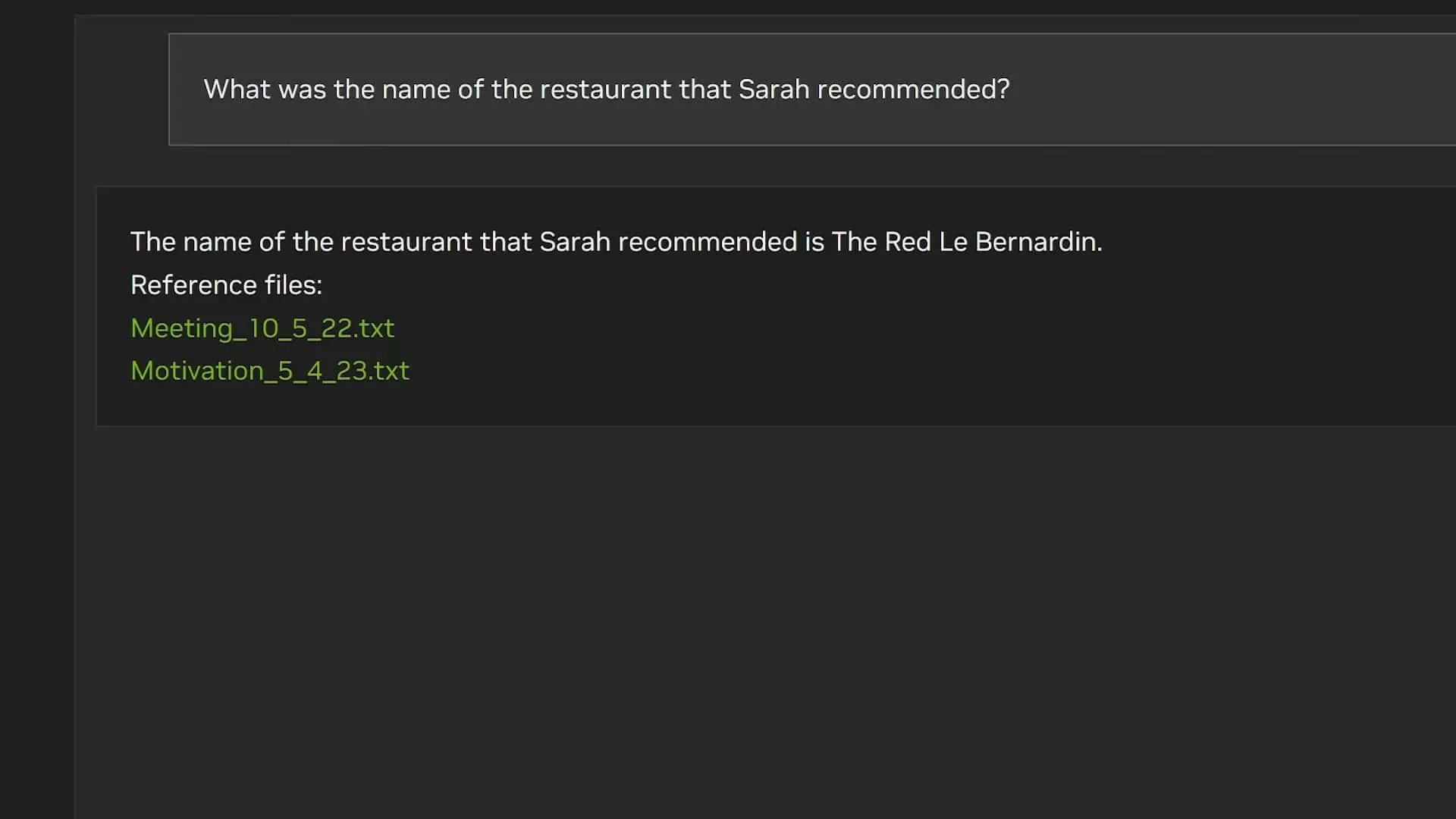

- Pilih model AI Anda: Pilih model AI yang diinginkan (misalnya, Llama 2 atau Mistral) dari opsi yang tersedia dan mulai pertanyaan Anda. Ingat, pertanyaan yang lebih spesifik cenderung menghasilkan jawaban yang lebih akurat.

Model AI adalah program komputer yang dilatih pada kumpulan data yang sangat besar untuk mengenali pola, membuat prediksi, atau melakukan tugas tertentu. Mereka seperti otak digital yang belajar dari data yang mereka peroleh dan menggunakan pengetahuan tersebut untuk mencapai berbagai tujuan. - Batasan kontekstual: Obrolan dengan RTX tidak mempertimbangkan konteks antar respons dan terkadang merujuk pada data yang salah.

- Penyelesaian masalah: Jika Anda mengalami masalah apa pun dengan Obrolan dengan RTX, hapus file “preferences.json” yang terletak di “

C:\Users\AppData\Local\NVIDIA\ChatWithRTX\RAG\trt-llm-rag-windows-main\config\preferences.json” dapat menyelesaikan masalah tersebut. Ini adalah cara menggunakan Obrolan dengan RTX

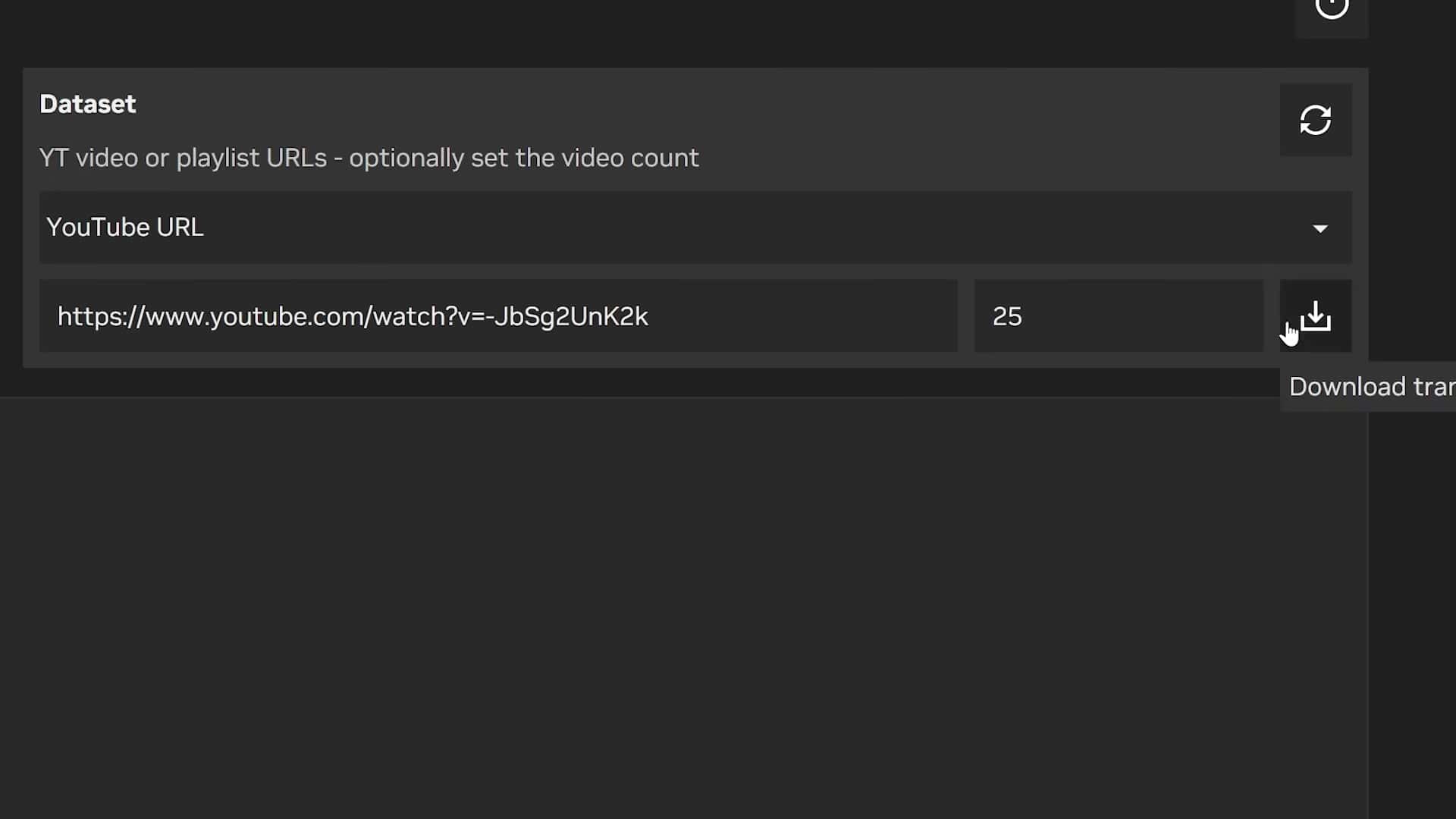

Cara menggunakan Obrolan dengan RTX dengan YouTube

Perluas fungsi Obrolan dengan RTX dengan menggabungkan video YouTube dan transkripnya yang sesuai.

- Pilih opsi YouTube: Dalam Obrolan dengan RTX, pilih opsi “YouTube” dari menu tarik-turun “Kumpulan Data”.

- Berikan tautan video: Tempelkan tautan ke video atau daftar putar YouTube dan tentukan jumlah maksimum transkrip yang ingin Anda unduh.

- Memulai pengunduhan: Mulailah proses pengunduhan dan tunggu transkrip diambil. Setelah selesai, segarkan kumpulan data.

- Terlibat dalam percakapan: Mulailah percakapan dengan Chat dengan RTX menggunakan pertanyaan spesifik berdasarkan transkrip video.

- Beralih set video: Untuk beralih ke kumpulan video lain, hapus transkrip lama secara manual melalui jendela Explorer yang dapat diakses dari dalam aplikasi. Ini adalah cara menggunakan Obrolan dengan RTX

Mengapa Anda harus menggunakan Obrolan dengan RTX?

- 1. Interaksi AI offline: Terlibat dengan model AI yang cerdas tanpa bergantung pada koneksi internet, memastikan privasi dan akses tanpa gangguan bahkan di lokasi terpencil.

- 2. Pembuatan Chatbot yang dipersonalisasi: Manfaatkan kumpulan data Anda (dokumen teks, video YouTube) untuk melatih dan mempersonalisasi Obrolan dengan RTX, menyesuaikan responsnya terhadap kebutuhan dan minat spesifik Anda.

- 3. Peningkatan privasi: Pertahankan kontrol penuh atas data Anda karena data tetap disimpan secara lokal di perangkat Anda, menghilangkan kekhawatiran tentang penyimpanan berbasis cloud dan potensi pelanggaran privasi.

- 4. Waktu respons lebih cepat: Manfaatkan kekuatan pemrosesan GPU Nvidia RTX Anda, memungkinkan Obrolan dengan RTX menghasilkan respons dengan cepat dan efisien, meminimalkan penundaan selama percakapan.

- 5. Potensi untuk beragam aplikasi: Jelajahi berbagai kasus penggunaan di luar percakapan biasa, seperti bantuan penelitian, ekstraksi informasi dari data pribadi, dan petunjuk menulis kreatif.

- 6. Pembelajaran dan Peningkatan Berkelanjutan: Tingkatkan Obrolan dengan kemampuan RTX dengan menambahkan kumpulan data baru dan menjelajahi model AI yang berbeda, sehingga mendorong pengalaman percakapan yang dipersonalisasi dan berkembang.

- 7. Aksesibilitas untuk Tugas Offline: Manfaatkan Obrolan dengan RTX untuk tugas yang memerlukan akses internet dalam skenario offline, seperti merangkum makalah penelitian yang diunduh atau membuat konten kreatif tanpa gangguan online.

- 8. Potensi penghematan biaya: Hilangkan kebutuhan biaya berlangganan yang terkait dengan layanan AI berbasis cloud, yang berpotensi mengurangi biaya dalam jangka panjang.

Secara keseluruhan, Chat dengan RTX menawarkan kombinasi unik antara fungsionalitas offline, privasi data, personalisasi, dan kemampuan pemrosesan yang canggih, menjadikannya pilihan menarik bagi pengguna yang mencari pengalaman chatbot AI yang serbaguna dan aman. Ini adalah panduan kami yang menunjukkan cara menggunakan Obrolan dengan RTX.