A Snowflake Arctic büszke arra, hogy a „legjobb LLM a vállalati mesterségesintelligencia számára”. Ez elég nagy állítás

Most kipróbálhatod a Snowflake-et a HuggingFace-en

2 perc olvas

Publikálva

Olvassa el közzétételi oldalunkat, hogy megtudja, hogyan segítheti az MSPowerusert a szerkesztői csapat fenntartásában Tovább

Főbb megjegyzések

- A Snowflake bemutatja az Arctic-ot, azt állítva, hogy alacsonyabb költségekkel vetekszik a Llama 3 70B-vel.

- Az Arctic kiemelkedő az olyan vállalati feladatokban, mint a kódolás és az SQL-generálás.

- A Dense-MoE hibrid használatával az Arctic optimalizálja a hatékonyságot a különféle tételméretekhez.

A Snowflake, egy felhő-számítástechnikai óriás, amelyet eredetileg az Oracle egykori tudósai alapítottak, most kihívja a nagy játékosokat az AI-háborúban. A cég elindult Hópehely sarkvidék, a legújabb „legjobb LLM vállalati mesterségesintelligencia számára”, és azt állította, hogy jobb, mint a Llama 3 70B, és jobb, mint az utóbbi 8B változata.

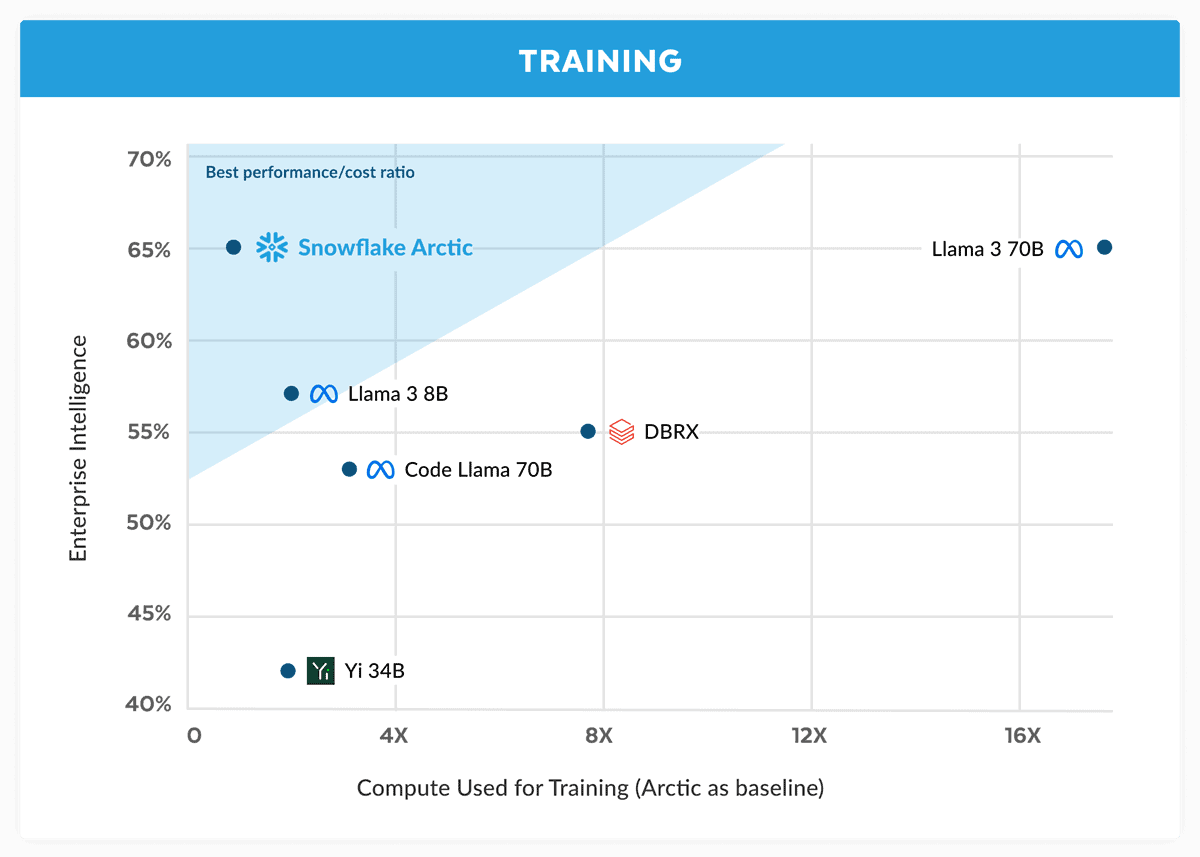

A Snowflake közleményében azt állítja, hogy az Arctic modell megfelel a Llama 3 70B teljesítményének, de alacsonyabb számítási követelményekkel és költségekkel. Ideálisnak tartják a vállalati intelligencia feladatokhoz olyan területeken és benchmarkokon, mint a kódolás (HumanEval+ és MBPP+ ), az SQL generálás (Spider) és az utasításkövetés (IFEval).

Ez nagy állítás, főleg ha ezt figyelembe vesszük Láma 3 70B a fontos teszteken jól teljesített más nagyobb modellekkel, mint például a GPT-4 Turbo és a Claude 3 Opus. A Meta készülő modellje állítólag jól teljesít olyan benchmarkokban, mint az MMLU (a tárgyak megértéséhez), a GPQA (biológia, fizika és kémia), valamint a HumanEval (kódolás).

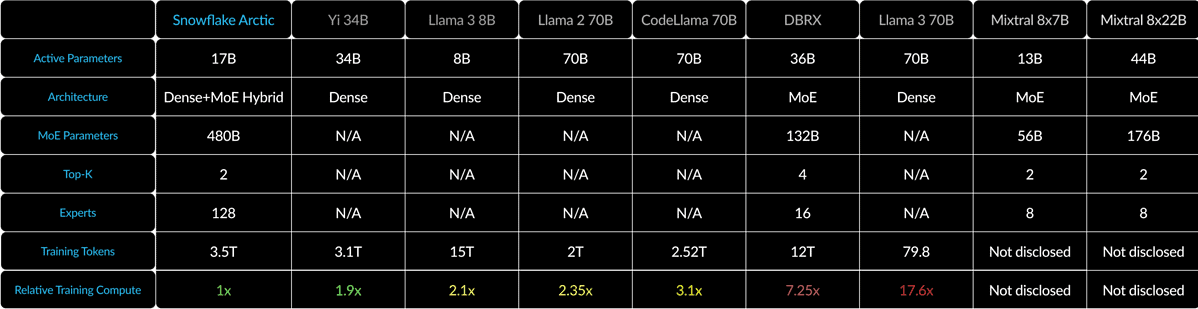

A Snowflake Arctic egy 10B sűrűségű transzformátort kever egy 128 × 3.66 B MoE MLP-vel egy Dense-MoE hibrid segítségével. Ez összesen 480B paramétert jelent, de csak 17B van aktívan felhasználva, top2 kapuzással választva.

Kis tételméreteknél, például 1, az Arctic akár 4-szeresére csökkenti a memóriaolvasást a Code-Llama 70B-hez képest, és akár 2.5-szer kevesebbet, mint a Mixtral 8x22B. De mivel a tételek mérete jelentősen megnő, az Arctic számításhoz kötött. Négyszer kevesebb számítást igényel, mint a CodeLlama 4B és a Llama 70 3B.

Felpróbálhatod a Snowflake Arctic-ot HuggingFace. A cég azt is ígéri, hogy a modell hamarosan más modellkertekbe is érkezik, mint például az AWS, a Microsoft Azure, a Perplexity és még sok más.