A Microsoft Research bemutatja a Splitwise-t, egy új technikát a GPU hatékonyságának növelésére a nagy nyelvű modelleknél

2 perc olvas

Publikálva

Olvassa el közzétételi oldalunkat, hogy megtudja, hogyan segítheti az MSPowerusert a szerkesztői csapat fenntartásában Tovább

Főbb megjegyzések

- A Splitwise áttörést jelent az LLM következtetések hatékonyságában és fenntarthatóságában.

- A prompt és a token fázisok szétválasztásával a Splitwise új lehetőségeket nyit meg a GPU-használatban, és lehetővé teszi a felhőszolgáltatók számára, hogy több lekérdezést gyorsabban kiszolgáljanak ugyanazon energiaköltségvetés mellett.

A nagy nyelvi modellek (LLM-ek) átalakítják a természetes nyelvi feldolgozás és a mesterséges intelligencia területét, lehetővé téve az olyan alkalmazásokat, mint a kódgenerálás, a párbeszédes ágensek és a szövegösszegzés. Ezek a modellek azonban jelentős kihívások elé állítják a felhőszolgáltatókat is, akiknek egyre több grafikus feldolgozó egységet (GPU) kell telepíteniük az LLM-következtetés iránti növekvő igény kielégítésére.

A probléma az, hogy a GPU-k nem csak drágák, hanem energiaéhesek is, és a működésükhöz szükséges villamosenergia-ellátás kapacitása korlátozott. Ennek eredményeként a felhőszolgáltatók gyakran szembesülnek azzal a dilemmával, hogy elutasítsák a felhasználói lekérdezéseket, vagy növeljék működési költségeiket és környezeti hatásaikat.

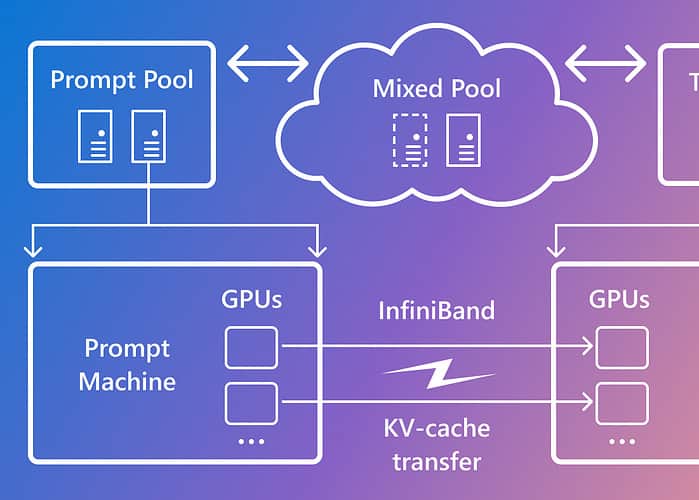

A probléma megoldására a Microsoft Azure kutatói kifejlesztettek egy új technikát, az úgynevezett Splitwise, melynek célja az LLM következtetések hatékonyabbá és fenntarthatóbbá tétele azáltal, hogy a számítást két különálló fázisra osztja, és azokat különböző gépekhez rendeli hozzá. Erről a technikáról részletesen a "Splitwise: Hatékony generatív LLM-következtetés fázisfelosztással" kutatási papír.

A Splitwise azon a megfigyelésen alapul, hogy az LLM következtetés két különböző jellemzőkkel rendelkező fázisból áll: a prompt fázisból és a token generálási fázisból. A prompt fázisban a modell párhuzamosan dolgozza fel a felhasználói bevitelt vagy promptot, sok GPU számítást használva. A tokengenerálási fázisban a modell minden kimeneti tokent szekvenciálisan generál, nagy GPU memória sávszélesség felhasználásával. Amellett, hogy a két LLM-következtetési fázist két különálló gépkészletre osztotta, a Microsoft egy harmadik gépkészletet is használt a prompt és token fázisok vegyes kötegeléséhez, amelyet dinamikusan méreteztek a valós idejű számítási igények alapján.

A Splitwise használatával a Microsoft a következőket tudta elérni:

- 1.4-szer nagyobb teljesítmény 20%-kal alacsonyabb költséggel, mint a jelenlegi tervek.

- 2.35-ször nagyobb átviteli sebesség azonos költség- és energiaköltségvetés mellett.

A Splitwise áttörést jelent az LLM következtetések hatékonyságában és fenntarthatóságában. A prompt és a token fázisok szétválasztásával a Splitwise új lehetőségeket nyit meg a GPU-használatban, és lehetővé teszi a felhőszolgáltatók számára, hogy több lekérdezést gyorsabban kiszolgáljanak ugyanazon energiaköltségvetés mellett. A Splitwise mostantól a vLLM része, és más keretrendszerekkel is megvalósítható. A Microsoft Azure kutatói azt tervezik, hogy folytatják az LLM-következtetés hatékonyabbá és fenntarthatóbbá tételén végzett munkát, és olyan személyre szabott gépkészleteket képzelnek el, amelyek maximális áteresztőképességet, alacsonyabb költségeket és energiahatékonyságot biztosítanak.