Snowflake Arctic est fier d'être le « meilleur LLM pour l'IA d'entreprise ». C'est une affirmation assez importante

Vous pouvez essayer Snowflake sur HuggingFace maintenant

2 minute. lis

Publié le

Lisez notre page de divulgation pour savoir comment vous pouvez aider MSPoweruser à soutenir l'équipe éditoriale En savoir plus

Notes clés

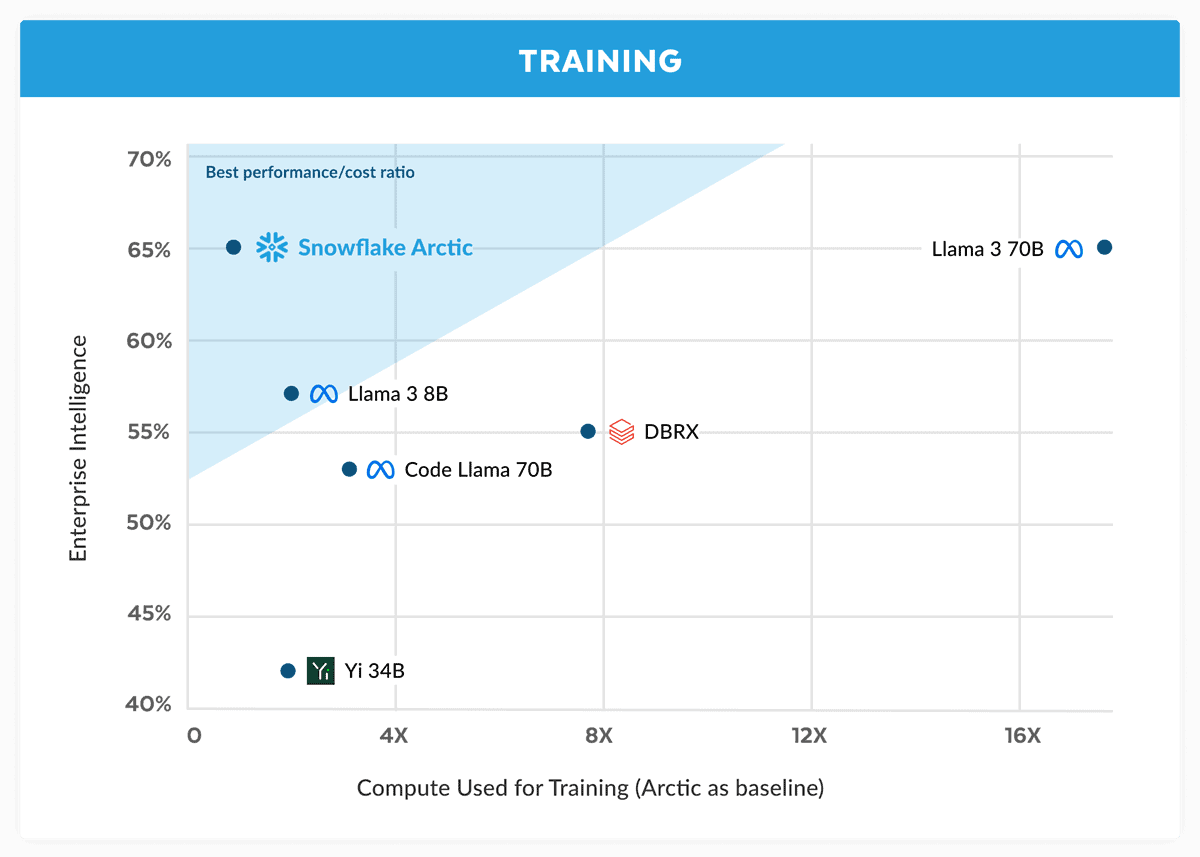

- Snowflake présente Arctic, affirmant qu'il rivalise avec le Llama 3 70B avec des coûts inférieurs.

- Arctic excelle dans les tâches d'entreprise telles que le codage et la génération SQL.

- À l’aide d’un hybride Dense-MoE, Arctic optimise l’efficacité pour différentes tailles de lots.

Snowflake, un géant du cloud computing formé initialement par d'anciens scientifiques d'Oracle, défie désormais les principaux acteurs de la guerre de l'IA. La société a lancé Flocon de neige Arctique, son dernier «meilleur LLM pour l'IA d'entreprise», et a affirmé qu'il était meilleur que Llama 3 70B et meilleur que la variante 8B de ce dernier.

Dans son annonce, Snowflake affirme que le modèle Arctic correspond aux performances du Llama 3 70B mais avec des exigences informatiques et des coûts inférieurs. Il est présenté comme idéal pour les tâches d'intelligence d'entreprise dans des domaines et des tests de référence tels que le codage (HumanEval+ et MBPP+), la génération SQL (Spider) et le suivi d'instructions (IFEval).

C'est une affirmation importante, d'autant plus que Lama 3 70B s'est bien comporté face à d'autres modèles majeurs comme le GPT-4 Turbo et le Claude 3 Opus lors de tests importants. Le prochain modèle de Meta aurait obtenu de bons résultats dans des critères tels que MMLU (pour la compréhension des sujets), GPQA (biologie, physique et chimie, et HumanEval (codage).

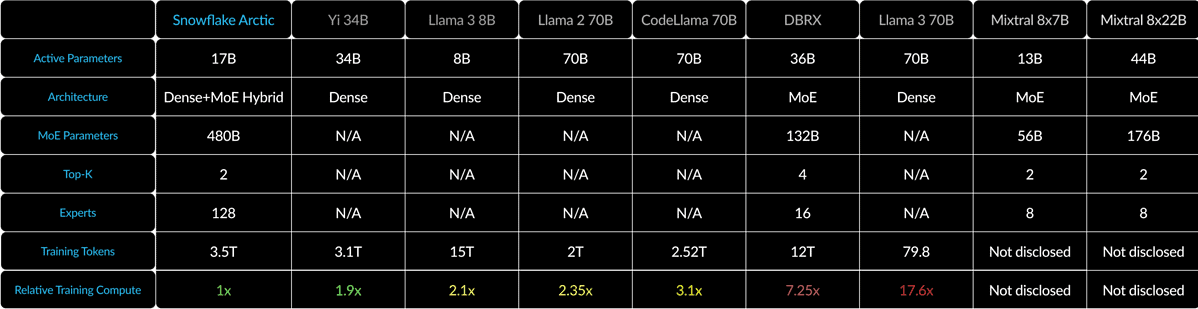

Snowflake Arctic mélange un transformateur dense 10B avec un MLP MoE 128 × 3.66B en utilisant un hybride Dense-MoE. Cela totalise 480 B de paramètres, mais seuls 17 B sont activement utilisés, choisis avec le top 2 du gate.

Pour les petits lots comme 1, Arctic réduit les lectures de mémoire jusqu'à 4 fois par rapport au Code-Llama 70B et jusqu'à 2.5 fois moins que Mixtral 8x22B. Mais à mesure que la taille des lots augmente considérablement, Arctic devient limité au calcul. Il nécessite 4 fois moins de calculs que CodeLlama 70B et Llama 3 70B.

Vous pouvez essayer Snowflake Arctic sur Étreindre. La société promet également que le modèle arrivera bientôt sur d'autres jardins modèles comme AWS, Microsoft Azure, Perplexity, etc.