NVIDIA et Google s'associent pour optimiser le nouveau Google Gemma sur les GPU NVIDIA

2 minute. lis

Publié le

Lisez notre page de divulgation pour savoir comment vous pouvez aider MSPoweruser à soutenir l'équipe éditoriale Plus d'informations

Notes clés

- Microsoft abandonne NVIDIA et Google les adopte pour optimiser son nouveau modèle d'IA.

- Le TensorRT-LLM de NVIDIA accélère le Gemma de Google sur diverses plates-formes, y compris les PC locaux.

- Les développeurs ont accès à des outils pour affiner et déployer Gemma pour des besoins spécifiques.

Alors que Microsoft a récemment annoncé sa décision d'abandonner les GPU NVIDIA au profit de ses puces personnalisées, Google a adopté l'approche inverse, en collaborant avec NVIDIA pour optimiser son nouveau modèle de langage léger, Gemma, sur les GPU NVIDIA.

Gemme est une modèle de langage léger développé par Google. Contrairement aux grands modèles de langage (LLM) traditionnels qui nécessitent d'immenses ressources de calcul, Gemma présente une taille plus petite (2 milliards et 7 milliards de versions de paramètres) tout en offrant des capacités impressionnantes.

Cette collaboration vise à améliorer considérablement l'accessibilité et les performances de Gemma, en le rendant plus rapide et plus largement disponible sur diverses plateformes.

Cette bibliothèque open source optimise l'inférence LLM, permettant des performances plus rapides sur les GPU NVIDIA dans les centres de données, les environnements cloud et même les ordinateurs personnels équipés de GPU NVIDIA RTX. La collaboration cible plus de 100 millions de GPU NVIDIA RTX dans le monde et les plates-formes cloud dotées des GPU H100 et H200 à venir.

La suite AI Enterprise de NVIDIA, comprenant le framework NeMo et TensorRT-LLM, permet aux développeurs d'affiner et de déployer Gemma pour des cas d'utilisation spécifiques.

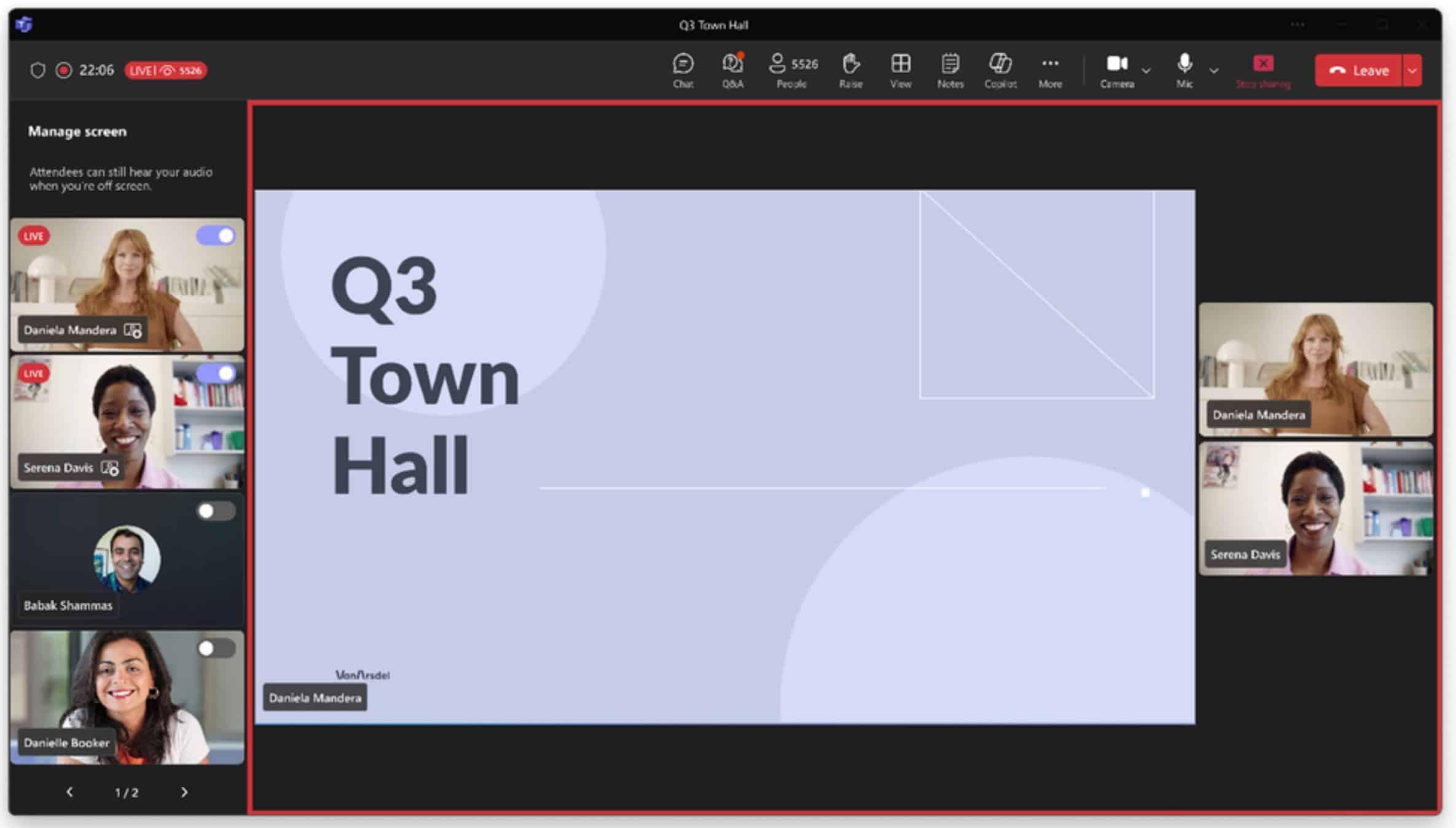

Les utilisateurs peuvent interagir directement avec Gemma via NVIDIA AI Playground et, bientôt, via la démo Chat with RTX, leur permettant de personnaliser les chatbots avec leurs données.

Avec Microsoft se distancie de NVIDIA, la décision de Google d'optimiser sa technologie sur les GPU NVIDIA suggère un renforcement potentiel de leur partenariat. Cela pourrait conduire à de nouvelles avancées en matière d’IA et de modélisation du langage, bénéficiant ainsi aux développeurs et aux utilisateurs.

De plus, se concentrer sur le traitement local via les GPU RTX permet aux utilisateurs de mieux contrôler leurs données et leur confidentialité, répondant potentiellement aux problèmes associés aux services LLM basés sur le cloud.

Plus ici.