Mikä on GPT-3 ja miten se vaikuttaa nykyiseen työhösi

3 min. lukea

Päivitetty

Lue ilmoitussivumme saadaksesi selville, kuinka voit auttaa MSPoweruseria ylläpitämään toimitustiimiä Lue lisää

GPT on lyhenne sanoista Generative Pre-training Transformer (GPT), kielimalli, jonka on kirjoittanut Alec Radford ja julkaissut vuonna 2018 OpenAI, Elon Musksin tekoälyn tutkimuslaboratorio. Se käyttää generatiivista kielen mallia (jossa kaksi hermoverkkoa täydentävät toisiaan kilpailemalla) ja pystyy hankkimaan tietoa maailmasta ja käsittelemään pitkän kantaman riippuvuuksia harjoittelemalla esikoulutusta erilaisista kirjoitetuista aineistoista, joissa on pitkiä vierekkäisiä tekstejä.

GPT-2 (Generative Pretrained Transformer 2) julkistettiin helmikuussa 2019, ja se on valvomaton muuntajakielimalli, joka on koulutettu 8 miljoonalle asiakirjalle yhteensä 40 Gt:n tekstistä Reddit-lähetysten kautta jaetuista artikkeleista. Elon Musk oli tunnetusti haluton julkaisemaan sitä, koska hän oli huolissaan siitä, että sitä voitaisiin käyttää roskapostin lähettämiseen sosiaalisiin verkostoihin valeuutisilla.

Toukokuussa 2020 OpenAI julkisti GPT-3:n (Generative Pretrained Transformer 3), mallin, joka sisältää kaksi suuruusluokkaa enemmän parametreja kuin GPT-2 (175 miljardia vs. 1.5 miljardia parametria) ja joka tarjoaa dramaattisen parannuksen GPT-2:een.

GPT-3 palauttaa tekstikehotteen yhteydessä tekstin ja yrittää vastata antamaasi kuviota. Voit "ohjelmoida" sen näyttämällä sille vain muutaman esimerkin siitä, mitä haluat sen tekevän, ja se toimittaa täydellisen artikkelin tai tarinan, kuten alla olevan tekstin, jonka on kirjoittanut kokonaan GPT-3.

GPT-3 saavuttaa vahvan suorituskyvyn monissa NLP-tietojoukoissa, mukaan lukien käännös-, kysymysvastaus- ja sulkemistehtävät sekä useat tehtävät, jotka edellyttävät nopeaa päättelyä tai toimialueen mukauttamista, kuten sanojen salauksen purkamista, käyttämällä uutta sanaa lausetta tai 3-numeroista aritmetiikkaa. GPT-3 voi luoda näytteitä uutisartikkeleista, joita arvioijien on vaikea erottaa ihmisten kirjoittamista artikkeleista.

Viimeinen sovellus on aina huolestuttanut OpenAI:ta. GPT-3 on tällä hetkellä saatavilla avoimena betaversiona, ja maksullisen yksityisen betaversion odotetaan olevan saatavilla myöhemmin. OpenAI ilmoitti lopettavansa API-käytön ilmeisen haitallisten käyttötapausten, kuten häirinnän, roskapostin, radikalisoitumisen tai astroturfingin, vuoksi.

Vaikka ilmeisimmin uhanalaisin väestö on kirjallista työtä tuottavat, kuten käsikirjoittajat, tekoälykehittäjät ovat jo löytäneet yllättäviä sovelluksia, kuten GPT-3:n käyttämisen koodin kirjoittamiseen.

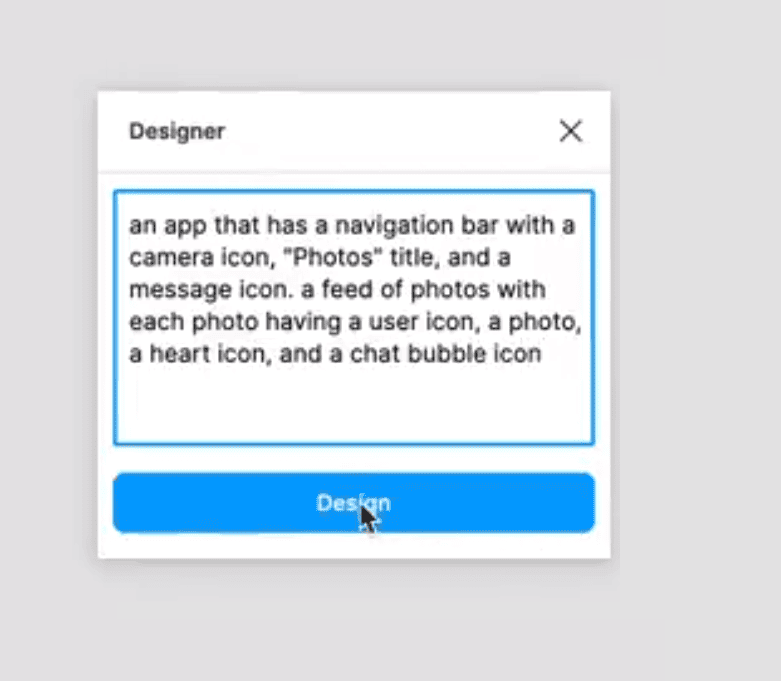

Esimerkiksi Sharif Shameem kirjoitti asettelugeneraattorin, jossa kuvailet pelkällä tekstillä mitä haluat, ja malli luo sopivan koodin.

Tämä on mielen puhaltaa.

GPT-3: n avulla rakensin asettelugeneraattorin, jossa kuvailet vain haluamasi asettelun, ja se luo sinulle JSX-koodin.

MITÄ pic.twitter.com/w8JkrZO4lk

- Sharif Shameem (@sharifshameem) Heinäkuu 13, 2020

Jordan Singer loi vastaavasti Figma-laajennuksen, jonka avulla voidaan luoda sovelluksia pelkillä tekstikuvauksilla.

Tämä muuttaa kaiken. ?

GPT-3:lla rakensin sinulle Figma-laajennuksen.

Kutsun sitä "suunnittelijaksi" pic.twitter.com/OzW1sKNLEC

- jordanialainen laulaja (@jsngr) Heinäkuu 18, 2020

Sitä voidaan käyttää jopa astman diagnosointiin ja lääkkeiden määräämiseen.

So @OpenAI ovat antaneet minulle varhaisen pääsyn työkaluun, jonka avulla kehittäjät voivat käyttää periaatteessa kaikkien aikojen tehokkainta tekstigeneraattoria. Ajattelin testata sitä esittämällä lääketieteellisen kysymyksen. Lihavoitu teksti on tekoälyn luoma teksti. Uskomatonta… (1/2) pic.twitter.com/4bGfpI09CL

- Qasim Munye (@qasimmunye) Heinäkuu 2, 2020

Muut sovellukset ovat hakukone tai jonkinlainen oraakkeli, ja niitä voidaan jopa käyttää selittämään ja laajentamaan vaikeita käsitteitä.

Tein täysin toimivan hakukoneen GPT3:n päälle.

Jokaiselle mielivaltaiselle kyselylle se palauttaa tarkan vastauksen JA vastaavan URL-osoitteen.

Katso koko video. Se on HYVIN hyvää.

CC: @gdb @npew @gwern pic.twitter.com/9ismj62w6l

— Paras Chopra (@paraschopra) Heinäkuu 19, 2020

Vaikka näyttää siltä, että tämä lähestymistapa saattaa johtaa suoraan yleiseen tekoälyyn, joka pystyy ymmärtämään, järkeilemään ja keskustelemaan kuin ihminen, OpenAI varoittaa, että he ovat saattaneet törmätä perustavanlaatuisiin skaalausongelmiin, sillä GPT-3 vaatii useita tuhansia petaflopsia/s-päivän laskentaa. , verrattuna kymmeniin petaflop/s-päiviin koko GPT-2:lla. Kun olemme lähempänä, näyttää siltä, että läpimurto, joka tekee kaikista työpaikoistamme vanhentuneita, on vielä kaukana.

Lue lisää GPT-3:sta GitHubissa täällä.