تاثیر هوش مصنوعی و دیپ فیک بر واقعیت و آینده

5 دقیقه خواندن

به روز شده در

صفحه افشای ما را بخوانید تا بدانید چگونه می توانید به MSPoweruser کمک کنید تا تیم تحریریه را حفظ کند ادامه مطلب

با مشارکت ExpressVPN

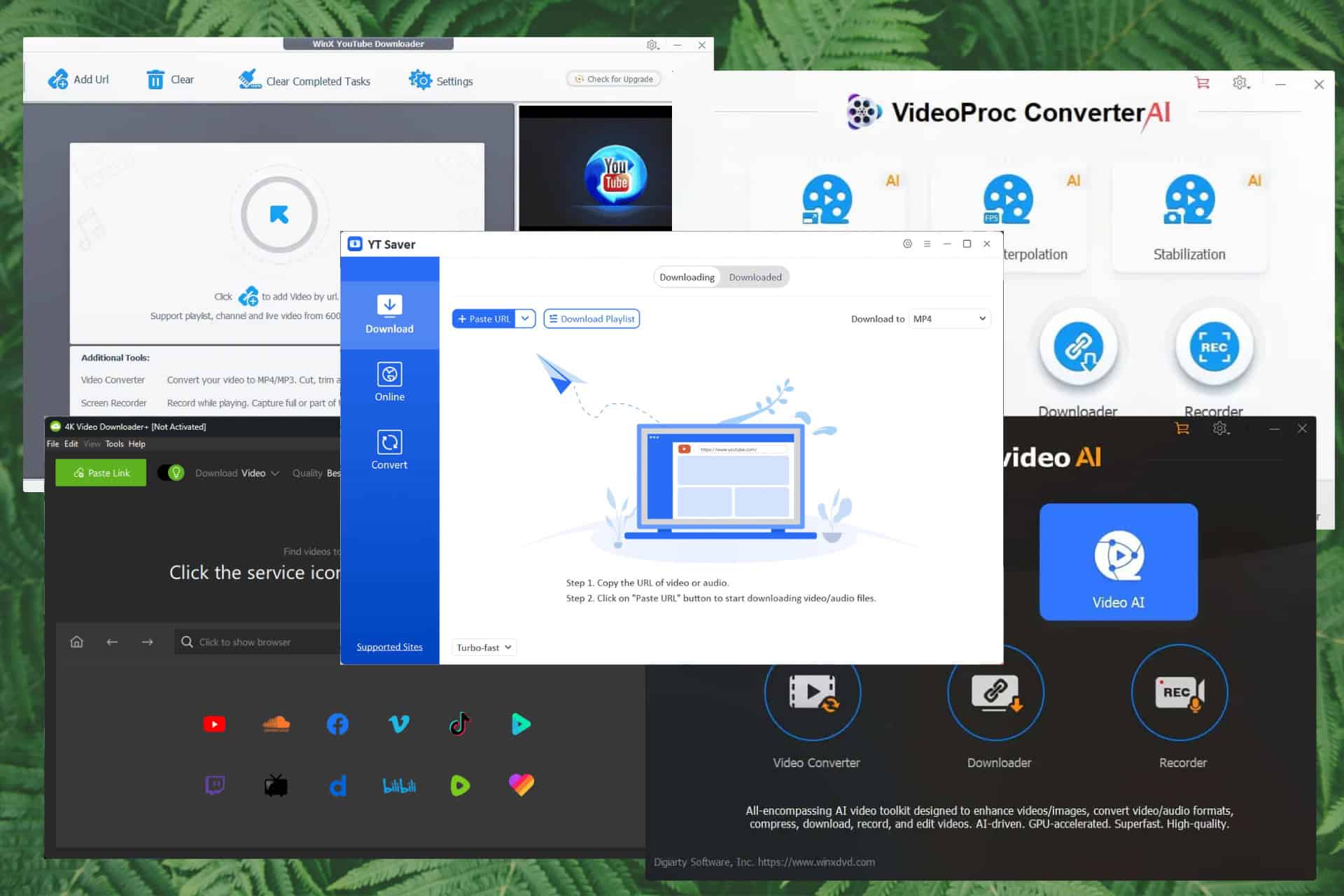

پیشرفت های اخیر در هوش مصنوعی تغییرات قابل توجهی را در زندگی مردان کنونی ایجاد کرده است. امروز، ما میتوانیم ببینیم که هوش مصنوعی چگونه میتواند بدون دردسر کدنویسی، مقالهنویسی و – مهمتر از همه – تولید محتوا را در عرض چند ثانیه انجام دهد. با این حال، همین قابلیت های چشمگیر، نفرین خود هوش مصنوعی است. مطابق با ارائه دهندگان VPN، بسیاری از هوش مصنوعی برای تولید رسانه های مصنوعی برای اطلاعات نادرست استفاده می کنند و دیپ فیک ها اکنون مانند آتش سوزی در سراسر جهان شروع به انتشار کرده اند.

کارشناسان دهههاست که هوش مصنوعی را آزمایش کردهاند، اما تلاش بزرگ اخیر مایکروسافت برای این فناوری، علاقه صنعت را برای سرمایهگذاری بیشتر در چنین خلاقیتهایی برانگیخت. درست بعد از رونمایی از آن بینگ مجهز به ChatGPT موتور جستجو، گوگل با استفاده از آن پاسخ داد شاعر. با این حال، برخلاف رقیب خود، گوگل همچنان محدودیت سختی را برای دسترسی آزمایشی بارد اعمال می کند، و کارشناسان حدس می زنند که این به دلیل ترس این شرکت از کارهایی است که هوش مصنوعی می تواند تحت دستان اشتباه انجام دهد.

این در مورد سایر محصولات فناوری هوش مصنوعی در حال توسعه صادق است. به عنوان مثال، مدل زبان VALL-E مایکروسافت، که در حال حاضر در دسترس عموم نیست، می تواند صدا و احساسات یک فرد را برای ترکیب سخنرانی های شخصی تقلید کند. این فقط به ضبط سه ثانیه ای به عنوان پیام صوتی خود نیاز دارد، اما می تواند با استفاده از صدای گوینده اصلی، پیام متفاوتی تولید کند.

در حالی که عموم مردم هنوز نمی توانند به خلاقیت های ذکر شده در بالا دسترسی داشته باشند، آنها قبلاً همتاهای ارائه شده توسط شرکت های فناوری کوچک دارند. این نه تنها به کاربران عادی بلکه به عوامل مخرب نیز اجازه می دهد تا از ابزارها به هر شکلی که می خواهند استفاده کنند. با این اوصاف، دیگر جای تعجب نیست که اخیراً گزارش های مختلفی در مورد فریب خوردن و کلاهبرداری افراد با کمک هوش مصنوعی منتشر شده است.

این گزارشها به طور خاص بر استفاده از صداهای تولید شده توسط هوش مصنوعی با تقلید از قربانیان خود تأکید داشتند. در یک داستان به اشتراک گذاشته شده با خودی کسب و کار گزارش شده است که در این ماه، مادری از سوی فردی که ادعا می کرد آدم ربا است تماس گرفت و خواستار باج 50,000 دلاری برای دختر 15 ساله خود شد. در توصیف تماس دریافتی، مادر گفت که این صدای "100%" دخترش بود.

«این کاملاً صدای او بود. عطف او بود. این طوری بود که او می توانست گریه کند. من حتی یک ثانیه هم شک نکردم که او بوده است.

همان حادثه مربوط به صدای هوش مصنوعی توسط زوجی از کانادا تجربه شد که متأسفانه 21,000 دلار از یک کلاهبردار تلفنی ضرر کردند. مطابق با واشنگتن پستکلاهبردار با استفاده از صدای تولید شده توسط هوش مصنوعی به عنوان یک وکیل و پسر زوج ظاهر شد و گفت که پس از ادعای اینکه پسر یک دیپلمات را در یک تصادف رانندگی کشته است، از این پول برای هزینه های قانونی استفاده می شود.

به غیر از صداها، سایر اشکال رسانه های مولد تولید شده توسط هوش مصنوعی نیز می توانند هر کسی را فریب دهند - به عنوان مثال، تصاویر جعلی و ویدیوهای عمیق جعلی. در حالی که هیچ گزارشی وجود ندارد که نشان دهد کلاهبرداران از آنها برای منافع مالی استفاده می کنند، تأثیر آنها می تواند برای عموم مردم گسترده باشد. اخیراً تصاویری از شخصیتهای مشهور که توسط هوش مصنوعی تولید شدهاند در وب منتشر شده است. برخی از آنها شامل عکسهایی هستند که پاپ فرانسیس را با یک ژاکت پفی شیک، رئیسجمهور سابق دونالد ترامپ در حال دستگیری، و ایلان ماسک که دست رقیب خود و مدیر عامل جنرال موتورز، مری بارا را در یک قرار میگیرد، نشان میدهد. در همین حال، در مارس 2022، ویدئویی از ولودیمیر زلنسکی، رئیسجمهور اوکراین منتشر شد که از شهروندان اوکراینی میخواست خود را به روسیه تسلیم کنند.

اگرچه این مواد به سرعت جعلی شناخته شدند، اما حضور آنها به طور غیرقابل انکاری افکار عمومی را فریب داد و باعث سردرگمی موقت بسیاری شد. حتی مدل و نویسنده CHRISSY Teigen به قربانی عکس های پاپ شد. با این حال، تأثیر چنین رسانههای مصنوعی میتواند جدیتر باشد، زیرا هوش مصنوعی همچنان در حال توسعه است، بهویژه در این زمانها که شرکتهای فناوری بیشتر میلیاردها دلار هزینه میکنند تا خلق بینقص هوش مصنوعی را خلق کنند. وقتی آن زمان فرا رسید، میتوان از هوش مصنوعی برای تحریف واقعیتی که همه میدانند استفاده کرد، که غیرممکن نیست. حتی بیشتر از آن، حتی میتوان از آن برای کنترل و تأثیرگذاری بر مردم استفاده کرد که منجر به مسائل سیاسی، اجتماعی و اخلاقی متفاوتی در سراسر جهان میشود.

این موضوع در یک ویدیوی عمیق جعلی در جریان انتخابات میان دوره ای 2018 که باراک اوباما را در حال بدگویی از دونالد ترامپ نشان می دهد، مشهود است. این محتوا در ابتدا قصد داشت تا به دنیای آنلاین در مورد خطرات اخبار جعلی در وب هشدار دهد، اما دوباره برگشت. این امر باعث خشم چند تن از حامیان ترامپ شد و به طور ناخواسته به تصویر افراد استفاده شده در مطالب آسیب رساند.

حال، تأثیر چنین رسانه های مولد را تصور کنید اگر به طور خاص طراحی شده باشند تاثیر گذاشتن و دستکاری افکار و تبلیغ برای عموم مردم را ترویج کند. نتایج می تواند شدید باشد. این امر می تواند به طور خاص در کشورهایی که رسانه ها و اطلاعات توسط دولت های محدود کننده سانسور می شوند، مانند بلاروس، چین، مصر، روسیه، ایران، کره شمالی، ترکمنستان، امارات متحده عربی، اوگاندا، عراق، ترکیه، عمان و سایر کشورهای عمدتاً اسلامی صادق باشد. . برخی از VPN ها برای دسترسی به محتوا، وب سایت ها و سرویس های قفل شده جغرافیایی برای به روز ماندن به استفاده از VPN متوسل می شوند. با این حال، دسترسی به VPN به طور کامل در این مکان ها امکان پذیر نیست زیرا آنها دور زدن سانسور اینترنت و حتی وب سایت های مرتبط با خدمات VPN را مسدود کرده اند. با این کار، میتوانید آینده چنین مناطقی با دسترسی محدود به اخبار بینالمللی را تصور کنید و دولت آنها این قدرت را داشته باشد که چه محتوای آنلاین اجازه دهد. سپس، امکان یک هوش مصنوعی تولید کننده محتوای بی عیب و نقص را در آینده اضافه کنید و تشخیص اینکه چه چیزی درست است و چه چیزی غیرواقعی است برای عموم دشوارتر خواهد بود.

گروه های صنعتی و شرکت های فناوری هوش مصنوعی در حال حاضر در حال حرکت برای ترسیم خط مشی هایی هستند که استفاده از ابزارهای هوش مصنوعی را هدایت می کند. به عنوان مثال، مشارکت در زمینه هوش مصنوعی، توصیه هایی را برای موسسات و افرادی که ابزارهای رسانه مصنوعی می سازند یا به سادگی برای کسانی که چنین موادی را توزیع می کنند، ارائه می دهد. با این حال، شرکتهای خصوصی و سازمانهای غیرانتفاعی تنها مورد نیاز در اینجا نیستند. قانونگذاران همچنین باید مجموعه مشخصی از قوانین را ایجاد کنند که سازندگان هوش مصنوعی و کاربران نهایی مجبور به رعایت آنها شوند. با این وجود، آیا این قوانین آینده برای مهار قدرت هوش مصنوعی و جلوگیری از سوء استفاده افراد از آن به اندازه کافی کارآمد خواهند بود؟ ما باید به زودی آن را ببینیم.