مایکروسافت خانواده مدل های Phi-3 را معرفی می کند که عملکرد بهتری نسبت به سایر مدل های هم رده خود دارند

2 دقیقه خواندن

منتشر شده در

صفحه افشای ما را بخوانید تا بدانید چگونه می توانید به MSPoweruser کمک کنید تا تیم تحریریه را حفظ کند ادامه مطلب

در دسامبر 2023، مایکروسافت منتشر شد فی-2 مدلی با 2.7 میلیارد پارامتر که عملکردی پیشرفته را در بین مدل های زبان پایه با کمتر از 13 میلیارد پارامتر ارائه می دهد. در چهار ماه گذشته، چندین مدل دیگر که عرضه شدند عملکرد بهتری نسبت به Phi-2 داشتند. اخیراً متا خانواده مدلهای Llama-3 را منتشر کرد که عملکرد بهتری نسبت به مدلهای منبع باز منتشر شده قبلی داشت.

شب گذشته، مایکروسافت ریسرچ از طریق خانواده مدل های Phi-3 را معرفی کرد یک گزارش فنی. سه مدل در خانواده Phi-3 وجود دارد:

- phi-3-mini (3.8B)

- phi-3-small (7B)

- phi-3-medium (14B)

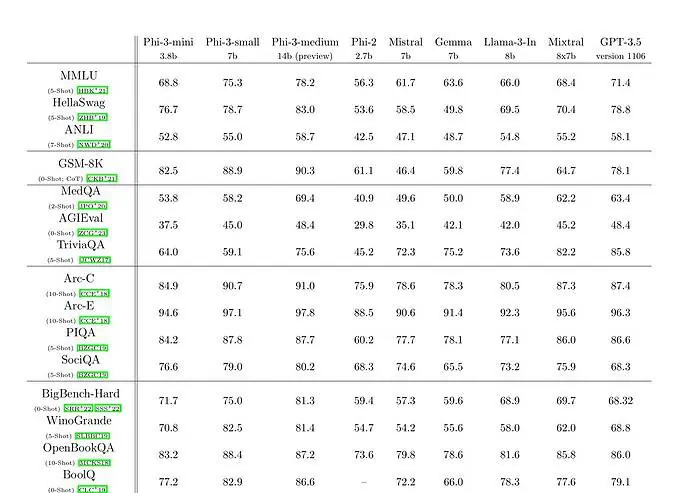

Phi-3-mini با مدل زبان 3.8 میلیارد پارامتری بر روی 3.3 تریلیون توکن آموزش داده شده است. طبق بنچمارکها، Phi-3-mini از Mixtral 8x7B و GPT-3.5 عبور میکند. مایکروسافت ادعا میکند که این مدل به اندازهای کوچک است که میتوان آن را روی گوشی نصب کرد. مایکروسافت از نسخه بزرگشده مجموعه داده استفاده کرد که برای phi-2 استفاده میشد، که از دادههای وب به شدت فیلتر شده و دادههای مصنوعی تشکیل شده بود. طبق نتایج بنچمارک مایکروسافت در مقاله فنی، phi-3-small و phi-3-medium به ترتیب به امتیاز MMLU چشمگیر 75.3 و 78.2 دست می یابند.

از نظر قابلیتهای LLM، در حالی که مدل Phi-3-mini به سطحی مشابه از درک زبان و توانایی استدلال مانند مدلهای بسیار بزرگتر دست مییابد، هنوز اساساً به دلیل اندازه آن برای کارهای خاص محدود است. این مدل به سادگی ظرفیت ذخیره دانش واقعی گسترده را ندارد، که به عنوان مثال، با عملکرد پایین در TriviaQA قابل مشاهده است. با این حال، ما معتقدیم که این ضعف را می توان با تقویت با یک موتور جستجو برطرف کرد.