Microsoft ayuda a los autos autónomos a conocer sus limitaciones

2 minuto. leer

Publicado el

Lea nuestra página de divulgación para descubrir cómo puede ayudar a MSPoweruser a sostener el equipo editorial. Leer más

La ignorancia es felicidad y, a menudo, son los más ignorantes los que toman las decisiones más seguras, sin sentirse abrumados por el conocimiento de que podrían estar equivocados.

En muchas situaciones, todo esto está bien, pero en el nivel actual de desarrollo de automóviles autónomos, tener un Tesla chocando con confianza contra un camión de bomberos o una camioneta blanca (ambos sucedieron) puede ser bastante peligroso.

El problema es que los automóviles autónomos son lo suficientemente inteligentes como para conducir automóviles, pero no para saber cuándo están entrando en una situación fuera de su nivel de confianza y capacidad.

Microsoft Research ha trabajado con el MIT para ayudar a los automóviles a saber exactamente cuándo las situaciones son ambiguas.

Como señala la noticia del MIT, una sola situación puede recibir muchas señales diferentes, porque el sistema percibe muchas situaciones como idénticas. Por ejemplo, un automóvil autónomo puede haber cruzado junto a un automóvil grande muchas veces sin reducir la velocidad ni detenerse. Pero, en solo un caso, pasa una ambulancia, que parece exactamente igual para el sistema. El automóvil autónomo no se detiene y recibe una señal de retroalimentación de que el sistema tomó una acción inaceptable. Debido a que la circunstancia inusual es que los autos raros pueden aprender a ignorarlos, cuando siguen siendo importantes a pesar de ser raros.

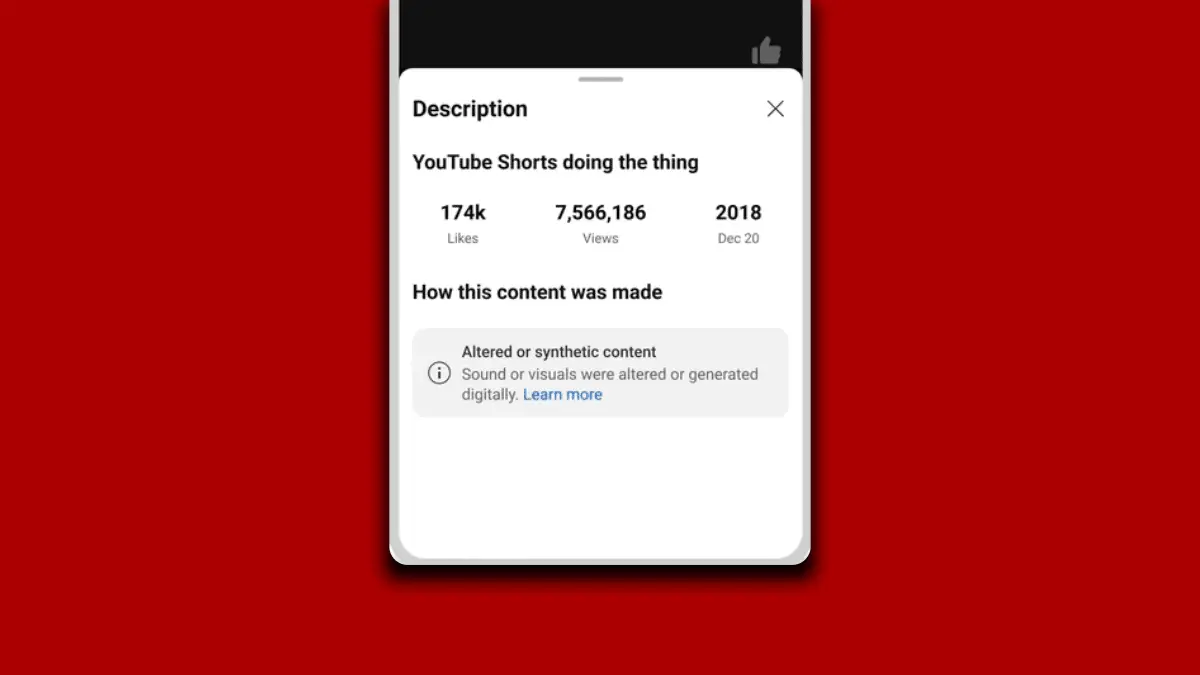

El nuevo sistema, al que contribuyó Microsoft, reconocerá estos sistemas raros con entrenamiento en conflicto y puede aprender en una situación en la que, por ejemplo, puede haber funcionado aceptablemente el 90 por ciento del tiempo, la situación sigue siendo lo suficientemente ambigua como para merecer una "a ciegas". lugar."

“Cuando el sistema se implementa en el mundo real, puede usar este modelo aprendido para actuar con más cautela e inteligencia. Si el modelo aprendido predice que un estado es un punto ciego con alta probabilidad, el sistema puede consultar a un ser humano sobre la acción aceptable, lo que permite una ejecución más segura”, dijo Ramya Ramakrishnan, estudiante de posgrado en el Laboratorio de Ciencias de la Computación e Inteligencia Artificial.

Leer mucho más detalle en MIT News aquí.