Google ahora usa modelos BERT para mejorar la calidad de los resultados de búsqueda

1 minuto. leer

Publicado el

Lea nuestra página de divulgación para descubrir cómo puede ayudar a MSPoweruser a sostener el equipo editorial. Leer más

Google anunció hoy que mejorará los resultados de búsqueda utilizando la técnica BERT. Las representaciones de codificador bidireccional de transformadores (BERT) son una técnica basada en redes neuronales para el preentrenamiento del procesamiento del lenguaje natural (NLP). En lugar de considerar cada palabra en una oración, BERT considerará el contexto completo de una palabra al observar las palabras que vienen antes y después. Google proporcionó un ejemplo siguiente sobre cómo BERT mejorará los resultados de búsqueda.

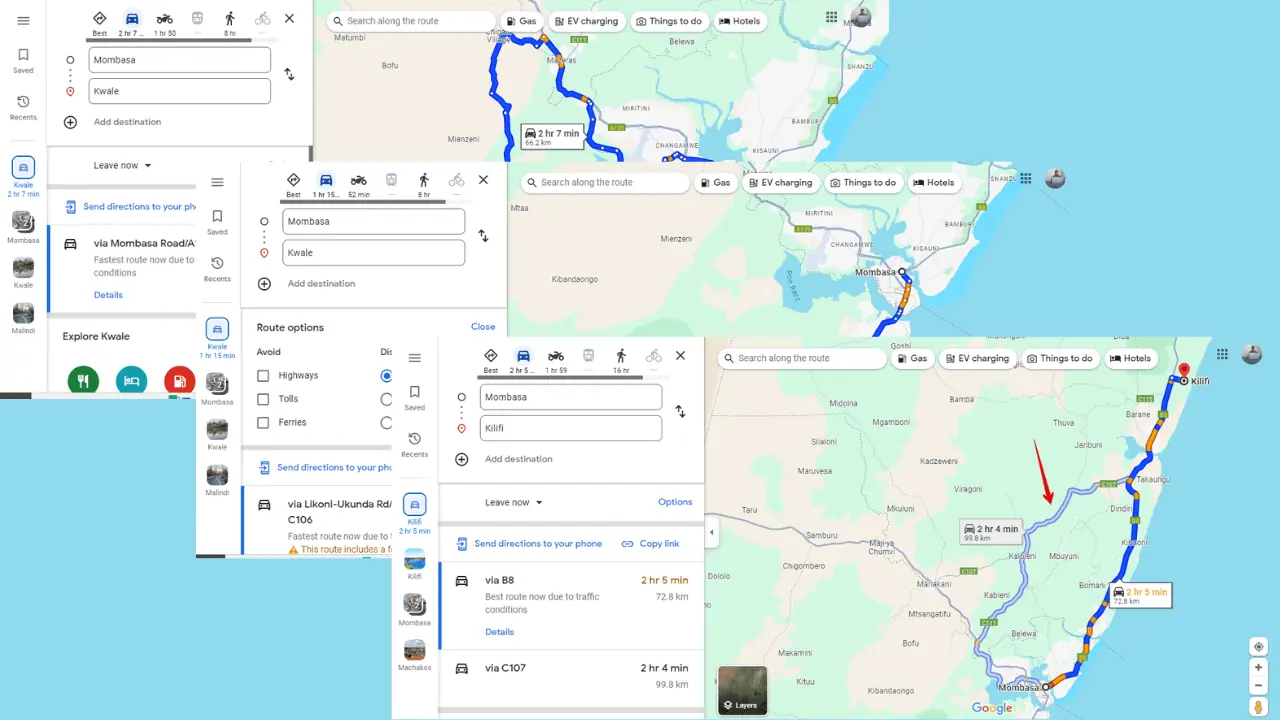

Aquí hay una búsqueda de "2019 brasil viajero a EE. UU. necesita una visa". La palabra "a" y su relación con las otras palabras en la consulta son particularmente importantes para comprender el significado. Se trata de un brasileño que viaja a Estados Unidos, y no al revés. Anteriormente, nuestros algoritmos no entendían la importancia de esta conexión y devolvíamos resultados sobre ciudadanos estadounidenses que viajaban a Brasil.

Echa un vistazo a la imagen al principio del artículo. Google ahora puede entender "estar de pie" como una actividad física y proporcionar resultados apropiados. Google mencionó que BERT ayudará a Search a comprender mejor una de cada 10 búsquedas en los EE. UU. en inglés. Google también llevará la tecnología BERT a más idiomas y regiones en los próximos meses.

Fuente: Google