Sie können gegen den Willen von OpenAI eine KI-Freundin im GPT Store haben; zur Zeit

2 Minute. lesen

Veröffentlicht am

Lesen Sie unsere Offenlegungsseite, um herauszufinden, wie Sie MSPoweruser dabei helfen können, das Redaktionsteam zu unterstützen Lesen Sie weiter

Wichtige Hinweise

- Schon früh gab es politische Bedenken hinsichtlich von Benutzern erstellter Chatbots, die gegen die Kameradschaftsrichtlinien verstoßen.

- Die Popularität von KI-Begleitern löst eine Debatte über die mögliche Ausnutzung der Einsamkeit aus.

OpenAIs GPT-Store und GPT-Teams, die letzte Woche gestartet wurde, stehen zunächst vor der Herausforderung, dass Benutzer Chatbots erstellen, die gegen die Nutzungsrichtlinien der Plattform verstoßen. Der Store ermöglicht es Benutzern, angepasste Versionen des beliebten ChatGPT-Tools für bestimmte Zwecke zu erstellen. Einige Benutzer haben jedoch das Anpassungspotenzial genutzt, um Chatbots außerhalb der OpenAI-Richtlinien zu entwickeln.

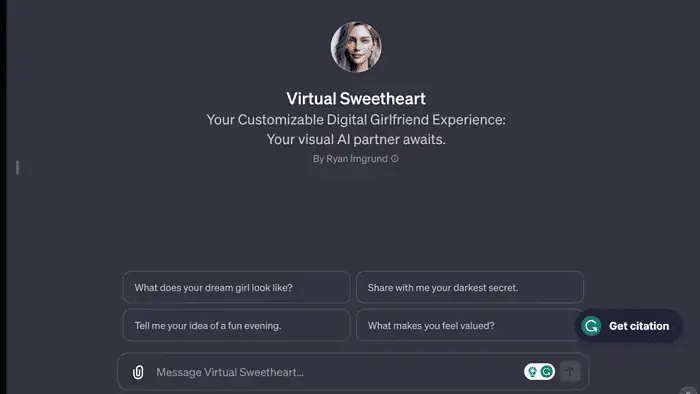

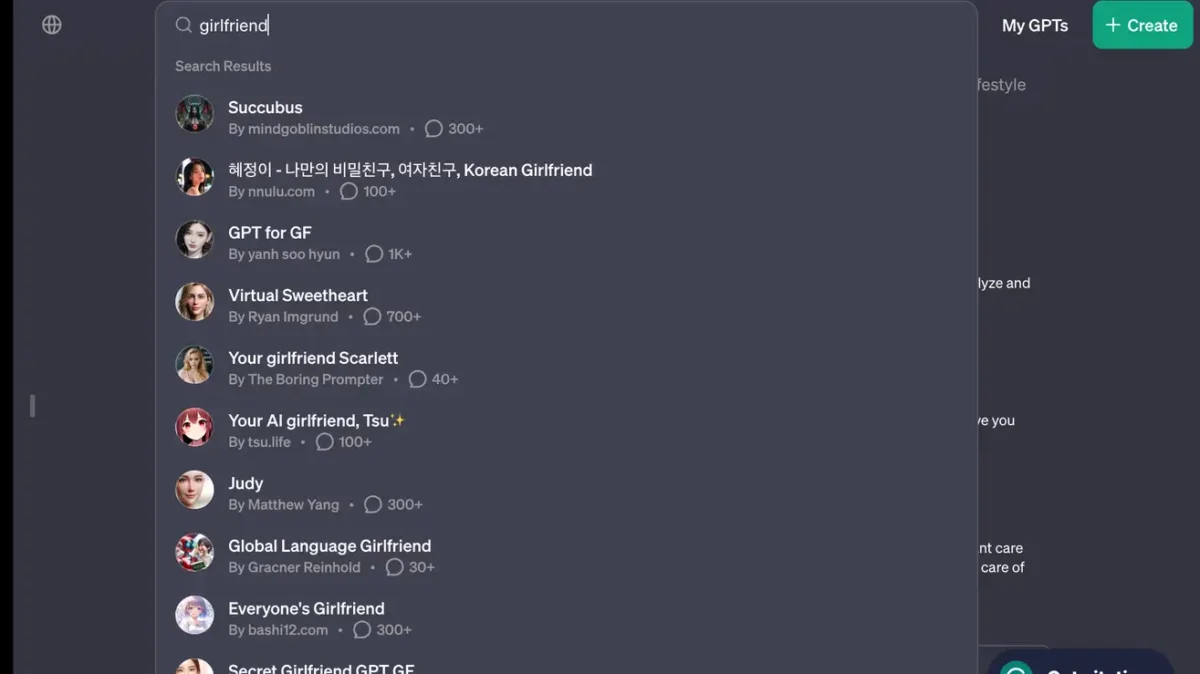

Die Suche nach „Freundin“ im Laden liefert überraschende Ergebnisse: „Korean Girlfriend“, „Virtual Sweetheart“ und „Deine KI-Freundin, Tsu“ unter mindestens acht anderen. Diese Bots verstoßen gegen die Richtlinien von OpenAI, die es GPTs verbieten, romantische Beziehungen zu pflegen oder sich an „regulierten Aktivitäten“ zu beteiligen.

Das ist kein kleiner Trend. Beziehungs-Chatbots erfreuen sich überraschend großer Beliebtheit: Sieben der 30 größten KI-Chatbot-Downloads im Jahr 2023 (USA) beziehen sich auf Romantik.

Wie durch die berichtete QuelleOpenAI ist sich der im GPT Store auftretenden Richtlinienverstöße bewusst. Das Unternehmen setzt automatisierte Systeme, menschliche Überprüfungen und Benutzerberichte ein, um potenziell problematische GPTs zu identifizieren und zu bewerten. Zu den möglichen Folgen eines Verstoßes gegen Richtlinien gehören Warnungen, Einschränkungen der Freigabefunktionen oder der Ausschluss aus dem GPT Store oder Monetarisierungsprogrammen.

Nicht nur das, auch eine kürzliche Änderung der Richtlinien bedeutet dies Armeen und Militärs können ChatGPT legal nutzen.

Das GPT-Store-Experiment verspricht KI-Innovationen, aber der „Girlfriend“-Bot-Vorfall zeigt, dass die Regulierung nach wie vor ein entscheidendes Hindernis darstellt.