Die neuen Open-Source-Sprachmodelle DBRX im Wert von 10 Millionen US-Dollar sind endlich da

Für ein Open-Source-Modell, dessen Schulung 10 Millionen US-Dollar und zwei Monate gekostet hat, ist das beeindruckend.

2 Minute. lesen

Veröffentlicht am

Lesen Sie unsere Offenlegungsseite, um herauszufinden, wie Sie MSPoweruser dabei helfen können, das Redaktionsteam zu unterstützen Lesen Sie weiter

Wichtige Hinweise

- Databricks führt DBRX ein, seinen Satz generativer KI-Modelle auf GitHub und Hugging Face.

- DBRX umfasst DBRX Base für anweisungsbasierte Aufgaben und DBRX Instruct für die individuelle Anpassung.

- Es erfordert leistungsstarke Hardware und übertrifft andere Modelle wie GPT-3.5.

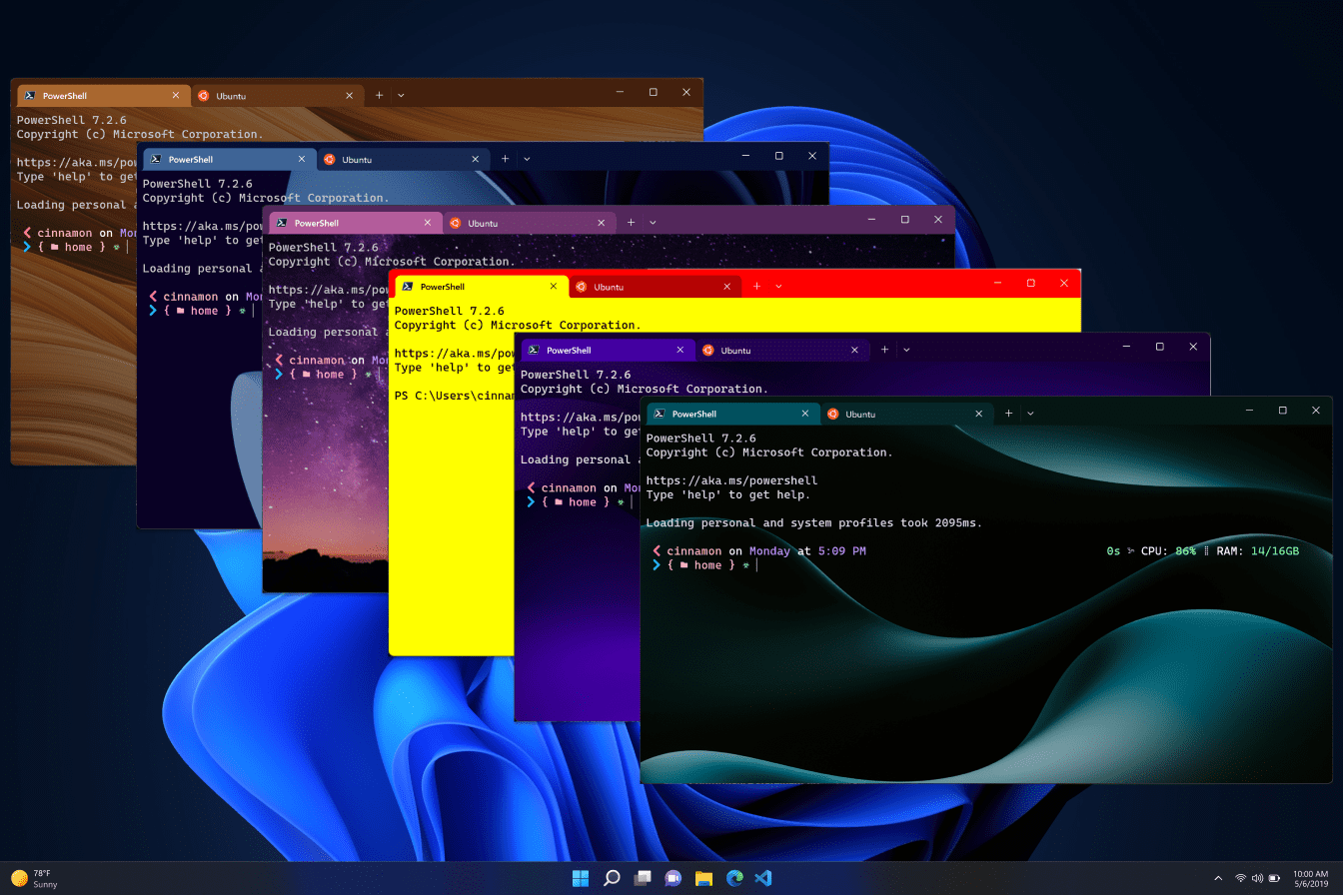

Databricks hat dies erst kürzlich bekannt gegeben Starten von DBRX, sein Satz generativer KI-Modelle, der jetzt auf GitHub und Hugging Face verfügbar ist. Es ist auf 12T-Tokens vorab trainiert, verwendet GLU und GQA und ist nicht multimodal (Bilder können nicht ausgeführt werden).

Das Modell verfügt über zwei Versionen: die DBRX Base, die für anweisungsbasierte Aufgaben optimiert ist, und die DBRX Instruct, ein vorab trainiertes Modell, das für weitere Anpassungen geeignet ist. Das 132B-Parametermodell ist Open Source und auf Englisch verfügbar, obwohl es angeblich auch ins Französische, Deutsche und Spanische übersetzt werden kann.

Naveen Rao, Vizepräsident für generative KI bei Databricks, gab in einem bekannt TechCrunch Interview, dass das Unternehmen 10 Millionen US-Dollar und zwei Monate in die Schulung der Modelle investiert habe. Der Haken ist jedoch, dass für den Betrieb dieser Modelle umfangreiche Hardware erforderlich ist, etwa mindestens 4 Nvidia H100-GPUs oder gleichwertig mit insgesamt 320 GB Speicher, oder eine Cloud eines Drittanbieters mit mehr oder weniger ähnlichen Anforderungen.

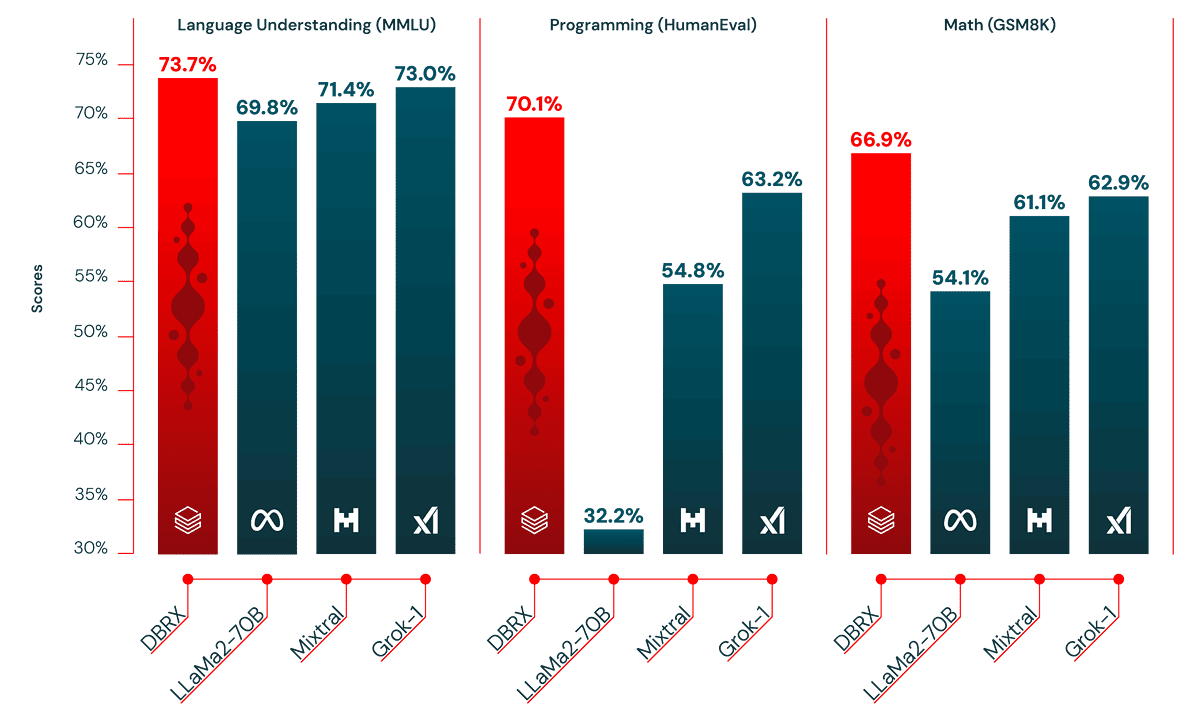

Nach seinem PressemitteilungDBRX behauptet, dass es bestehende Open-Source-Modelle wie LLaMA2-70B, GPT-3.5, Mixtral und übertreffen kann Grok-1 zu bestimmten Dingen wie Mathematik, Logik und mehr. Sie können sie direkt mit Databricks Model Serving nutzen oder sie weiter an spezifische Anforderungen anpassen, da sie für die Verwendung mit der Databricks Open Model-Lizenz lizenziert sind.

Sie können direkt in Databricks Model Serving bereitgestellt oder für Feinabstimmungs- und Batch-Inferenzzwecke verwendet werden.

Sie können die DBRX-Open-Source-Modelle von Databricks ausprobieren hier.