Microsoft patenterer en "Multiple Stage Shy User Interface" designet til 3D Touch

4 min. Læs

Udgivet den

Læs vores oplysningsside for at finde ud af, hvordan du kan hjælpe MSPoweruser med at opretholde redaktionen Læs mere

Microsoft er ved at opbygge en hel portefølje af 3D Touch-baserede brugergrænsefladepatenter, hvor det seneste er en forfining af de såkaldte generte brugergrænsefladeelementer, der almindeligvis findes i mange operativsystemer.

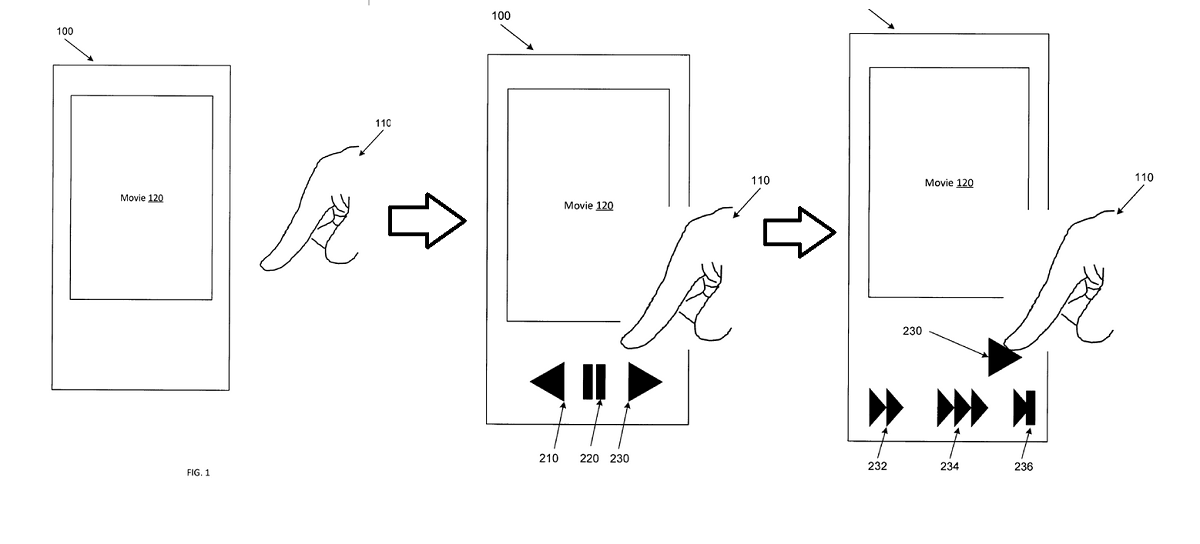

Eksempler på "Shy" brugergrænseflader ville være videokontrollerne, som forsvinder fra skærmen, medmindre du rører ved skærmen, eller browserens adresselinjer, som også forsvinder, når du læser, men ikke rører siden.

Fælles for disse kontroller er, at der kun er ét niveau af interaktion – de er enten synlige eller usynlige.

Microsofts forfining ville være at tilføje flere trin til interaktionen, hvor hensigten samles ved mere end blot at røre skærmen, såsom for eksempel at nærme sig skærmen med fingeren eller svæve over kontrollerne, detekteret med 3D Touch-sensorer, som Microsoft allerede demonstrerede i Nokia McLaren.

I eksemplet ovenfor ville en bruger nærme sig en videoafspiller med deres finger, hvilket ville afsløre kontrollerne. Efterhånden som de kommer tættere på hurtig frem-knappen, vil forskellige hastigheder af hurtig fremad blive afsløret som et andet trin, hvilket gør brugerens interaktion mere flydende og bekvem.

Med patentets egne ord:

Eksempler på apparater og metoder forbedres i forhold til konventionelle tilgange til menneske-til-enhed-interaktion ved at afsløre UI-elementer eller funktionalitet i flere kontekstafhængige faser baseret på at skelne en brugers hensigt. Eksempler på apparater og metoder kan stole på tredimensionelle (3D) berørings- eller svævesensorer, der detekterer tilstedeværelsen, positionen, orienteringen, kørselsretningen eller bevægelseshastigheden af en markør (f.eks. brugers finger, redskab, stylus, pen). 3D-sensorerne kan give information, hvorfra der kan træffes en bestemmelse om, hvilket objekt, element eller område af en grænseflade en bruger peger på, gestikulerer eller på anden måde interagerer med eller indikerer en hensigt om at interagere med. Hvis brugeren ikke aktivt har navigeret på enheden, kan eksempelapparater og -metoder vise (f.eks. vise) kontekstrelevante brugergrænsefladeelementer eller handlinger, som ikke tidligere blev vist. Hvis en bruger f.eks. ser en video, kan et øverste lag af videokontrolelementer blive vist. I modsætning til konventionelle systemer, hvis brugeren derefter fastholder eller indsnævrer deres fokus på eller i nærheden af et bestemt UI-element, der lige er blevet afsløret, kan et andet eller efterfølgende lag af videokontrolelementer eller effekter blive vist. Efterfølgende dybere lag i et hierarki kan præsenteres, efterhånden som brugeren interagerer med de overfladeelementer.

Eksempler på apparater og metoder kan lette forbedrede, hurtigere og mere intuitive interaktioner med en bredere vifte af brugergrænsefladeelementer, kontroller eller effekter uden at kræve vedvarende overførsel på skærmen eller skjulte bevægelser, der kan være svære at opdage eller lære. Enkeltlagskontroller, der afsløres ved registrering af en skærmberøring eller gestus, er velkendte. Disse kontroller, der vises selektivt ved registrering af en skærmberøring eller gestus, kan blive refereret til som "sky" kontroller. Eksempler på apparater og metoder forbedrer disse enkeltlags berøringsbaserede tilgange ved at give flerlags generte kontroller og effekter, der afsløres på en kontekstfølsom måde baseret på input, herunder berørings-, svæve-, taktile- eller stemmeinteraktioner. Svævefølsomme grænseflader kan ikke blot registrere tilstedeværelsen af en brugers finger, men også vinklen, som fingeren peger med, hastigheden, hvormed fingeren bevæger sig, retningen, fingeren bevæger sig i, eller andre egenskaber ved fingeren. I stedet for en binær {touch: yes/no}-tilstandsdetektering kan en højere ordens inputplads således analyseres for at bestemme en brugers hensigt med hensyn til et brugergrænsefladeelement. 3D-nærhedsdetektorer kan bestemme, hvilket objekt eller hvilken skærmplacering brugeren har til hensigt at interagere med og kan derefter detektere og karakterisere flere attributter for interaktionen.

Det vides ikke, om Microsoft stadig arbejder på 3D Touch til deres telefoner, men teknologien ville være lige så anvendelig til RealSense-kameraer som med Windows Hello eller med Hololens via blikregistrering og håndsporing.

Ville vores læsere sætte pris på en brugergrænseflade, der reagerer dynamisk på din hensigt, eller vil du foretrække en, der forbliver temmelig fast og forudsigelig? Fortæl os nedenfor.