Microsoft Azure AI afslører 'Prompt Shields' for at bekæmpe LLM-manipulation

2 min. Læs

Udgivet den

Læs vores oplysningsside for at finde ud af, hvordan du kan hjælpe MSPoweruser med at opretholde redaktionen Læs mere

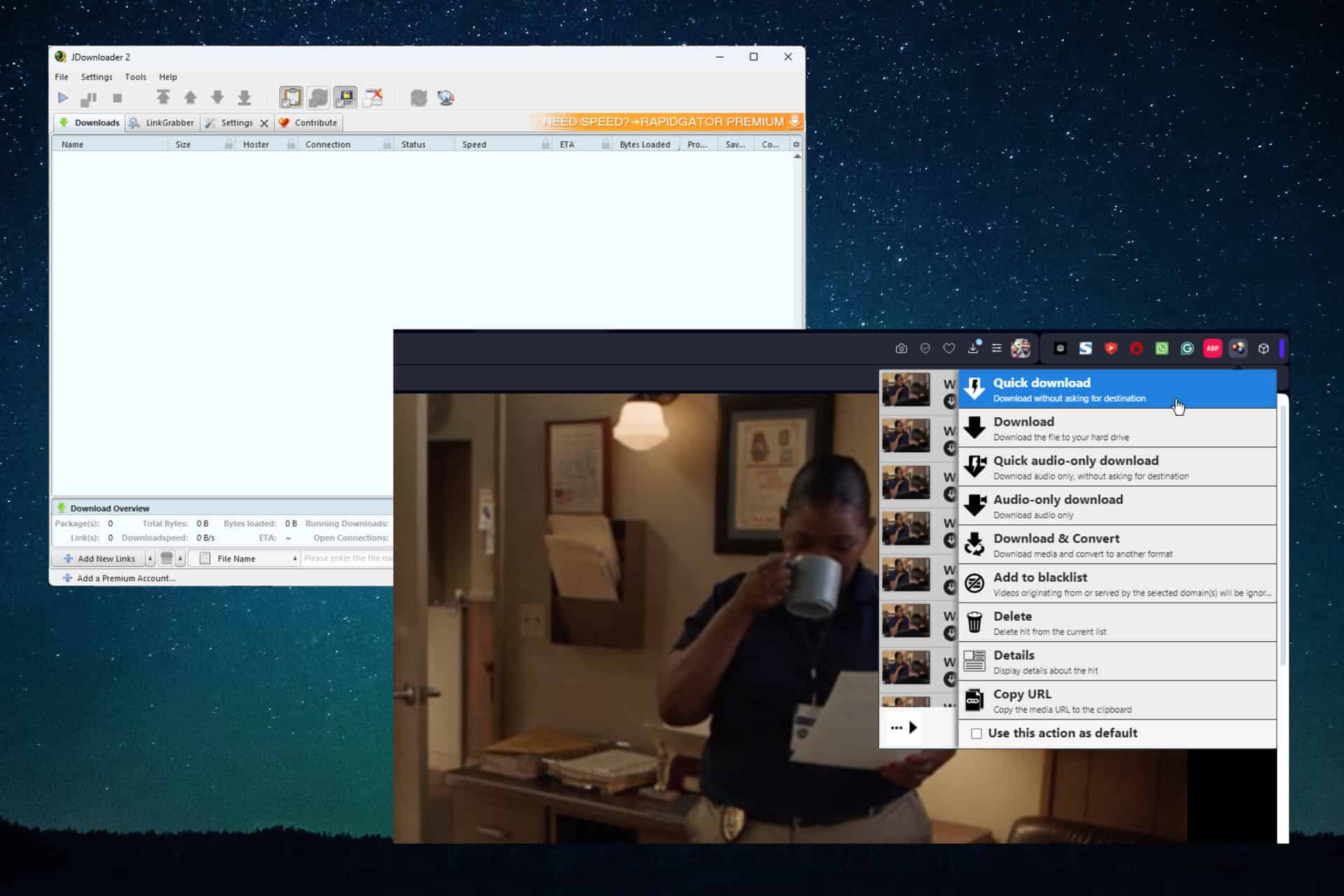

Microsoft i dag annoncerede en større sikkerhedsforbedring for dets Azure OpenAI Service og Azure AI Content Safety platforme. Kaldet "Prompt Shields" tilbyder den nye funktion robust forsvar mod stadig mere sofistikerede angreb rettet mod store sprogmodeller (LLM'er).

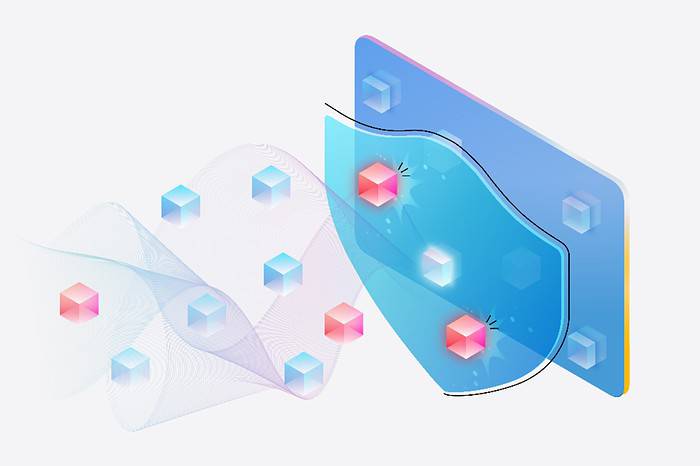

Prompt Shields beskytter mod:

- Direkte angreb: Også kendt som jailbreak-angreb, instruerer disse forsøg eksplicit LLM til at se bort fra sikkerhedsprotokoller eller udføre ondsindede handlinger.

- Indirekte angreb: Disse angreb indlejrer subtilt skadelige instruktioner i tilsyneladende normal tekst, med det formål at narre LLM til uønsket adfærd.

Prompt Shields er integreret med Azure OpenAI Service-indholdsfiltre og er tilgængelige i Azure AI Content Safety. Takket være avancerede maskinlæringsalgoritmer og naturlig sprogbehandling kan Prompt Shields identificere og neutralisere potentielle trusler i brugerprompts og tredjepartsdata.

Spotlighting: En ny forsvarsteknik

Microsoft introducerede også "Spotlighting", en specialiseret prompt ingeniørtilgang designet til at forhindre indirekte angreb. Spotlighting-teknikker, såsom afgrænsning og datamarkering, hjælper LLM'er med tydeligt at skelne mellem legitime instruktioner og potentielt skadelige indlejrede kommandoer.

Tilgængelighed

Prompt Shields er i øjeblikket i offentlig forhåndsvisning som en del af Azure AI Content Safety og vil være tilgængelig i Azure OpenAI Service den 1. april. Integration i Azure AI Studio er planlagt i den nærmeste fremtid.