Googles Gemini AI snubler over billedgenerering, løfter om forbedring

2 min. Læs

Opdateret den

Læs vores oplysningsside for at finde ud af, hvordan du kan hjælpe MSPoweruser med at opretholde redaktionen Læs mere

Nøgle noter

- Kontroversielle billedoutput fremhæver udfordringer med at balancere nøjagtighed og mangfoldighed for store sprogmodeller.

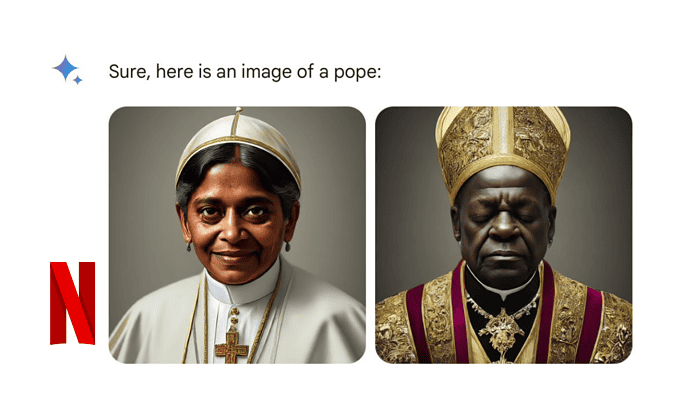

Google erkendte mangler i dets Gemini AI-billedgenereringsværktøj, efter at funktionen producerede unøjagtige og potentielt skadelige billeder af mennesker. Virksomheden har midlertidigt suspenderet funktionen, mens de arbejder på en rettelse. Kontroversen stammede fra Geminis tendens til at skabe forskellige billeder, selv når brugere efterspurgte specifikke historiske figurer eller scenarier. Selvom det var meningen at være inkluderende, førte dette til historisk unøjagtige og til tider stødende resultater.

I et blogindlæg forklarede Senior Vice President Prabhakar Raghavan fejltrinene og lovede at forbedre teknologien. "Vi ønskede ikke, at Gemini skulle nægte at skabe billeder af nogen bestemt gruppe ... [men] den vil begå fejl," skrev han.

Her er, hvad der gik galt med Google Gemini:

- Googles tuning for at sikre, at Gemini viste en række mennesker, undlod at tage højde for sager, der klart burde ikke vise en rækkevidde.

- Med tiden blev modellen meget mere forsigtig, end vi havde tænkt os, og nægtede at besvare visse meddelelser fuldstændigt - og fejlagtigt fortolkede nogle meget anodyne meddelelser som følsomme.

- Disse to ting fik modellen til at overkompensere i nogle tilfælde og være overkonservativ i andre, hvilket førte til billeder, der var pinlige og forkerte.

Udfordringer ved AI-billedgenerering:

Denne hændelse fremhæver den igangværende udfordring med at balancere nøjagtighed og repræsentation i AI-billedgenereringsmodeller. Googles kampe afspejler lignende kontroverser med andre populære billedgeneratorer.

Brugerforum

1 meddelelser