Microsoft Research představuje Splitwise, novou techniku pro zvýšení efektivity GPU pro velké jazykové modely

2 min. číst

Publikované dne

Přečtěte si naši informační stránku a zjistěte, jak můžete pomoci MSPoweruser udržet redakční tým Dozvědět se více

Klíčové poznámky

- Splitwise je průlom v účinnosti a udržitelnosti odvození LLM.

- Oddělením fáze výzvy a tokenu odemyká Splitwise nový potenciál v použití GPU a umožňuje poskytovatelům cloudu rychleji obsluhovat více dotazů při stejném rozpočtu na energii.

Velké jazykové modely (LLM) transformují oblasti zpracování přirozeného jazyka a umělé inteligence a umožňují aplikace, jako je generování kódu, konverzační agenti a sumarizace textu. Tyto modely však také představují významné výzvy pro poskytovatele cloudu, kteří potřebují nasazovat stále více grafických procesorových jednotek (GPU), aby uspokojili rostoucí poptávku po LLM odvození.

Problém je v tom, že GPU jsou nejen drahé, ale také energeticky náročné a kapacita pro zajištění elektřiny potřebné k jejich provozu je omezená. V důsledku toho se poskytovatelé cloudu často potýkají s dilematem buď odmítnutí uživatelských dotazů, nebo zvýšení jejich provozních nákladů a dopadu na životní prostředí.

K vyřešení tohoto problému vyvinuli výzkumníci v Microsoft Azure novou techniku s názvem Splitwise, jehož cílem je zefektivnit a udržitelnou inferenci LLM rozdělením výpočtu do dvou odlišných fází a jejich přidělením různým strojům. O této technice si můžete podrobně přečíst v jejich „Splitwise: Efektivní generativní inference LLM pomocí rozdělení fází“výzkumný papír.

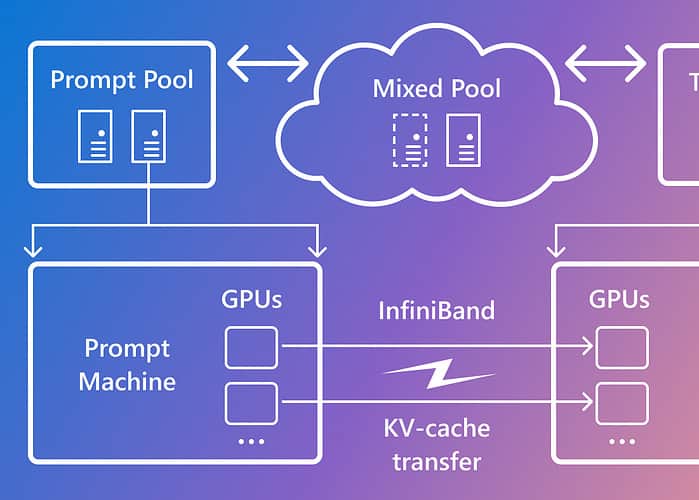

Splitwise je založen na pozorování, že inference LLM se skládá ze dvou fází s různými charakteristikami: fáze promptní fáze a fáze generování tokenů. Ve fázi výzvy model zpracovává vstup uživatele nebo výzvu paralelně s využitím velkého množství výpočtů GPU. Ve fázi generování tokenu model generuje každý výstupní token postupně s využitím velké šířky pásma paměti GPU. Kromě oddělení dvou inferenčních fází LLM do dvou odlišných strojových fondů použil Microsoft třetí strojový fond pro smíšené dávkování napříč fází promptu a tokenu, dimenzovaný dynamicky na základě požadavků na výpočty v reálném čase.

Pomocí Splitwise byl Microsoft schopen dosáhnout následujícího:

- 1.4x vyšší propustnost při o 20 % nižších nákladech než u současných návrhů.

- 2.35x vyšší propustnost při stejných nákladech a rozpočtech na výkon.

Splitwise je průlom v účinnosti a udržitelnosti odvození LLM. Oddělením fáze výzvy a tokenu odemyká Splitwise nový potenciál v použití GPU a umožňuje poskytovatelům cloudu rychleji obsluhovat více dotazů při stejném rozpočtu na energii. Splitwise je nyní součástí vLLM a lze jej implementovat také s jinými frameworky. Výzkumníci z Microsoft Azure plánují pokračovat ve své práci na zefektivnění a udržitelnosti odvození LLM a předpokládají přizpůsobené fondy strojů, které povedou k maximální propustnosti, snížení nákladů a energetické účinnosti.