Snowflake Arctic 自豪地被譽為「企業人工智慧的最佳法學碩士」。這是一個相當大的主張

現在您可以在 HuggingFace 上嘗試 Snowflake

2分鐘讀

發表於

重點說明

- Snowflake推出Arctic,聲稱它可以以更低的成本與Llama 3 70B相媲美。

- Arctic 擅長編碼和 SQL 生成等企業任務。

- Arctic 使用 Dense-MoE 混合系統優化了各種批量大小的效率。

Snowflake 是一家最初由前甲骨文科學家創建的雲端運算巨頭,現在正在人工智慧戰爭中向巨頭發起挑戰。公司推出 北極雪花,其最新的“企業人工智慧最佳法學碩士”,並聲稱它比 Llama 3 70B 更好,並且比後者的 8B 變體更好。

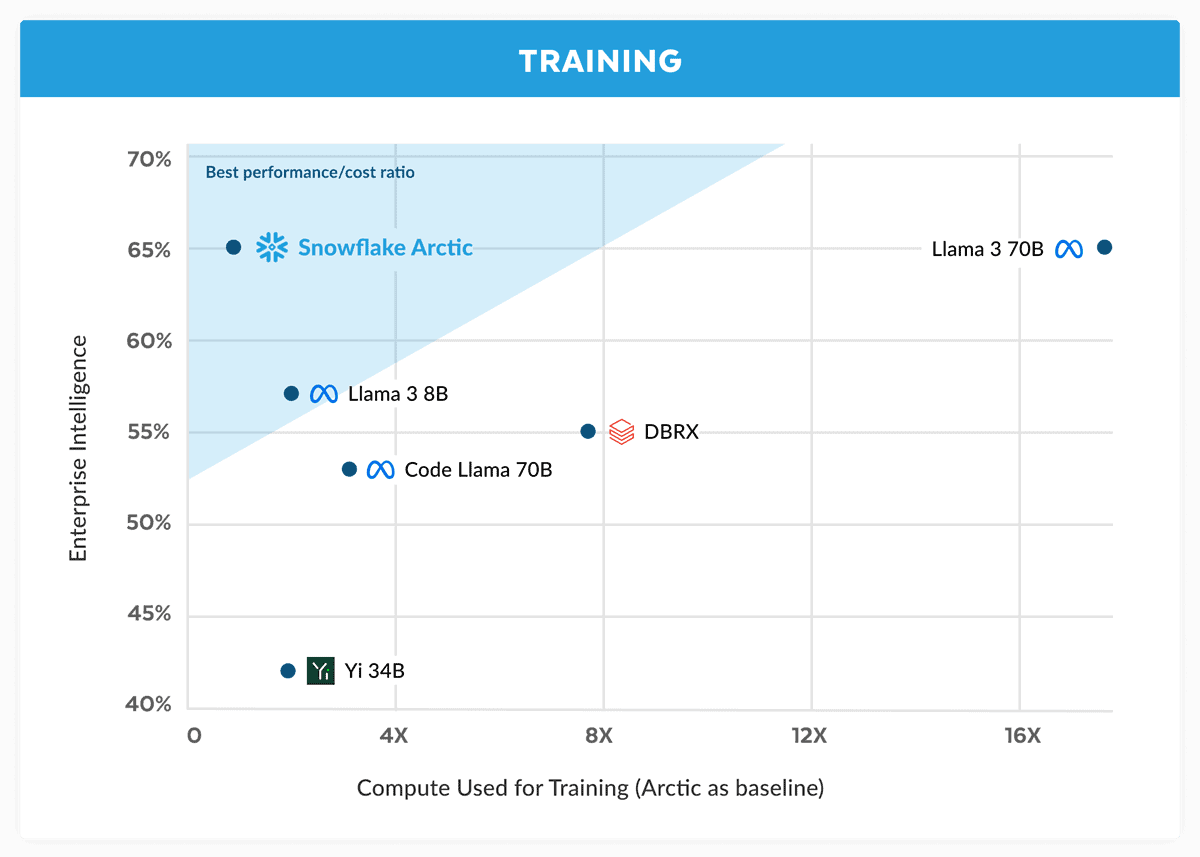

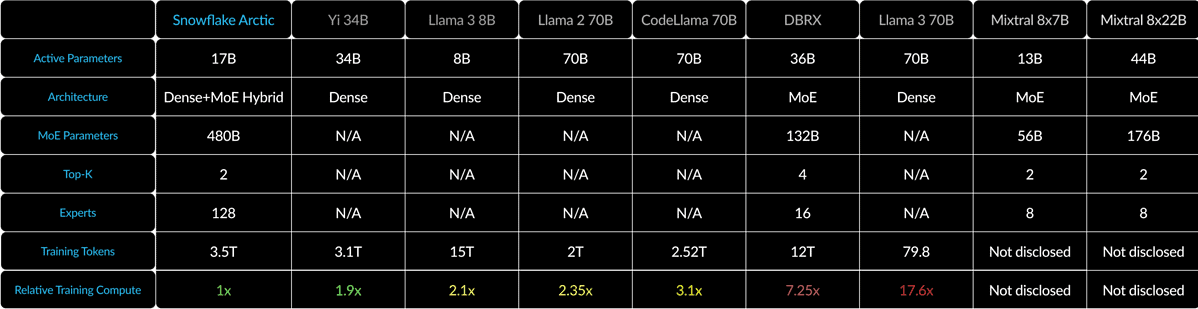

Snowflake 在公告中聲稱 Arctic 模型的性能與 Llama 3 70B 相當,但計算要求和成本較低。它被譽為編碼(HumanEval+ 和 MBPP+)、SQL 生成(Spider)和指令追蹤(IFEval)等領域和基準中企業智慧任務的理想選擇。

這是一個很大的主張,特別是考慮到 羊駝 3 70B 在重要測試中,與 GPT-4 Turbo 和 Claude 3 Opus 等其他主要模型相比,它表現良好。據報導,Meta 即將推出的模型在 MMLU(用於理解學科)、GPQA(生物學、物理和化學以及 HumanEval(編碼))等基準測試中得分很高。

Snowflake Arctic 使用密集 MoE 混合技術將 10B 密集變壓器與 128×3.66B MoE MLP 混合在一起。總共有 480B 個參數,但只有 17B 被主動使用,透過 top-2 選通進行選擇。

對於像 1 這樣的小批量大小,與 Code-Llama 4B 相比,Arctic 將記憶體讀取量減少了 70 倍,比 Mixtral 2.5x8B 減少了 22 倍。但是,隨著批次大小顯著增加,Arctic 變得受限。它的計算量比 CodeLlama 4B 和 Llama 70 3B 少 70 倍。

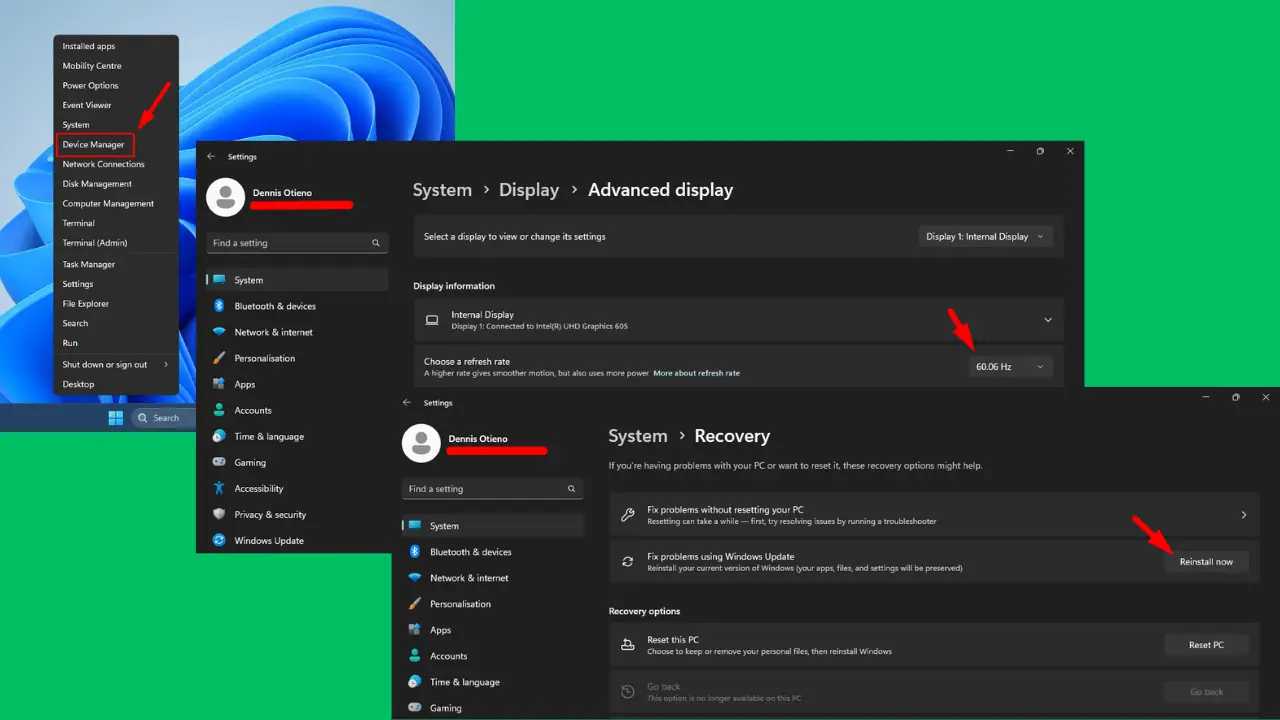

您可以嘗試 Snowflake Arctic 擁抱臉。該公司還承諾該模型將很快登陸 AWS、Microsoft Azure、Perplexity 等其他模型花園。

使用者論壇

0消息