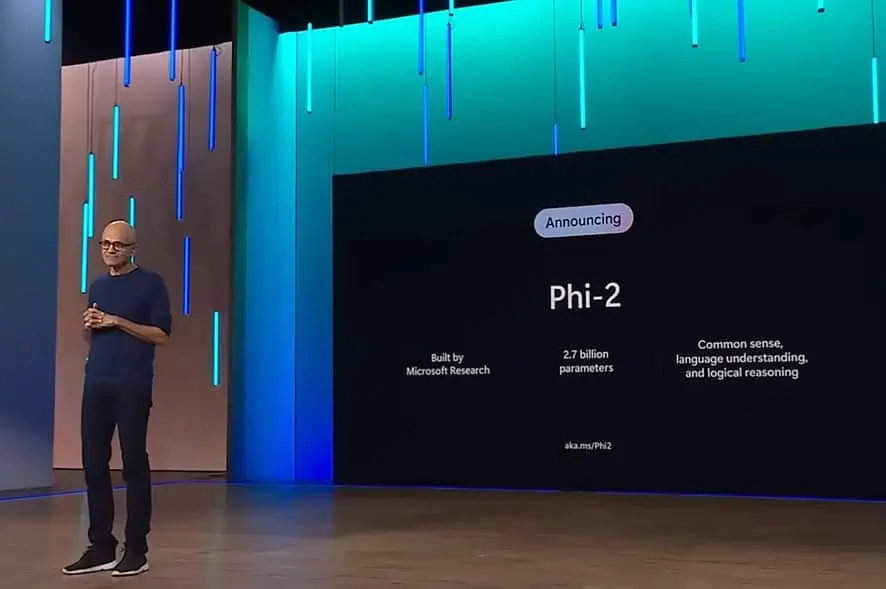

微軟的 Phi-2 2.7B 型號優於最近發布的 Google Gemini Nano-2 3.2B 型號

2分鐘讀

發表於

在過去的幾個月裡,微軟研究院發布了一套名為「Phi」的小語言模型(SLM)。 Phi-1 首先發布,擁有 1.3 億個參數,專門用於基本的 Python 編碼。 XNUMX月,微軟研究院 發布 Phi-1.5 模型具有 1.3 億個參數,但它是使用包含各種 NLP 合成文字的新資料來源進行訓練的。 儘管尺寸很小,但與其他類似尺寸的型號相比,phi-1.5 提供了近乎最先進的性能。

今天,微軟宣布發布擁有 2 億個參數的 Phi-2.7 模型。 微軟研究院聲稱,這種新的 SLM 在參數少於 13 億的基本語言模型中提供了最先進的效能。 在一些複雜的基準測試中,Phi-2 的性能可與大 25 倍的模型相匹配或優於模型。

上週,谷歌 宣布 Gemini 語言模型套件。 Gemini Nano 是 Google 專為設備上任務而構建的最高效模型,它可以直接在行動晶片上運行。 類似 Gemini Nano 的小語言模型可實現文本摘要、上下文智能回復以及高級校對和語法糾正等功能。

據微軟稱,新的 Phi-2 型號儘管尺寸較小,但與新的 Google Gemini Nano-2 相當或優於新的 Google Gemini Nano-2。 您可以在下面找到 Google Gemini Nano-2 和 Phi-XNUMX 模型之間的基準比較。

| 型號 | 尺寸 | bbh | 布爾Q | MBPP | 百萬美元 |

|---|---|---|---|---|---|

| 雙子座奈米2 | 3.2B | 42.4 | 79.3 | 27.2 | 55.8 |

| Φ2 | 2.7B | 59.3 | 83.3 | 59.1 | 56.7 |

除了超越 Gemini Nano-2 之外,Phi-2 還在各種基準測試中的 2B 和 7B 參數上超越了 Mistral 和 Llama-13 模型的效能。 尋找下面的詳細資訊。

| 型號 | 尺寸 | bbh | 常識 推理 | 語言 理解 | 數學 | 電腦程式 |

|---|---|---|---|---|---|---|

| 美洲駝-2 | 7B | 40.0 | 62.2 | 56.7 | 16.5 | 21.0 |

| 13B | 47.8 | 65.0 | 61.9 | 34.2 | 25.4 | |

| 70B | 66.5 | 69.2 | 67.6 | 64.1 | 38.3 | |

| 寒冷西北風 | 7B | 57.2 | 66.4 | 63.7 | 46.4 | 39.4 |

| Φ2 | 2.7B | 59.2 | 68.8 | 62.0 | 61.1 | 53.7 |

雖然前兩個 phi 型號已在 Hugging Face 上提供, 披 - 2 已在 Azure 模型目錄中提供。 您可以了解更多有關 Phi-2 的信息 請點擊這裡.