Mixtral 8x22B 开源模型终于来了,可通过 Torrent 下载

到目前为止,AI 行业度过了忙碌的几天

2分钟读

发表于

重点说明

- 随着人工智能竞赛的白热化,Mistral 推出了其前沿模型 Mixtral 8x22B。

- 开源模型有 176B 个参数和 65K 个 token 的上下文长度

- 它可以通过 Torrent 下载。

米斯特拉尔带着一个重大声明回来了。周三早些时候,随着人工智能竞争的白热化,这家微软支持的法国公司推出了其前沿模型 Mixtral 8x22B。

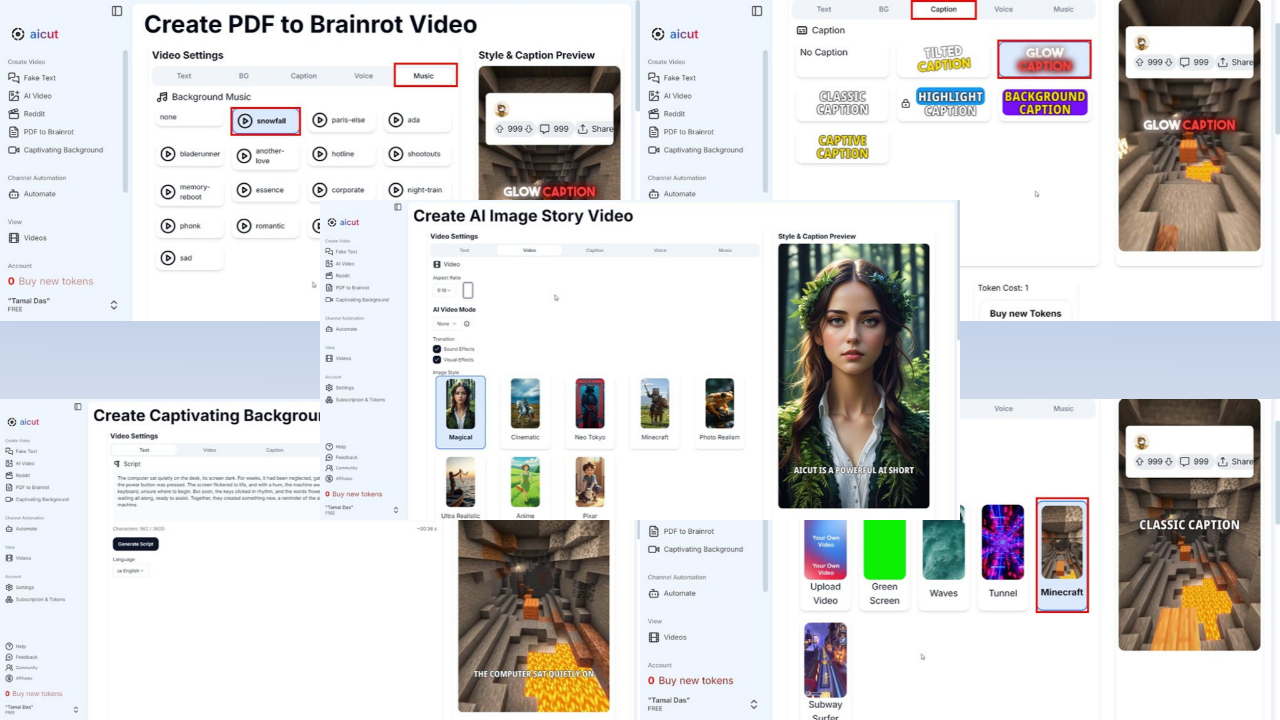

其中最好的部分是什么?它是一个开源系统,您可以通过Torrent下载它,文件大小为281GB,作为AI启动 发布了它的磁力链接 在 X(以前称为 Twitter)上。现在也可以在 拥抱脸 和 困惑人工智能实验室.

Mistral 大部分由 Google 和 Meta 的前员工组成。该公司的前身型号 Mixtral 8x7B 是 推出 早在去年 2 月,但据说在 MMLU、ARC Challenge、MBPP 等某些基准测试中,它的表现优于 Llama-70 3.5B 和 OpenAI 的 GPT-XNUMX 等竞争对手。

现在,Mixtral 8x22B 具有 176B 参数和 65K 令牌的上下文长度。尽管它很大,但它只使用较小的部分(44B)来完成每个任务,使其使用起来更加经济实惠。

毫无疑问,这是人工智能行业最繁忙的 24 小时之一。谷歌终于做出了 双子座 1.5 Pro 上市 在大多数国家,并将其 Duet AI for Developers 重新命名为 Gemini 代码协助,将其基础设施从 Codey 迁移到 Gemini。

来自 Meta 的另一个消息, 信息 据独家报道,Facebook 所有者准备在下周推出较小的 Llama 3 版本。

用户论坛

0消息