微软解释为什么法学硕士会产生幻觉并编造答案

2分钟读

更新

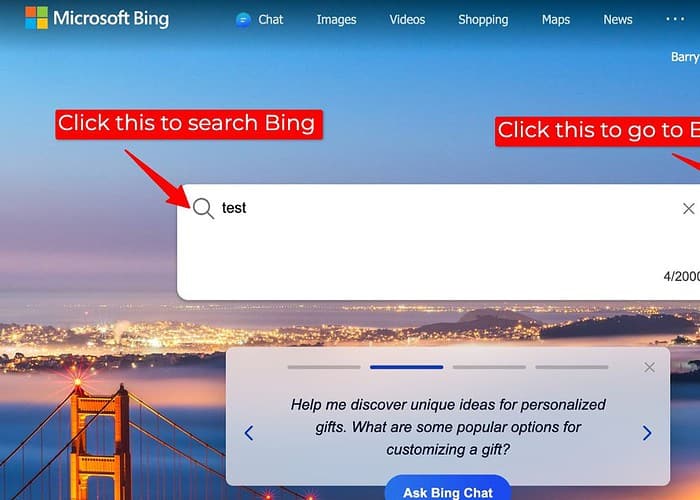

最近,一位用户和一位微软高管之间的 Twitter 交流让人们重新关注 Bing 等大型语言模型 (LLM) 的局限性,以及仅依靠内部知识时可能出现的信息差距。

讨论源于一名用户报告,当访问外部网络数据的搜索插件被禁用时,Bing 上的搜索结果不准确。作为回应,微软广告和网络服务首席执行官 Mikhail Parakhin 承认法学硕士在这种情况下“编造”的可能性。

他解释说,当无法通过网络获得大量信息时,法学硕士有时可以利用其内部知识库(用于培训的文本和代码的集合)来生成响应。然而,这种内部生成可能并不总是准确或与事实相符,导致搜索结果与启用搜索插件获得的结果相比可能存在差异。

对我来说,这提出了关于法学硕士支持的搜索的透明度和准确性的重要问题,特别是在外部数据源不可用的情况下。当法学硕士在不访问外部数据的情况下生成回复时,应向用户明确说明信息的来源和任何潜在的限制。

虽然提供答案很有价值,但法学硕士必须优先考虑可靠的信息,而不是填补可能不准确的内部生成的知识空白。探索替代方法,例如表明不确定性、建议进一步研究或简单地指出无法找到答案,可以增强信任并防止错误信息的传播。

因此,难怪为什么 人们更喜欢 ChatGPT 而不是 Bing Chat/Copilot。

出于这些原因,我个人更喜欢使用 Bard,因为 Google 提供了一个功能,Bard 可以让用户知道该信息是否是从其他地方引用的,从而使用户更容易信任该信息。

用户论坛

0消息