GPT-3 là gì và nó sẽ ảnh hưởng như thế nào đến công việc hiện tại của bạn

3 phút đọc

Cập nhật vào

Đọc trang tiết lộ của chúng tôi để tìm hiểu cách bạn có thể giúp MSPoweruser duy trì nhóm biên tập Tìm hiểu thêm

GPT là viết tắt của Generative Pre-training Transformer (GPT), một mô hình ngôn ngữ được viết bởi Alec Radford và được xuất bản vào năm 2018 bởi OpenAI, phòng thí nghiệm nghiên cứu trí tuệ nhân tạo của Elon Musks. Nó sử dụng một mô hình chung của ngôn ngữ (trong đó hai mạng nơ-ron hoàn thiện nhau bằng cách cạnh tranh) và có thể thu nhận kiến thức về thế giới và xử lý sự phụ thuộc trong phạm vi dài bằng cách đào tạo trước trên các bộ tài liệu viết đa dạng với các đoạn văn bản liền kề dài.

GPT-2 (Generative Pretrained Transformer 2) đã được công bố vào tháng 2019 năm 8 và là một mô hình ngôn ngữ biến áp không giám sát được đào tạo trên 40 triệu tài liệu với tổng số XNUMX GB văn bản từ các bài báo được chia sẻ qua các bài gửi Reddit. Elon Musk nổi tiếng không muốn phát hành nó vì ông lo ngại rằng nó có thể được sử dụng để spam các mạng xã hội với tin tức giả mạo.

Vào tháng 2020 năm 3, OpenAI đã công bố GPT-3 (Generative Pretrained Transformer 2), một mô hình có chứa hai bậc thông số lớn hơn GPT-175 (1.5 tỷ so với 2 tỷ thông số) và cung cấp một cải tiến đáng kể so với GPT-XNUMX.

Với bất kỳ lời nhắc văn bản nào, GPT-3 sẽ trả về một văn bản hoàn thành, cố gắng khớp với mẫu bạn đã đưa cho nó. Bạn có thể “lập trình” nó bằng cách chỉ cho nó một vài ví dụ về những gì bạn muốn nó làm và nó sẽ cung cấp một bài báo hoặc câu chuyện hoàn chỉnh, chẳng hạn như văn bản bên dưới, được viết hoàn toàn bởi GPT-3.

GPT-3 đạt được hiệu suất mạnh mẽ trên nhiều bộ dữ liệu NLP, bao gồm các tác vụ dịch thuật, trả lời câu hỏi và sao chép, cũng như một số tác vụ yêu cầu lập luận nhanh hoặc thích ứng miền, chẳng hạn như phân loại từ, sử dụng một từ mới trong một câu, hoặc biểu diễn số học có 3 chữ số. GPT-3 có thể tạo ra các mẫu tin bài mà người đánh giá là con người khó phân biệt với các bài báo do con người viết.

Ứng dụng cuối cùng luôn khiến OpenAI lo lắng. GPT-3 hiện có sẵn dưới dạng bản beta mở, cuối cùng thì bản beta riêng tư trả phí dự kiến sẽ có sẵn. OpenAI cho biết họ sẽ chấm dứt quyền truy cập API đối với các trường hợp sử dụng rõ ràng là có hại, chẳng hạn như quấy rối, spam, cực đoan hóa hoặc lướt web.

Trong khi dân số bị đe dọa rõ ràng nhất là những người tạo ra tác phẩm viết, chẳng hạn như người viết kịch bản, các nhà phát triển AI đã tìm thấy các ứng dụng đáng ngạc nhiên, chẳng hạn như sử dụng GPT-3 để viết mã.

Ví dụ, Sharif Shameem đã viết một trình tạo bố cục nơi bạn mô tả bằng văn bản thuần túy những gì bạn muốn và mô hình tạo ra mã thích hợp.

Đây là tâm trí thổi.

Với GPT-3, tôi đã xây dựng một trình tạo bố cục nơi bạn chỉ cần mô tả bất kỳ bố cục nào bạn muốn và nó tạo mã JSX cho bạn.

- Sharif Shameem (@sharifshameem) 13 Tháng Bảy, 2020

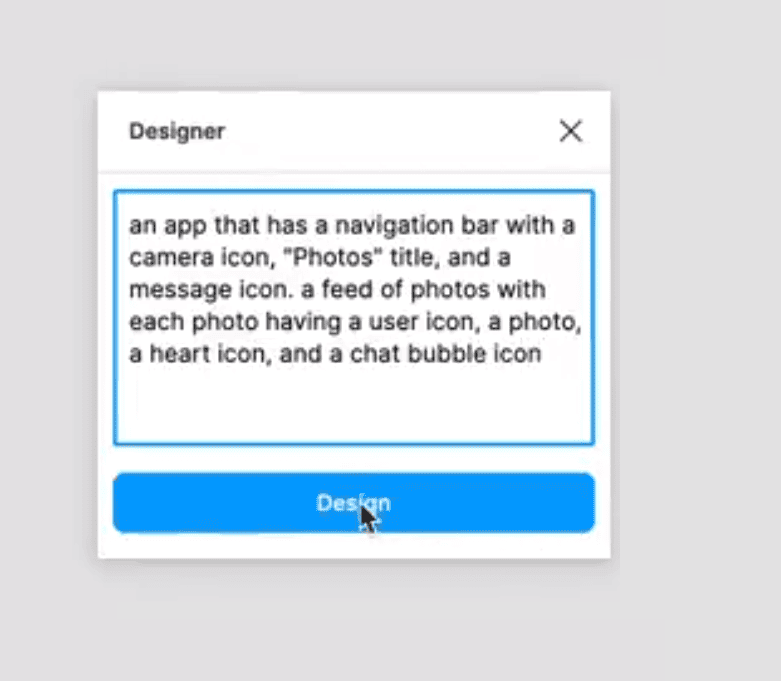

Tương tự, Jordan Singer đã tạo ra một plugin Figma cho phép một người tạo ứng dụng bằng cách sử dụng mô tả văn bản thuần túy.

Điều này thay đổi mọi thứ. ?

Với GPT-3, tôi đã tạo một plugin Figma để thiết kế cho bạn.

Tôi gọi nó là "Nhà thiết kế" pic.twitter.com/OzW1sKNLEC

- ca sĩ jordan (@jsngr) 18 Tháng Bảy, 2020

Nó thậm chí có thể được sử dụng để chẩn đoán bệnh hen suyễn và kê đơn thuốc.

So @OpenAI đã cho tôi quyền truy cập sớm vào một công cụ cho phép các nhà phát triển sử dụng thứ về cơ bản là trình tạo văn bản mạnh mẽ nhất từ trước đến nay. Tôi nghĩ tôi sẽ kiểm tra nó bằng cách hỏi một câu hỏi y tế. Văn bản in đậm là văn bản do AI tạo ra. Không thể tin được… (1/2) pic.twitter.com/4bGfpI09CL

– Qasim Munye (@qasimmunye) 2 Tháng Bảy, 2020

Các ứng dụng khác giống như một công cụ tìm kiếm hoặc tiên tri của các loại, và thậm chí có thể được sử dụng để giải thích và mở rộng các khái niệm khó.

Tôi đã tạo một công cụ tìm kiếm hoạt động đầy đủ trên GPT3.

Đối với bất kỳ truy vấn tùy ý nào, nó trả về câu trả lời chính xác VÀ URL tương ứng.

Xem toàn bộ video. Nó tốt.

cc: @gdb @npew @gwern pic.twitter.com/9ismj62w6l

- Paras Chopra (@paraschopra) 19 Tháng Bảy, 2020

Mặc dù có vẻ như cách tiếp cận này có thể dẫn trực tiếp đến một AI nói chung có thể hiểu, suy luận và trò chuyện như một con người, OpenAI cảnh báo rằng chúng có thể đã gặp phải các vấn đề cơ bản về mở rộng quy mô, với GPT-3 yêu cầu vài nghìn petaflop / s-ngày tính toán , so với hàng chục petaflop / s-ngày cho GPT-2 đầy đủ. Có vẻ như trong khi chúng ta đang ở gần nhau hơn, bước đột phá sẽ khiến tất cả các công việc của chúng ta trở nên lỗi thời vẫn còn ở một khoảng cách xa.

Đọc thêm về GPT-3 tại GitHub tại đây.