Mô hình nguồn mở Mixtral 8x22B cuối cùng đã xuất hiện, có thể tải xuống qua Torrent

Mấy ngày nay ngành công nghiệp AI thật bận rộn

2 phút đọc

Được đăng trên

Đọc trang tiết lộ của chúng tôi để tìm hiểu cách bạn có thể giúp MSPoweruser duy trì nhóm biên tập Tìm hiểu thêm

Ghi chú chính

- Mistral đã tung ra mô hình tiên phong của mình, Mixtral 8x22B, khi cuộc đua về AI ngày càng nóng lên.

- Mô hình nguồn mở có 176B tham số và độ dài ngữ cảnh là 65K mã thông báo

- Nó có thể tải xuống thông qua Torrent.

Mistral trở lại với một thông báo quan trọng. Trước đó vào thứ Tư, công ty Pháp được Microsoft hậu thuẫn đã ra mắt mô hình tiên phong của mình, Mixtral 8x22B, khi cuộc đua về AI nóng lên.

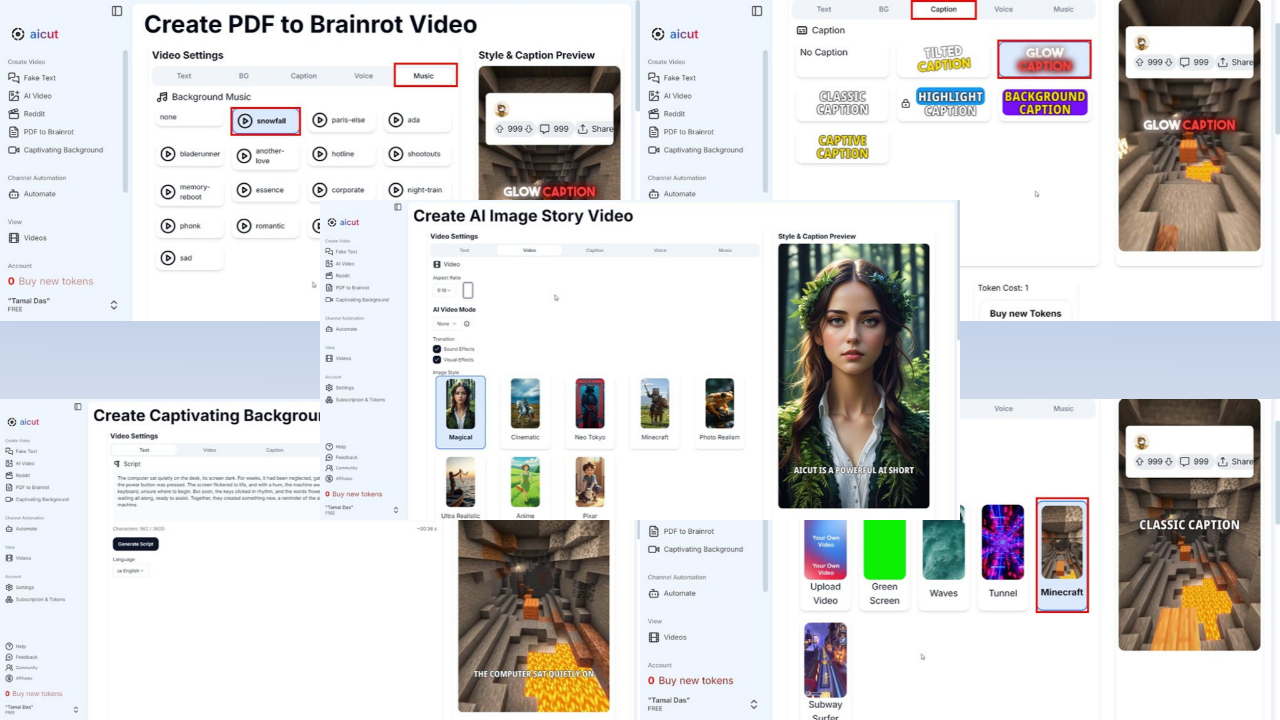

Phần tốt nhất của nó? Đây là một hệ thống nguồn mở và bạn có thể tải xuống qua Torrent với kích thước tệp 281GB khi khởi động AI đã đăng liên kết Magnet của nó trên X (trước đây gọi là Twitter). Nó hiện cũng có sẵn trên ÔmKhuôn Mặt và Phòng thí nghiệm AI bối rối.

Mistral chủ yếu bao gồm các nhân viên cũ của Google và Meta. Model tiền nhiệm của công ty, Mixtral 8x7B, đã được phát động trở lại vào tháng 2 năm ngoái, nhưng nó được cho là đã vượt trội hơn các đối thủ như Llama-70 3.5B và GPT-XNUMX của OpenAI ở một số điểm chuẩn nhất định như MMLU, ARC Challenge, MBPP và các đối thủ khác.

Hiện tại, Mixtral 8x22B có 176B tham số và độ dài ngữ cảnh là 65K mã thông báo. Mặc dù rất lớn nhưng nó chỉ sử dụng một phần nhỏ hơn (44B) cho mỗi tác vụ, khiến nó có giá cả phải chăng hơn khi sử dụng.

Đây chắc chắn là một trong 24 giờ bận rộn nhất trong ngành AI. Google cuối cùng đã thực hiện Đã có bản Gemini 1.5 Pro ở hầu hết các quốc gia và đổi tên thương hiệu Duet AI for Developers thành Hỗ trợ mã Gemini, chuyển cơ sở hạ tầng từ Codey sang Gemini.

Một tin tức khác từ Meta, Thông tin đã đưa tin độc quyền rằng chủ sở hữu Facebook đã sẵn sàng ra mắt phiên bản Llama 3 nhỏ hơn vào tuần tới.

Diễn đàn người dùng

Tin nhắn 0