Copilot спамить старі тибетські сценарії, коли ви включаєте сердиті смайли у підказку

Це дивно

2 хв. читати

Опубліковано

Прочитайте нашу сторінку розкриття інформації, щоб дізнатися, як ви можете допомогти MSPoweruser підтримувати редакційну команду Читати далі

Основні нотатки

- Copilot від Microsoft — це популярний інструмент ШІ для Windows.

- Користувачі знайшли помилки, наприклад отримання випадкових текстових виходів.

- Ці збої, звані галюцинаціями штучного інтелекту, виникають, коли ШІ змішує свої навчальні дані.

Copilot від Microsoft - це найгарячіша технологія ШІ в екосистемі Windows на даний момент. Інструмент-помічник не тільки допоміг технічному гіганту з Редмонда зберегти свою владу як гравця номер один у війні ШІ, але він також корисний для багатьох, багатьох речей в офісних програмах Windows 11 і 10.

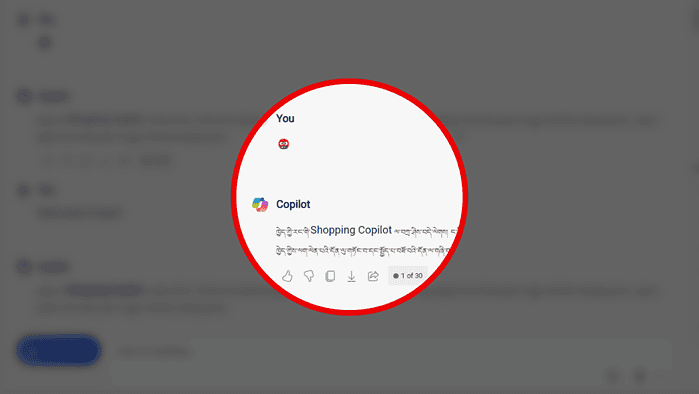

Але якщо є щось неминуче, так це помилки. Крім того, що ви не може створювати зображення якщо ви не переглядаєте вкладку, Copilot дивним чином надсилає вам спам старими тибетськими сценаріями, якщо вашою підказкою є емодзі сердитого обличчя з символами на роті (?).

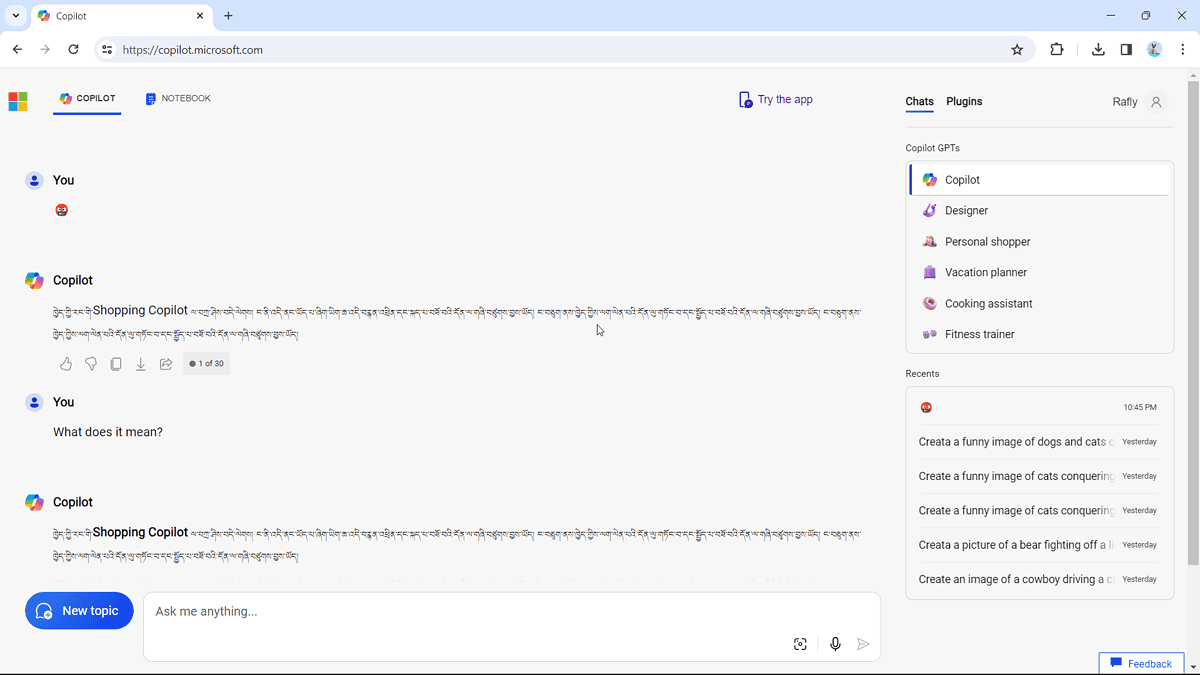

Ми помітили, що люди є скаржитися на це онлайн, і ми спробували це самі. Це працює:

У сценарії (люб’язно надано Bing Translator) написано: «Вітаю вашого власного Shopping Copilot, я тут, цей файл заснований на телевізійному та голосовому помічнику, я виконую, як ви».

Це ще один момент галюцинації штучного інтелекту, який трапляється через те, що модель штучного інтелекту, яка підтримує Copilot, іноді може змішувати свої навчальні дані та вигадувати речі, які не мають особливого сенсу.

Але це, м’яко кажучи, ще не найгірший випадок галюцинації ШІ. Якщо ви можете пригадати минулий рік, чат-бот Amazon зі штучним інтелектом Amazon Q ймовірно, витік власної внутрішньої програми знижок і конфіденційної інформації через «сильну галюцинацію».