GPT-3 คืออะไรและจะส่งผลต่องานปัจจุบันของคุณอย่างไร

3 นาที. อ่าน

อัปเดตเมื่อวันที่

อ่านหน้าการเปิดเผยข้อมูลของเราเพื่อดูว่าคุณจะช่วย MSPoweruser รักษาทีมบรรณาธิการได้อย่างไร อ่านเพิ่มเติม

GPT ย่อมาจาก Generative Pre-training Transformer (GPT) ซึ่งเป็นโมเดลภาษาที่เขียนโดย Alec Radford และเผยแพร่ในปี 2018 โดย OpenAI ห้องปฏิบัติการวิจัยปัญญาประดิษฐ์ของ Elon Musks มันใช้แบบจำลองกำเนิดของภาษา (โดยที่โครงข่ายประสาทเทียมสองโครงข่ายสมบูรณ์แบบซึ่งกันและกันโดยการแข่งขัน) และสามารถรับความรู้เกี่ยวกับโลกและประมวลผลการพึ่งพาระยะยาวโดยการฝึกอบรมล่วงหน้าเกี่ยวกับชุดเอกสารที่หลากหลายซึ่งมีข้อความต่อเนื่องกันยาวเหยียด

GPT-2 (Generative Pretrained Transformer 2) ได้รับการประกาศในเดือนกุมภาพันธ์ 2019 และเป็นแบบจำลองภาษาของหม้อแปลงไฟฟ้าที่ไม่มีผู้ดูแลซึ่งได้รับการฝึกฝนในเอกสาร 8 ล้านฉบับ รวมข้อความ 40 GB จากบทความที่แชร์ผ่านการส่ง Reddit Elon Musk โด่งดังอย่างไม่เต็มใจที่จะปล่อยมันออกมาในขณะที่เขากังวลว่ามันจะถูกนำมาใช้เพื่อสแปมเครือข่ายสังคมออนไลน์ด้วยข่าวปลอม

ในเดือนพฤษภาคม 2020 OpenAI ได้ประกาศ GPT-3 (Generative Pretrained Transformer 3) ซึ่งเป็นแบบจำลองที่มีลำดับความสำคัญมากกว่าสองพารามิเตอร์กว่า GPT-2 (175 พันล้านเทียบกับ 1.5 พันล้านพารามิเตอร์) และมีการปรับปรุงอย่างมากเหนือ GPT-2

เมื่อได้รับข้อความแจ้ง GPT-3 จะส่งคืนข้อความที่สมบูรณ์ โดยพยายามจับคู่รูปแบบที่คุณให้ไว้ คุณสามารถ “ตั้งโปรแกรม” ได้โดยแสดงตัวอย่างเพียงไม่กี่ตัวอย่างเกี่ยวกับสิ่งที่คุณต้องการทำ และมันจะนำเสนอบทความหรือเรื่องราวที่สมบูรณ์ เช่น ข้อความด้านล่าง ซึ่งเขียนโดย GPT-3 ทั้งหมด

GPT-3 มีประสิทธิภาพที่ยอดเยี่ยมในชุดข้อมูล NLP จำนวนมาก รวมถึงงานการแปล การตอบคำถาม และการปิดข้อความ ตลอดจนงานหลายอย่างที่ต้องใช้การให้เหตุผลแบบทันทีทันใดหรือการปรับโดเมน เช่น การถอดรหัสคำ การใช้คำใหม่ใน ประโยคหรือการคำนวณเลข 3 หลัก GPT-3 สามารถสร้างตัวอย่างบทความข่าวที่ผู้ประเมินที่เป็นมนุษย์มีปัญหาในการแยกแยะจากบทความที่เขียนโดยมนุษย์

แอปพลิเคชั่นสุดท้ายทำให้ OpenAI กังวลอยู่เสมอ ปัจจุบัน GPT-3 เปิดให้ใช้งานเป็นโอเพ่นเบต้า โดยที่เบต้าส่วนตัวแบบชำระเงินจะพร้อมใช้งานในที่สุด OpenAI กล่าวว่าพวกเขาจะยุติการเข้าถึง API สำหรับกรณีการใช้งานที่เป็นอันตรายอย่างเห็นได้ชัด เช่น การล่วงละเมิด สแปม การทำให้รุนแรงขึ้น หรือ astroturfing

แม้ว่าประชากรที่ถูกคุกคามอย่างเห็นได้ชัดที่สุดคือผู้ที่ผลิตงานเขียน เช่น นักเขียนบท นักพัฒนา AI ได้พบแอปพลิเคชั่นที่น่าประหลาดใจแล้ว เช่น การใช้ GPT-3 เพื่อเขียนโค้ด

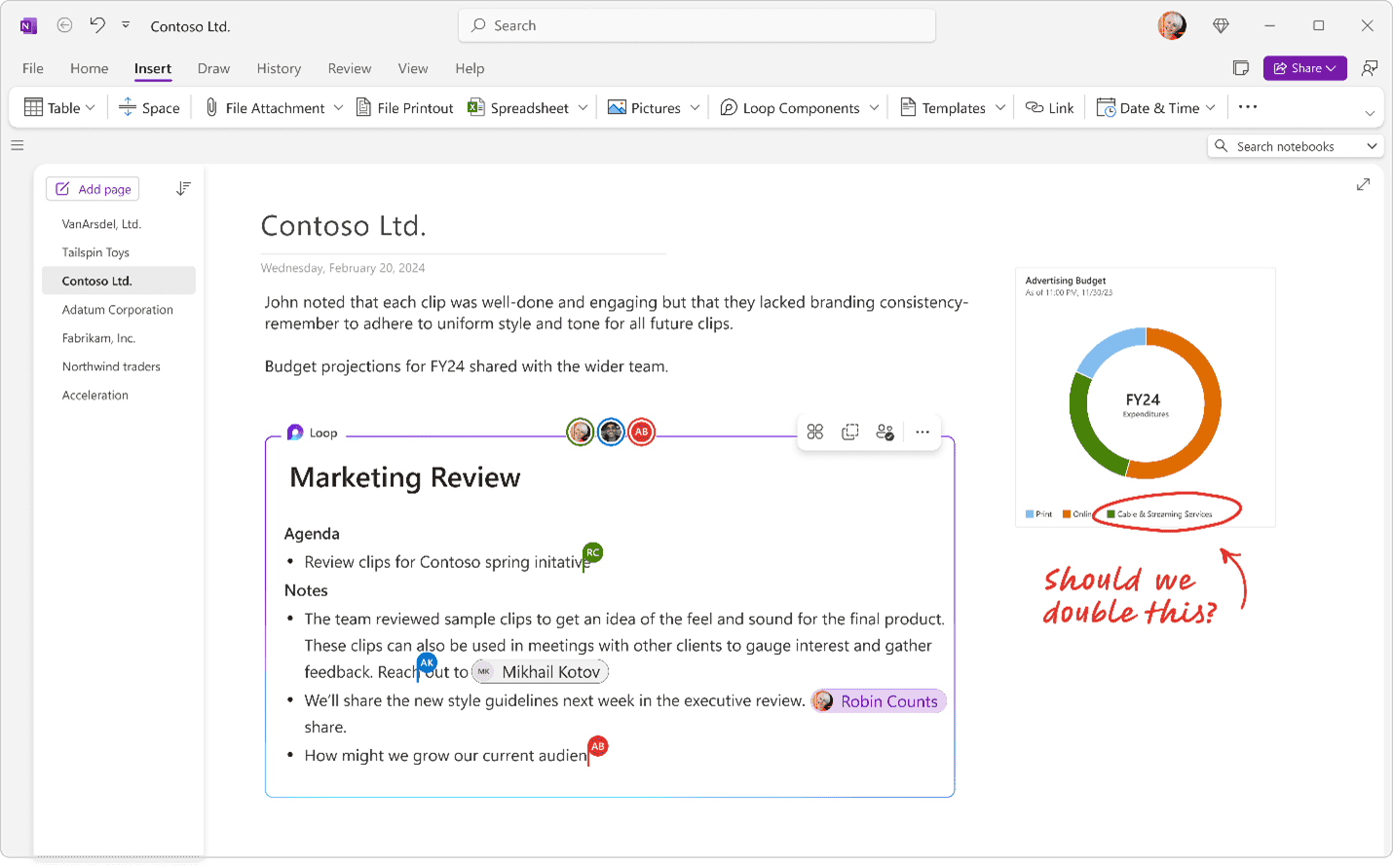

ตัวอย่างเช่น ชารีฟ ชามีม เขียนโปรแกรมสร้างเลย์เอาต์ที่คุณอธิบายสิ่งที่คุณต้องการเป็นข้อความธรรมดา และโมเดลจะสร้างโค้ดที่เหมาะสม

นี่มันกวนประสาทสุดๆ

ด้วย GPT-3 ฉันได้สร้างตัวสร้างเลย์เอาต์ที่คุณเพียงแค่อธิบายเลย์เอาต์ที่คุณต้องการ และสร้างโค้ด JSX ให้กับคุณ

อะไร pic.twitter.com/w8JkrZO4lk

— ชารีฟชามีม (@sharifshameem) กรกฎาคม 13, 2020

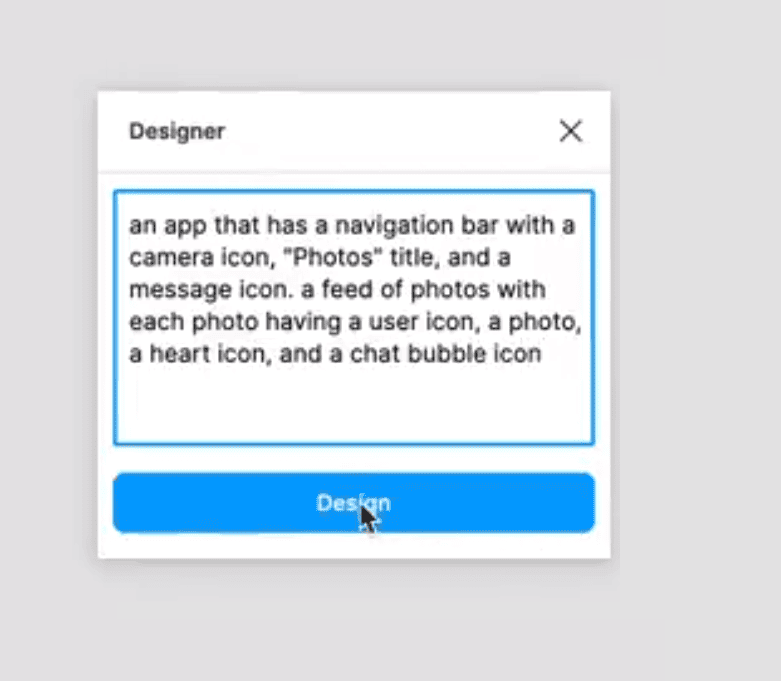

Jordan Singer ได้สร้างปลั๊กอิน Figma ในทำนองเดียวกันซึ่งอนุญาตให้สร้างแอปโดยใช้คำอธิบายข้อความธรรมดา

สิ่งนี้เปลี่ยนแปลงทุกอย่าง ?

ด้วย GPT-3 ฉันได้สร้างปลั๊กอิน Figma เพื่อออกแบบสำหรับคุณ

ฉันเรียกมันว่า "นักออกแบบ" pic.twitter.com/OzW1sKNLEC

— นักร้องจอร์แดน (@jsngr) กรกฎาคม 18, 2020

สามารถใช้วินิจฉัยโรคหอบหืดและสั่งยาได้

So @เปิดเอไอ ได้ให้สิทธิ์ฉันในการเข้าถึงเครื่องมือก่อนใคร ซึ่งช่วยให้นักพัฒนาใช้สิ่งที่เป็นเครื่องกำเนิดข้อความที่ทรงพลังที่สุดเท่าที่เคยมีมา ฉันคิดว่าฉันจะทดสอบโดยถามคำถามทางการแพทย์ ข้อความตัวหนาคือข้อความที่สร้างขึ้นโดย AI เหลือเชื่อ… (1/2) pic.twitter.com/4bGfpI09CL

— กาซิม มุนเย (@qasimmunye) กรกฎาคม 2, 2020

แอปพลิเคชันอื่นๆ เป็นเหมือนเสิร์ชเอ็นจิ้นหรือคำพยากรณ์ และสามารถใช้เพื่ออธิบายและขยายแนวคิดที่ยากได้

ฉันสร้างเสิร์ชเอ็นจิ้นที่ทำงานได้อย่างสมบูรณ์บน GPT3

สำหรับข้อความค้นหาใดๆ ก็ตาม ระบบจะส่งคืนคำตอบที่ถูกต้องและ URL ที่เกี่ยวข้อง

ดูวิดีโอทั้งหมด มันดีมาก

ซีซี: @gdb @นพิว @กวิน pic.twitter.com/9ismj62w6l

— พาราส โชปรา (@paraschopra) กรกฎาคม 19, 2020

ดูเหมือนว่าแนวทางนี้อาจนำไปสู่ AI ทั่วไปโดยตรงที่สามารถเข้าใจ ให้เหตุผล และสนทนาได้เหมือนมนุษย์ แต่ OpenAI เตือนว่าพวกเขาอาจประสบปัญหาในการปรับขนาดพื้นฐาน โดย GPT-3 ต้องใช้การคำนวณหลายพันเพตาฟลอป/วินาที เทียบกับหลายสิบเพตาฟลอป/วินาที-วันสำหรับ GPT-2 แบบเต็ม ดูเหมือนว่าในขณะที่เราใกล้ชิดกันมากขึ้น ความก้าวหน้าที่จะทำให้งานทั้งหมดของเราล้าสมัยยังห่างไกลออกไปบ้าง

อ่านเพิ่มเติมเกี่ยวกับ GPT-3 ที่ GitHub ที่นี่