ในที่สุดรุ่นโอเพ่นซอร์ส Mixtral 8x22B ก็มาถึงแล้ว โดยสามารถดาวน์โหลดผ่าน Torrent ได้

จนถึงขณะนี้ อุตสาหกรรม AI ยุ่งวุ่นวายมาหลายวันแล้ว

2 นาที. อ่าน

เผยแพร่เมื่อ

อ่านหน้าการเปิดเผยข้อมูลของเราเพื่อดูว่าคุณจะช่วย MSPoweruser รักษาทีมบรรณาธิการได้อย่างไร อ่านเพิ่มเติม

หมายเหตุสำคัญ

- Mistral เปิดตัวโมเดลแนวหน้า Mixtral 8x22B ในขณะที่การแข่งขันเพื่อ AI ดุเดือดมากขึ้น

- โมเดลโอเพ่นซอร์สมีพารามิเตอร์ 176B และความยาวบริบทของโทเค็น 65K

- สามารถดาวน์โหลดได้ผ่านทาง Torrent

มิสทรัลกลับมาพร้อมกับประกาศสำคัญ ก่อนหน้านี้ในวันพุธ บริษัทฝรั่งเศสที่ได้รับการสนับสนุนจาก Microsoft ได้เปิดตัวโมเดลแนวหน้า Mixtral 8x22B ในขณะที่การแข่งขันสำหรับ AI เริ่มร้อนแรง

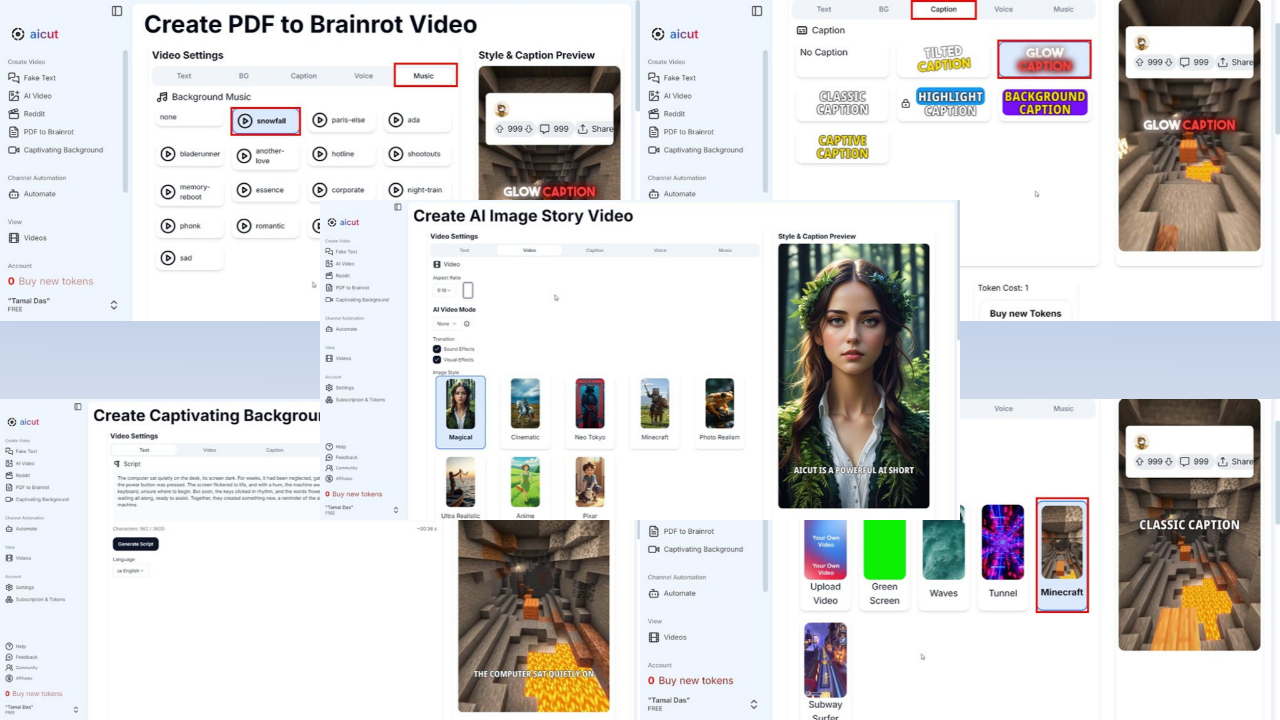

ส่วนที่ดีที่สุดของมัน? มันเป็นระบบโอเพ่นซอร์สและคุณสามารถดาวน์โหลดผ่าน Torrent ที่ขนาดไฟล์ 281GB เป็นการเริ่มต้น AI โพสต์ลิงก์แม่เหล็ก บน X (เดิมชื่อ Twitter) ตอนนี้มีจำหน่ายแล้วที่ กอดใบหน้า และ ห้องทดลอง AI แห่งความฉงนสนเท่ห์.

Mistral ส่วนใหญ่ประกอบด้วยอดีตพนักงานของ Google และ Meta รุ่นก่อนของบริษัทคือ Mixtral 8x7B เปิดตัว ย้อนกลับไปในเดือนธันวาคมปีที่แล้ว แต่มีการกล่าวกันว่ามีประสิทธิภาพเหนือกว่าคู่แข่งอย่าง Llama-2 70B และ GPT-3.5 ของ OpenAI ในการวัดประสิทธิภาพบางอย่าง เช่น MMLU, ARC Challenge, MBPP และอื่นๆ

ตอนนี้ Mixtral 8x22B มีพารามิเตอร์ 176B และความยาวบริบทเท่ากับ 65K โทเค็น แม้ว่าจะมีขนาดใหญ่ แต่ก็ใช้เพียงชิ้นส่วนที่เล็กกว่า (44B) สำหรับแต่ละงาน ทำให้มีราคาไม่แพงในการใช้งาน

ไม่ต้องสงสัยเลยว่านี่เป็นหนึ่งใน 24 ชั่วโมงที่ยุ่งที่สุดในอุตสาหกรรม AI ในที่สุด Google ก็ได้ทำ ราศีเมถุน 1.5 Pro พร้อมใช้งาน ในประเทศส่วนใหญ่และเปลี่ยนชื่อแบรนด์ Duet AI สำหรับนักพัฒนาเป็น ช่วยเหลือรหัสราศีเมถุนโดยย้ายโครงสร้างพื้นฐานจาก Codey ไปยัง Gemini

อีกข่าวจากเมต้า ข้อมูล ได้รายงานโดยเฉพาะว่าเจ้าของ Facebook พร้อมที่จะเปิดตัวเวอร์ชั่น Llama 3 ที่เล็กกว่าในสัปดาห์หน้า

ฟอรั่มผู้ใช้

ข้อความ 0