Microsoft อธิบายว่าเหตุใด LLM จึงเกิดอาการประสาทหลอนและสร้างคำตอบ

2 นาที. อ่าน

อัปเดตเมื่อวันที่

อ่านหน้าการเปิดเผยข้อมูลของเราเพื่อดูว่าคุณจะช่วย MSPoweruser รักษาทีมบรรณาธิการได้อย่างไร อ่านเพิ่มเติม

การแลกเปลี่ยน Twitter เมื่อเร็วๆ นี้ระหว่างผู้ใช้และผู้บริหารของ Microsoft ได้ดึงความสนใจครั้งใหม่มาสู่ข้อจำกัดของโมเดลภาษาขนาดใหญ่ (LLM) เช่น Bing และโอกาสที่จะเกิดช่องว่างของข้อมูลเมื่ออาศัยความรู้ภายในของพวกเขาเพียงอย่างเดียว

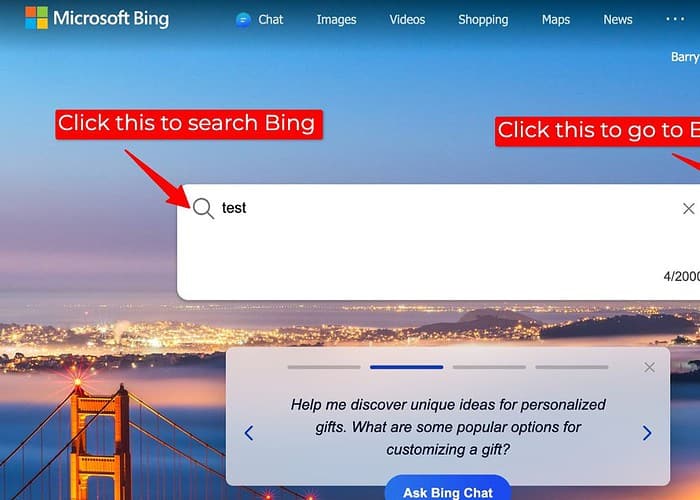

การสนทนาเกิดขึ้นจากผู้ใช้รายงานผลการค้นหาที่ไม่ถูกต้องบน Bing เมื่อปลั๊กอินการค้นหาซึ่งเข้าถึงข้อมูลเว็บภายนอกถูกปิดใช้งาน ในการตอบสนอง มิคาอิล Parakhin ซีอีโอของการโฆษณาและบริการเว็บของ Microsoft ยอมรับความเป็นไปได้ที่ LLM จะ "สร้างสถานการณ์" ในสถานการณ์เช่นนี้

เขาอธิบายว่าเมื่อขาดข้อมูลมากมายที่มีอยู่บนเว็บ บางครั้ง LLM อาจหันไปใช้ฐานความรู้ภายใน ซึ่งเป็นชุดของข้อความและโค้ดที่ใช้สำหรับการฝึกอบรม เพื่อสร้างการตอบกลับ อย่างไรก็ตาม การสร้างภายในนี้อาจไม่ถูกต้องหรือสอดคล้องกับความเป็นจริงเสมอไป ซึ่งนำไปสู่ความคลาดเคลื่อนในผลการค้นหาเมื่อเทียบกับที่ได้รับเมื่อเปิดใช้งานปลั๊กอินการค้นหา

สำหรับฉัน สิ่งนี้ทำให้เกิดคำถามสำคัญเกี่ยวกับความโปร่งใสและความถูกต้องในการค้นหาที่ขับเคลื่อนด้วย LLM โดยเฉพาะอย่างยิ่งเมื่อแหล่งข้อมูลภายนอกไม่พร้อมใช้งาน เมื่อ LLM สร้างการตอบสนองโดยไม่ต้องเข้าถึงข้อมูลภายนอก ผู้ใช้ควรได้รับการระบุแหล่งที่มาของข้อมูลและข้อจำกัดที่อาจเกิดขึ้นอย่างชัดเจน

แม้ว่าการให้คำตอบจะมีคุณค่า แต่ LLM จะต้องจัดลำดับความสำคัญของข้อมูลที่เชื่อถือได้มากกว่าการเติมช่องว่างความรู้ด้วยรุ่นภายในที่อาจไม่ถูกต้อง การสำรวจแนวทางอื่น เช่น การระบุความไม่แน่นอน การแนะนำการวิจัยเพิ่มเติม หรือเพียงระบุว่าไม่มีคำตอบ สามารถเพิ่มความไว้วางใจและป้องกันการแพร่กระจายของข้อมูลที่ผิดได้

จึงไม่น่าแปลกใจว่าทำไม ผู้คนชอบ ChatGPT มากกว่า Bing Chat/Copilot

และด้วยเหตุผลเหล่านี้ โดยส่วนตัวแล้วฉันชอบใช้ Bard มากกว่าเพราะ Google ได้จัดเตรียมฟังก์ชันการทำงานที่ Bard ช่วยให้ผู้ใช้ทราบว่าข้อมูลนั้นอ้างอิงมาจากที่อื่นหรือไม่ ทำให้ผู้ใช้เชื่อถือข้อมูลได้ง่ายขึ้น

ฟอรั่มผู้ใช้

ข้อความ 0