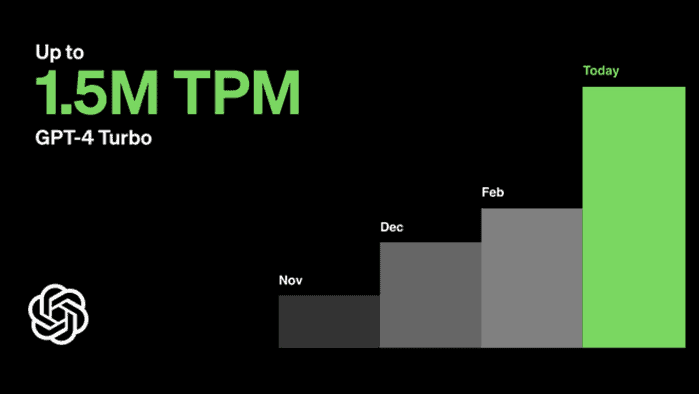

OpenAI fördubblar nu GPT-4 Turbo-hastighetsgränser, nu upp till 1.5 miljoner tokens per minut

Modellen lanserades för första gången förra året.

2 min. läsa

Publicerad den

Läs vår informationssida för att ta reda på hur du kan hjälpa MSPoweruser upprätthålla redaktionen Läs mer

Viktiga anteckningar

- OpenAI har fördubblat GPT-4 Turbo-hastighetsgränser universellt.

- Det ger nu maximalt 1.5 miljoner tokens per minut (TPM).

- Takstgränser, som åläggs på organisationsnivåer, är restriktioner för API-åtkomst för att förhindra missbruk.

Det var ett tag sedan OpenAI lanserades för första gången GPT-4 Turbo tillbaka i november förra året på OAI:s DevDay-evenemang. Vid den tiden sa det Microsoft-stödda företaget att modellen stöder 128K tokens: indatatokens är 3x billigare och outputtokens är 2x billigare än GPT-4.

Nu verkar det som att saker och ting håller på att förändras. Företaget har ökade GPT-4 turbohastighetsgränser dubbelt universellt, eliminerade dagliga gränser helt, och ger nu en högst 1.5 miljoner tokens per minut (TPM).

Om du inte är bekant är hastighetsbegränsningar, som åläggs på organisationsnivåer, restriktioner för API-åtkomst för att förhindra missbruk, säkerställa rättvisa och hantera infrastrukturbelastning. De förhindrar skadlig överbelastning av API:t, säkerställer rättvis åtkomst för alla användare och upprätthåller smidig prestanda under perioder med hög efterfrågan genom att strypa antalet tillåtna förfrågningar inom en angiven tidsram.

Varje användning kommer med olika prisplaner. OpenAI erbjuder minst fem användningsnivåer: gratisversionen, som är begränsad till $100/månad, hela vägen till nivå 5 för $10,000 XNUMX/månad för större organisationer.

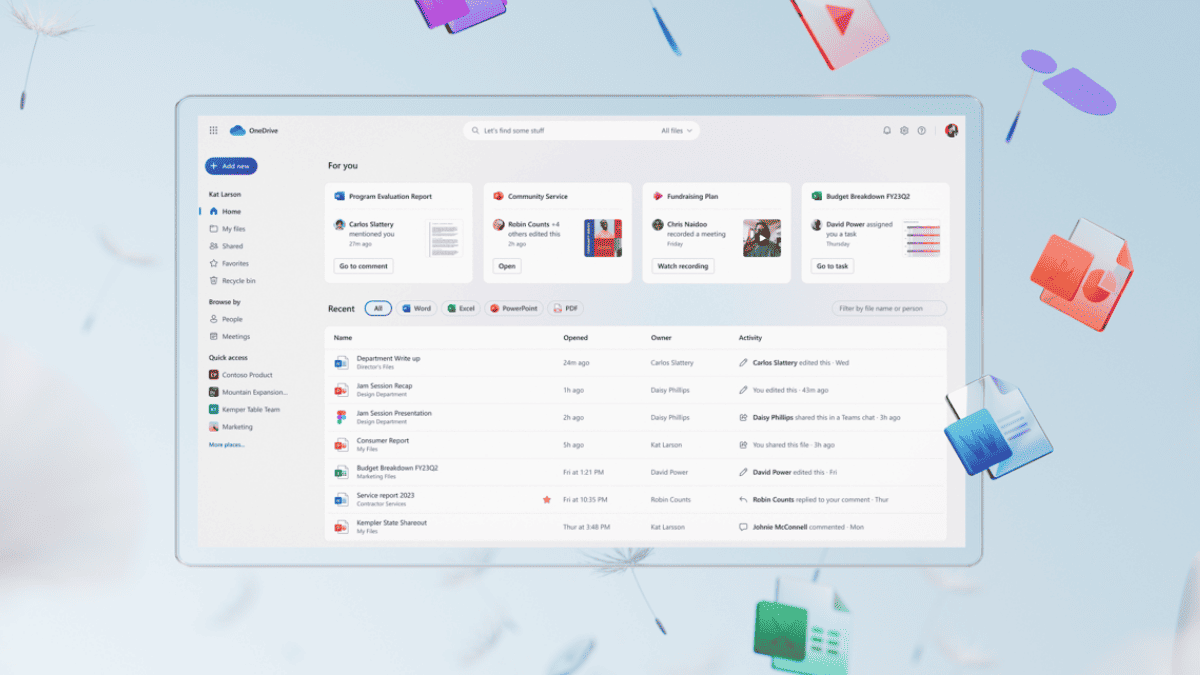

Du kan också utnyttja kraften i bildanalys med GPT-4 Turbo med Vision genom Azure OpenAI. Denna avancerade multimodala AI-modell kombinerar kapaciteten hos GPT-4 Turbo med förmågan att analysera bilder, så att du kan ställa frågor om bilder och få insiktsfulla textsvar.

Användarforum

0 meddelanden