Mixtral 8x22B öppen källkodsmodell har äntligen kommit, nedladdningsbar via Torrent

Det har varit några hektiska dagar i AI-branschen hittills

2 min. läsa

Publicerad den

Läs vår informationssida för att ta reda på hur du kan hjälpa MSPoweruser upprätthålla redaktionen Läs mer

Viktiga anteckningar

- Mistral lanserade sin frontiermodell, Mixtral 8x22B, när racet om AI hettas till.

- Modellen med öppen källkod har 176B parametrar och en kontextlängd på 65K tokens

- Det går att ladda ner via Torrent.

Mistral är tillbaka med ett stort tillkännagivande. Tidigare på onsdagen lanserade det franska, Microsoft-stödda företaget sin frontiermodell, Mixtral 8x22B, när kappseglingen om AI hettas till.

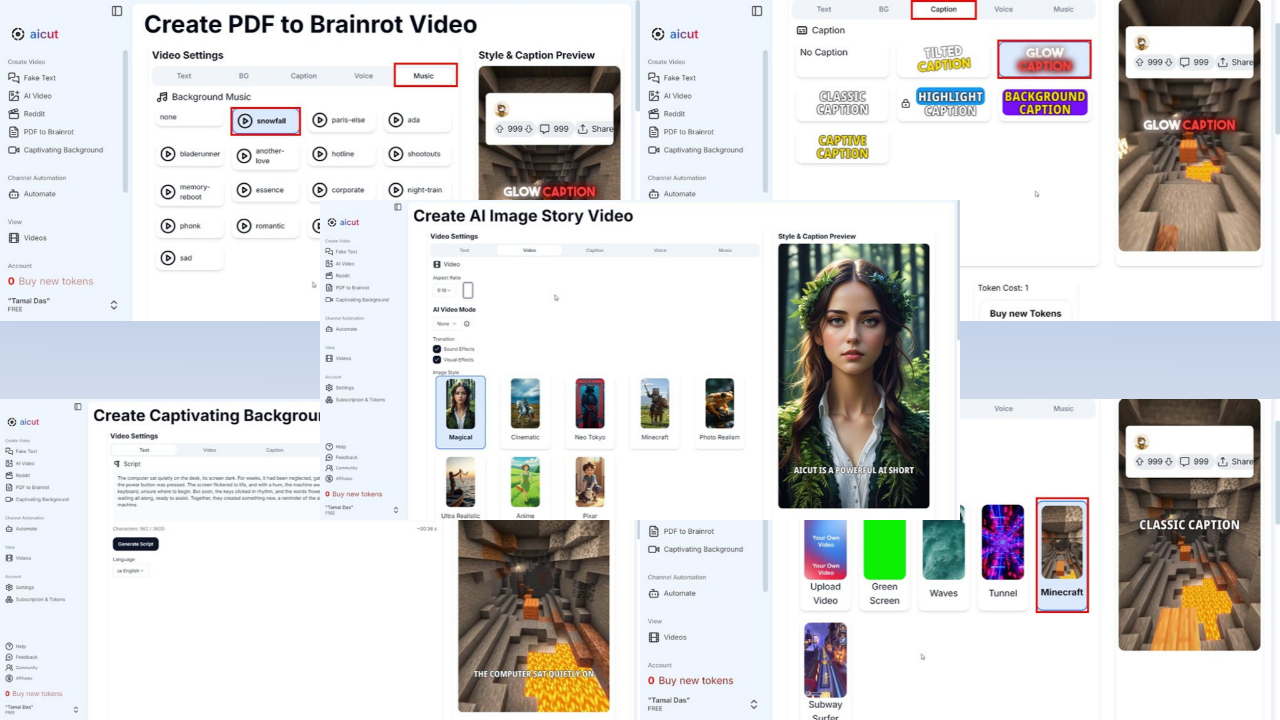

Den bästa delen av det? Det är ett system med öppen källkod, och du kan ladda ner det via Torrent med 281 GB i filstorlek som AI-start lade ut sin magnetlänk på X (tidigare känt som Twitter). Den finns nu även tillgänglig på Kramar ansikte och Perplexity AI Labs.

Mistral består till största delen av tidigare anställda på Google och Meta. Företagets föregångare, Mixtral 8x7B, var lanserades tillbaka i december förra året, men det sägs ha överträffat rivaler som Llama-2 70B och OpenAI:s GPT-3.5 i vissa benchmarks som MMLU, ARC Challenge, MBPP och andra.

Nu har Mixtral 8x22B 176B parametrar och en kontextlängd på 65K tokens. Även om den är enorm använder den bara en mindre del (44B) för varje uppgift, vilket gör den mer överkomlig att använda.

Det har utan tvekan varit en av de mest hektiska 24 timmarna i AI-branschen. Google har äntligen gjort Gemini 1.5 Pro tillgänglig i de flesta länder och döpte om sin Duet AI för utvecklare till Gemini Code Assist, flytta sin infrastruktur från Codey till Gemini.

Ytterligare en nyhet från Meta, Informationen har exklusivt rapporterat att Facebook-ägaren är redo att lansera en mindre Llama 3-version nästa vecka.

Användarforum

0 meddelanden