Фонд свободного программного обеспечения считает, что GitHub Copilot должен быть незаконным

3 минута. читать

Обновление

Прочтите нашу страницу раскрытия информации, чтобы узнать, как вы можете помочь MSPoweruser поддержать редакционную команду. Читать далее

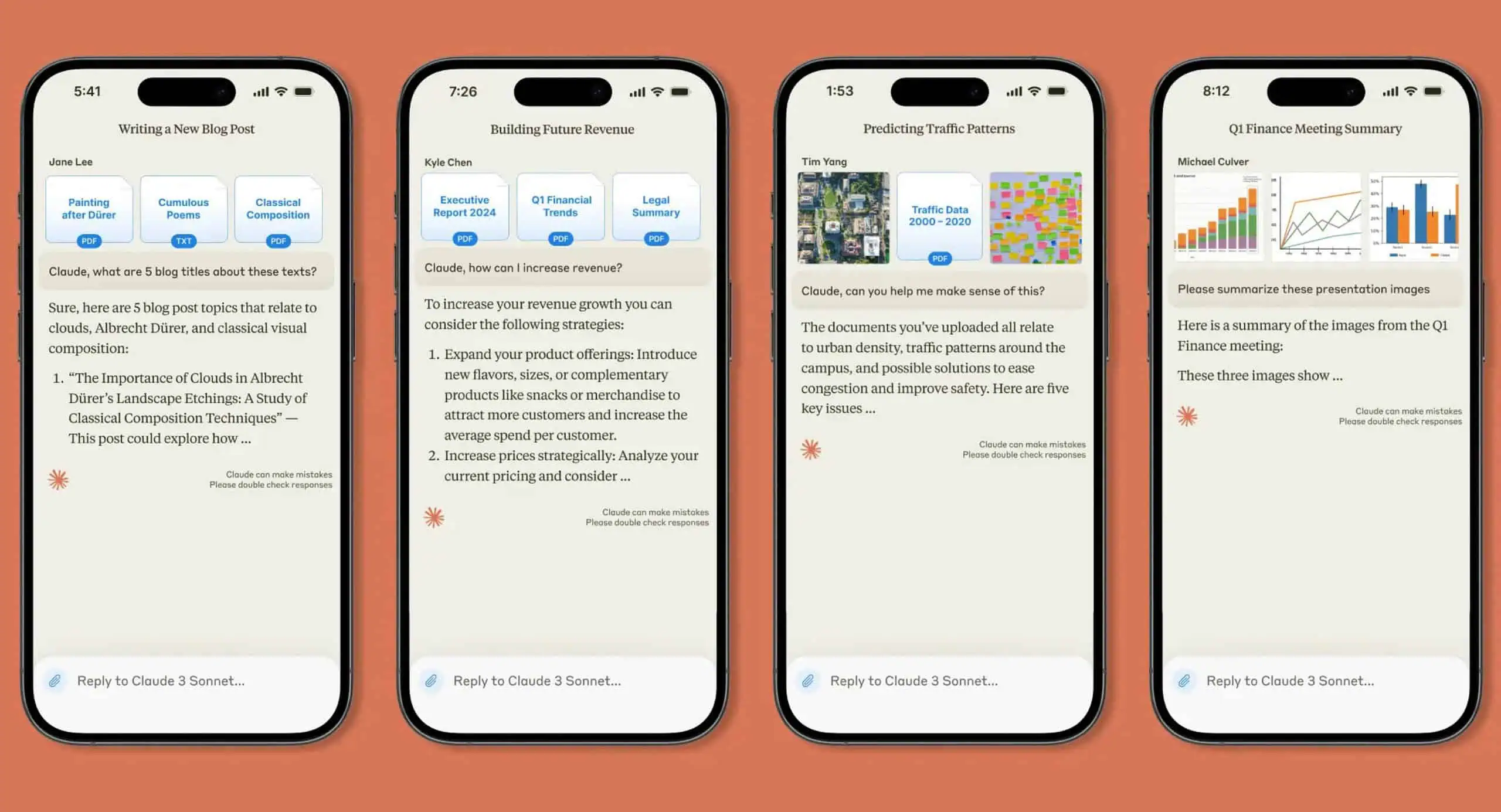

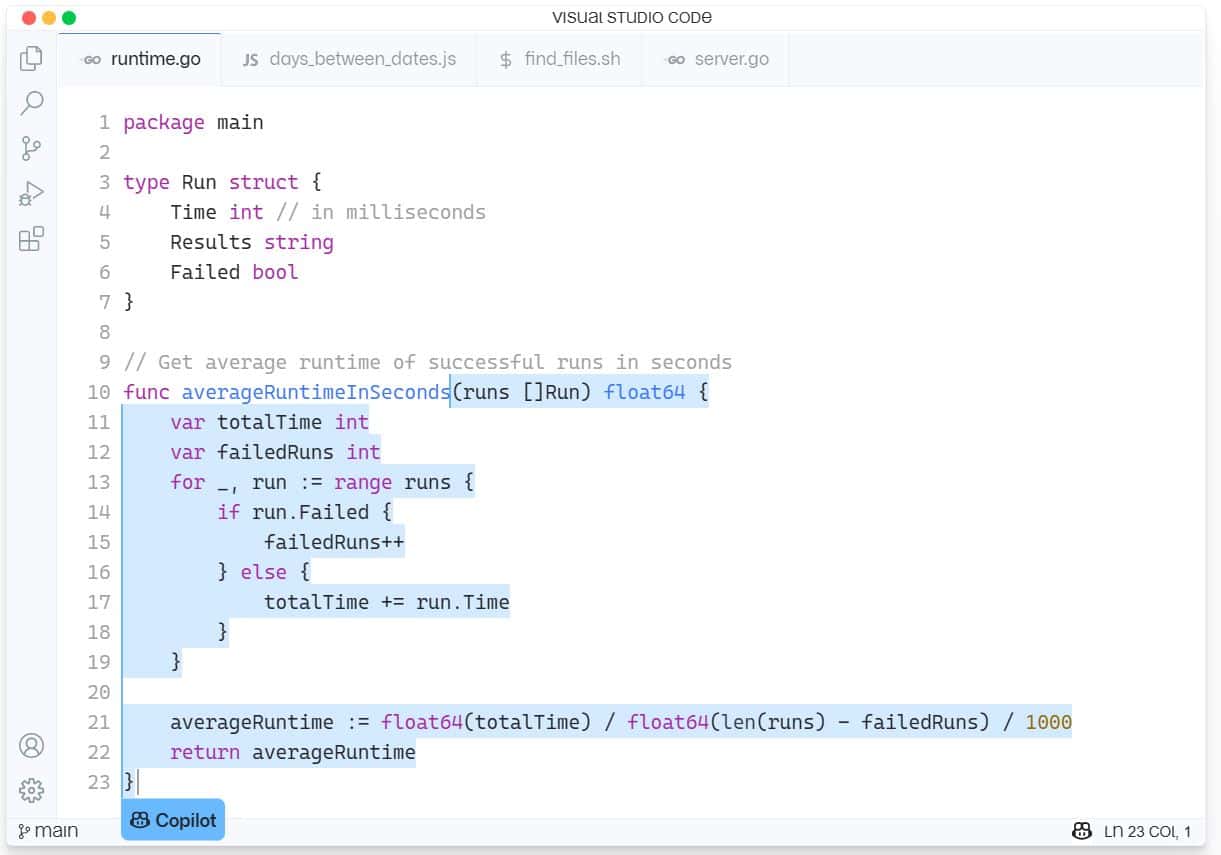

GitHub Copilot — это новая служба поддержки искусственного интеллекта для разработки программного обеспечения, встроенная в Visual Studio Code от Microsoft. GitHub Copilot поддерживает различные языки и фреймворки и облегчает жизнь разработчикам, предлагая варианты целых строк или целых функций прямо внутри IDE. GitHub Copilot работает на базе OpenAI Codex и прошел обучение на миллиардах строк кода с открытым исходным кодом.

Последняя проблема вызвала у Фонда свободного программного обеспечения (FSF) огромную пчелу в шляпе, назвав инструмент «неприемлемым и несправедливым, с нашей точки зрения».

Сторонник программного обеспечения с открытым исходным кодом жалуется, что для работы Copilot требуется программное обеспечение с закрытым исходным кодом, такое как Microsoft Visual Studio IDE или редактор кода Visual Studio, и что он представляет собой «сервис в качестве замены программного обеспечения», что означает, что это способ получить власть над вычислениями других людей.

FSF считает, что у второго пилота есть множество проблем, которые все еще необходимо проверить в суде.

«Разработчики хотят знать, можно ли считать обучение нейронной сети на их программном обеспечении добросовестным использованием. Другие, кто может захотеть использовать Copilot, задаются вопросом, могут ли фрагменты кода и другие элементы, скопированные из репозиториев, размещенных на GitHub, привести к нарушению авторских прав. И даже если все может быть юридически совместимо, активисты задаются вопросом, нет ли чего-то фундаментально несправедливого в том, что компания, занимающаяся проприетарным программным обеспечением, создает сервис на основе их работы», — пишет FSF.

Чтобы ответить на эти вопросы, FSF призвала к публикации официальных документов, в которых рассматриваются следующие вопросы:

- Является ли обучение второго пилота работе с публичными репозиториями нарушением авторских прав? Добросовестное использование?

- Насколько велика вероятность того, что результаты Copilot будут генерировать обоснованные заявления о нарушении работ под лицензией GPL?

- Могут ли разработчики, использующие Copilot, соблюдать лицензии на свободное программное обеспечение, такие как GPL?

- Как разработчики могут гарантировать, что код, на который они владеют авторскими правами, защищен от нарушений, создаваемых Copilot?

- Если Copilot генерирует код, приводящий к нарушению работы, лицензированной свободным программным обеспечением, как владелец авторских прав может обнаружить это нарушение?

- Защищена ли обученная модель AI/ML авторским правом? Кому принадлежат авторские права?

- Должны ли такие организации, как FSF, выступать за изменение закона об авторском праве, имеющее отношение к этим вопросам?

FSF заплатит 500 долларов за опубликованные официальные документы и может выделить дополнительные средства, если потребуются дальнейшие исследования.

Желающие оставить заявку могут отправить ее по адресу [электронная почта защищена] до 21 августа. Подробнее о процессе на FSF.org здесь.

Microsoft ответила на предстоящий вызов, заявив: «Это новое пространство, и мы стремимся участвовать в обсуждении с разработчиками по этим темам и возглавить отрасль в установлении соответствующих стандартов для обучения моделей ИИ».

Учитывая, что Copilot иногда крадет целые функции из других приложений с открытым исходным кодом, согласны ли наши читатели с FSF, или FSF лицемерит просто потому, что это ИИ, а не человеческий код? Сообщите нам свое мнение в комментариях ниже.

с помощью InfoWorld