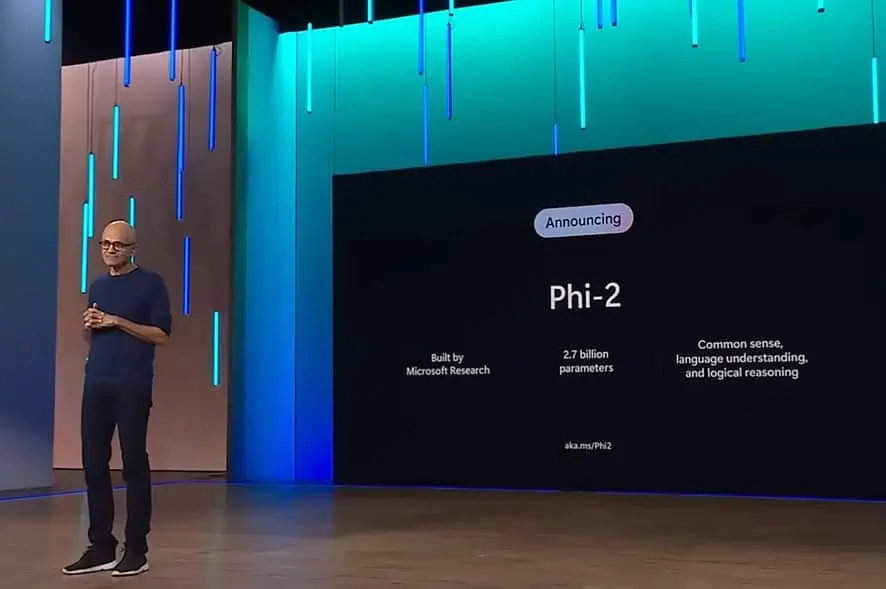

Modelul Microsoft Phi-2 2.7B depășește modelul Google Gemini Nano-2 3.2B anunțat recent

2 min. citit

Publicat în data de

Citiți pagina noastră de dezvăluire pentru a afla cum puteți ajuta MSPoweruser să susțină echipa editorială Află mai multe

În ultimele luni, Microsoft Research a lansat o suită de modele lingvistice mici (SLM) numită „Phi”. Phi-1 a fost lansat mai întâi cu 1.3 miliarde de parametri și a fost specializat pentru codificarea Python de bază. În septembrie, Microsoft Research eliberat Model Phi-1.5 cu 1.3 miliarde de parametri, dar a fost antrenat cu o nouă sursă de date care includea diverse texte sintetice NLP. În ciuda dimensiunilor sale mici, phi-1.5 a furnizat o performanță aproape de ultimă generație în comparație cu alte modele de dimensiuni similare.

Astăzi, Microsoft a anunțat lansarea modelului Phi-2 cu 2.7 miliarde de parametri. Microsoft Research susține că acest nou SLM oferă performanțe de ultimă generație printre modelele de limbaj de bază cu mai puțin de 13 miliarde de parametri. Pe unele benchmark-uri complexe, Phi-2 se potrivește sau depășește modelele de până la 25 de ori mai mari.

Săptămâna trecută, Google a anunțat Suita Gemini de modele de limbaj. Gemini Nano este cel mai eficient model Google construit pentru sarcini pe dispozitiv și poate rula direct pe siliciu mobil. Modelul de limbaj mic asemănător Gemini Nano permite funcții precum rezumarea textului, răspunsurile inteligente contextuale și corectarea avansată și corectarea gramaticală.

Potrivit Microsoft, noul model Phi-2 se potrivește sau depășește noul Google Gemini Nano-2, în ciuda faptului că este mai mic ca dimensiune. Puteți găsi mai jos comparația de referințe între modelele Google Gemini Nano-2 și Phi-2.

| Model | Mărimea | bbh | BoolQ | MBPP | MMLU |

|---|---|---|---|---|---|

| Gemeni Nano 2 | 3.2B | 42.4 | 79.3 | 27.2 | 55.8 |

| Phi-2 | 2.7B | 59.3 | 83.3 | 59.1 | 56.7 |

Pe lângă faptul că depășește Gemini Nano-2, Phi-2 depășește și performanța modelelor Mistral și Llama-2 la parametrii 7B și 13B pe diferite benchmark-uri. Găsiți detaliile mai jos.

| Model | Mărimea | bbh | Bun simț Raţionament | Limbă Înțelegerea | matematica | Codificare |

|---|---|---|---|---|---|---|

| Lama-2 | 7B | 40.0 | 62.2 | 56.7 | 16.5 | 21.0 |

| 13B | 47.8 | 65.0 | 61.9 | 34.2 | 25.4 | |

| 70B | 66.5 | 69.2 | 67.6 | 64.1 | 38.3 | |

| Mistral | 7B | 57.2 | 66.4 | 63.7 | 46.4 | 39.4 |

| Phi-2 | 2.7B | 59.2 | 68.8 | 62.0 | 61.1 | 53.7 |

În timp ce precedentele două modele phi au fost disponibile pe Hugging Face, Phi-2 a fost pus la dispoziție în catalogul de modele Azure. Puteți afla mai multe despre Phi-2 aici.