A Free Software Foundation acha que o GitHub Copilot deveria ser ilegal

3 minutos. ler

Atualizado em

Leia nossa página de divulgação para descobrir como você pode ajudar o MSPoweruser a sustentar a equipe editorial Saiba mais

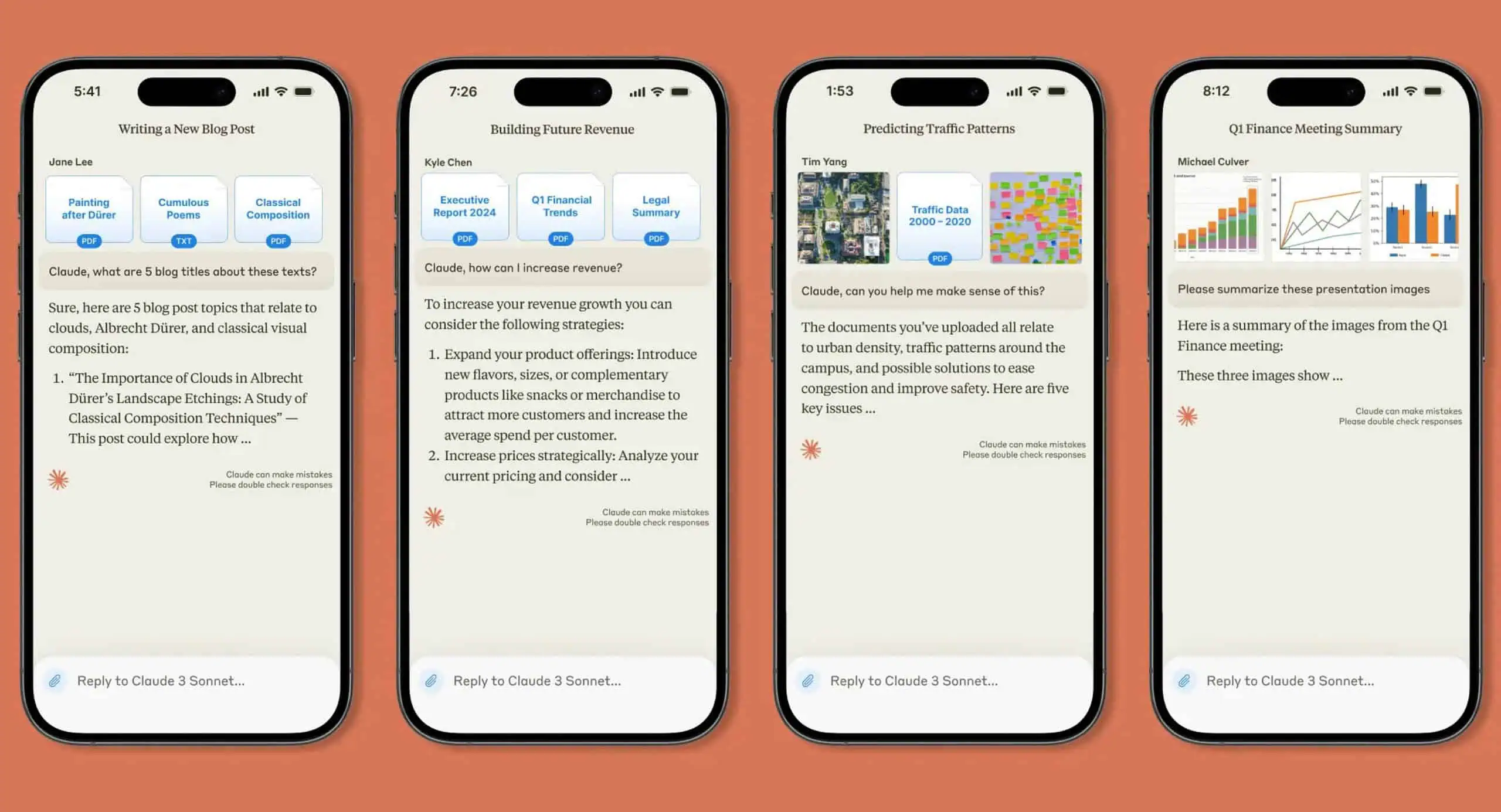

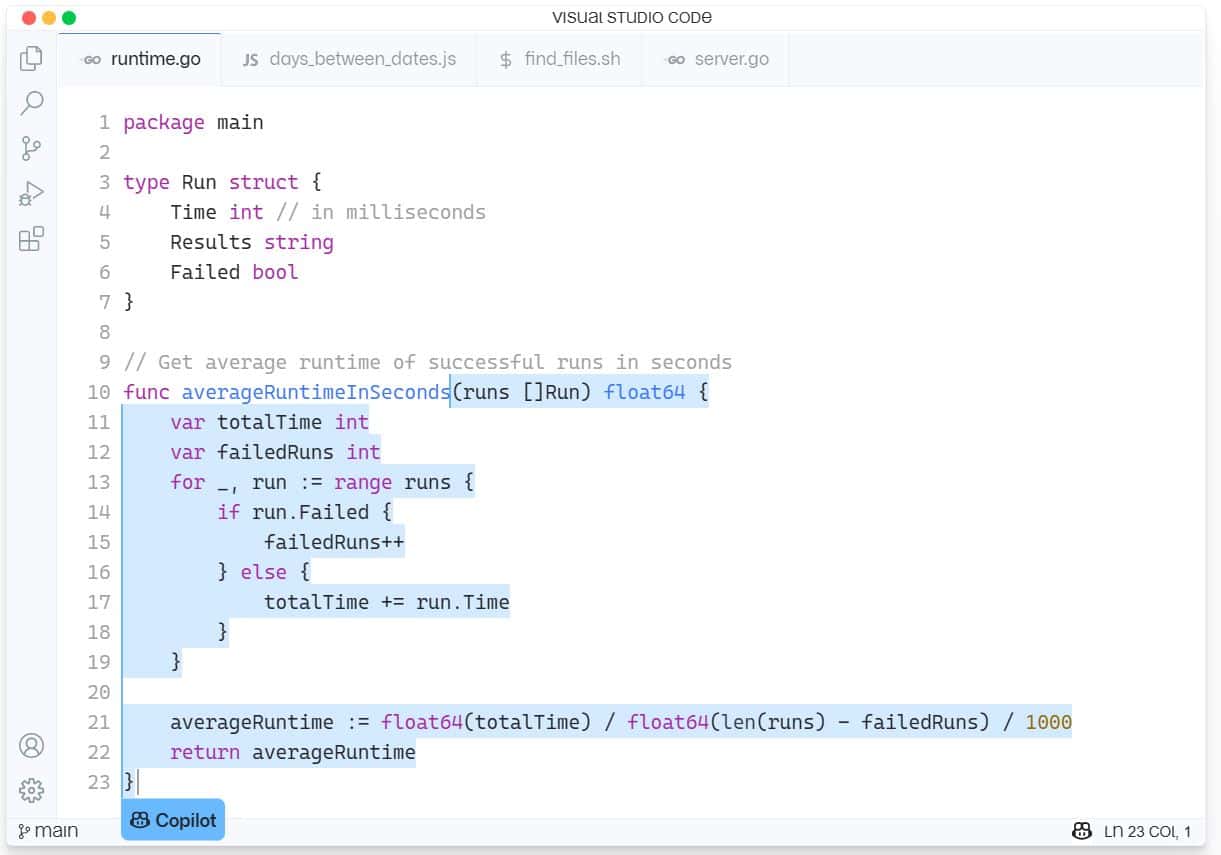

O GitHub Copilot é um novo serviço de assistência de IA para desenvolvimento de software integrado ao Visual Studio Code da Microsoft. O GitHub Copilot suporta uma variedade de linguagens e frameworks e facilita a vida dos desenvolvedores ao oferecer sugestões para linhas inteiras ou funções inteiras dentro do IDE. O GitHub Copilot é desenvolvido pelo OpenAI Codex e foi treinado em bilhões de linhas de código-fonte aberto.

O último problema fez com que a Free Software Foundation (FSF) tivesse uma enorme abelha em seu capô, chamando a ferramenta de “inaceitável e injusta, do nosso ponto de vista”.

O defensor do software de código aberto reclama que o Copilot exige que o software de código fechado, como o Visual Studio IDE da Microsoft ou o editor Visual Studio Code, seja executado e que constitui um “serviço como substituto de software”, o que significa que é uma maneira de ganhar poder sobre a computação de outras pessoas.

A FSF sentiu que havia vários problemas com o Copilot que ainda precisavam ser testados no tribunal.

“Os desenvolvedores querem saber se treinar uma rede neural em seu software pode ser considerado uso justo. Outros que podem querer usar o Copilot se perguntam se os trechos de código e outros elementos copiados de repositórios hospedados no GitHub podem resultar em violação de direitos autorais. E mesmo que tudo possa ser legalmente compatível, os ativistas se perguntam se não há algo fundamentalmente injusto sobre uma empresa de software proprietário construir um serviço a partir de seu trabalho”, escreveu a FSF.

A ajuda a responder a essas perguntas, a FSF solicitou white papers que examinam as seguintes questões:

- O treinamento do Copilot sobre repositórios públicos é violação de direitos autorais? Uso justo?

- Qual é a probabilidade de a saída do Copilot gerar reclamações acionáveis de violações de obras licenciadas pela GPL?

- Os desenvolvedores que usam o Copilot podem cumprir licenças de software livre como a GPL?

- Como os desenvolvedores podem garantir que o código do qual detêm os direitos autorais seja protegido contra violações geradas pelo Copilot?

- Se o Copilot gerar um código que dê origem a uma violação de um trabalho licenciado de software livre, como essa violação pode ser descoberta pelo detentor dos direitos autorais?

- Um modelo de IA/ML treinado tem direitos autorais? Quem detém os direitos autorais?

- Organizações como a FSF deveriam defender mudanças na lei de direitos autorais relevantes para essas questões?

A FSF pagará US$ 500 por white papers publicados e poderá liberar mais fundos se mais pesquisas forem necessárias.

Quem quiser fazer uma submissão pode enviar para [email protegido] antes de 21 de agosto. Leia mais sobre o processo em FSF.org aqui.

A Microsoft respondeu ao próximo desafio dizendo: “Este é um novo espaço e estamos ansiosos para participar de uma discussão com desenvolvedores sobre esses tópicos e liderar o setor na definição de padrões apropriados para o treinamento de modelos de IA”.

Dado que o Copilot às vezes rouba funções inteiras de outros aplicativos de código aberto, nossos leitores concordam com o FSF ou o FSF está sendo hipócrita simplesmente porque é uma IA em vez de um código de reaproveitamento humano? Deixe-nos saber sua opinião nos comentários abaixo.

via infoworld