O modelo de código aberto Mixtral 8x22B finalmente chegou, para download via Torrent

Os últimos dias têm sido agitados na indústria de IA até agora

2 minutos. ler

Publicado em

Leia nossa página de divulgação para descobrir como você pode ajudar o MSPoweruser a sustentar a equipe editorial Saiba mais

Notas chave

- A Mistral lançou seu modelo de fronteira, Mixtral 8x22B, enquanto a corrida pela IA esquentava.

- O modelo de código aberto tem parâmetros de 176B e um comprimento de contexto de 65K tokens

- Pode ser baixado via Torrent.

Mistral está de volta com um grande anúncio. Na manhã de quarta-feira, a empresa francesa apoiada pela Microsoft lançou seu modelo de fronteira, Mixtral 8x22B, enquanto a corrida pela IA esquentava.

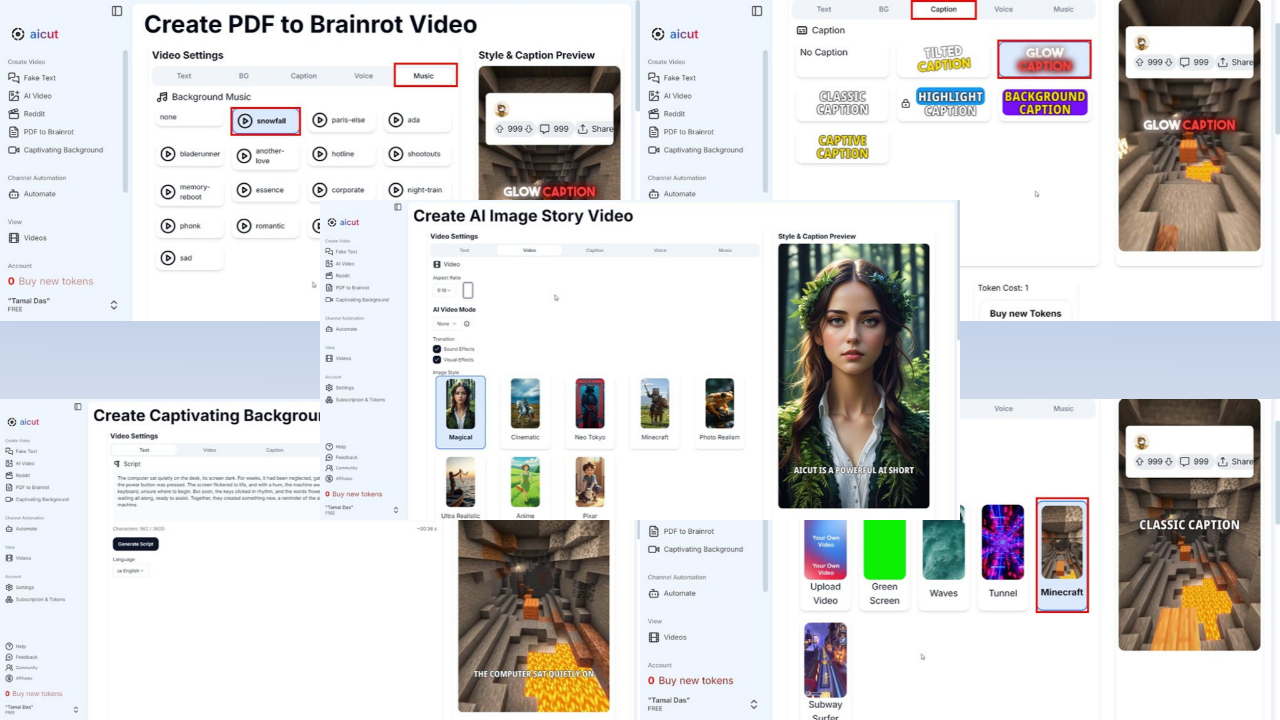

A melhor parte disso? É um sistema de código aberto e você pode baixá-lo via Torrent com 281 GB de tamanho de arquivo como inicialização da IA postou seu link magnético no X (anteriormente conhecido como Twitter). Também já está disponível em Abraçando o Rosto e Laboratórios de IA de perplexidade.

Mistral é composto principalmente por ex-funcionários do Google e Meta. O modelo antecessor da empresa, Mixtral 8x7B, foi lançado em dezembro do ano passado, mas diz-se que superou rivais como Llama-2 70B e GPT-3.5 da OpenAI em certos benchmarks como MMLU, ARC Challenge, MBPP e outros.

Agora, Mixtral 8x22B tem parâmetros de 176B e um comprimento de contexto de 65K tokens. Mesmo sendo enorme, ele utiliza apenas uma peça menor (44B) para cada tarefa, tornando seu uso mais acessível.

Sem dúvida foi uma das 24 horas mais movimentadas da indústria de IA. O Google finalmente fez Gêmeos 1.5 Pro disponível na maioria dos países e rebatizou seu Duet AI for Developers como Assistente de código Gemini, transferindo sua infraestrutura de Codey para Gemini.

Mais uma novidade da Meta, A Informação informou com exclusividade que o dono do Facebook está pronto para lançar uma versão menor do Llama 3 na próxima semana.

Fórum de usuários

Mensagens 0