Microsoft ajuda carros autônomos a conhecer suas limitações

2 minutos. ler

Publicado em

Leia nossa página de divulgação para descobrir como você pode ajudar o MSPoweruser a sustentar a equipe editorial Saiba mais

A ignorância é uma benção, e muitas vezes são os mais ignorantes que tomam as decisões mais seguras, não sendo sobrecarregados pelo conhecimento de que podem estar errados.

Em muitas situações, tudo isso é bom e bom, mas no nível atual de desenvolvimento de carros autônomos, ter um Tesla batendo com confiança em um caminhão de bombeiros ou van branca (ambos aconteceram) pode ser bastante perigoso.

A questão é que os carros autônomos são inteligentes o suficiente para dirigir carros, mas não para saber quando estão entrando em uma situação fora de seu nível de confiança e capacidade.

A Microsoft Research trabalhou com o MIT para ajudar os carros a saber exatamente quando as situações são ambíguas.

Como observa o MIT, uma única situação pode receber muitos sinais diferentes, porque o sistema percebe muitas situações como idênticas. Por exemplo, um carro autônomo pode ter cruzado ao lado de um carro grande muitas vezes sem diminuir a velocidade e parar. Mas, em apenas um caso, uma ambulância, que parece exatamente a mesma para o sistema, passa rapidamente. O carro autônomo não encosta e recebe um sinal de feedback de que o sistema realizou uma ação inaceitável. Como a circunstância incomum é rara, os carros podem aprender a ignorá-los, quando ainda são importantes, apesar de serem raros.

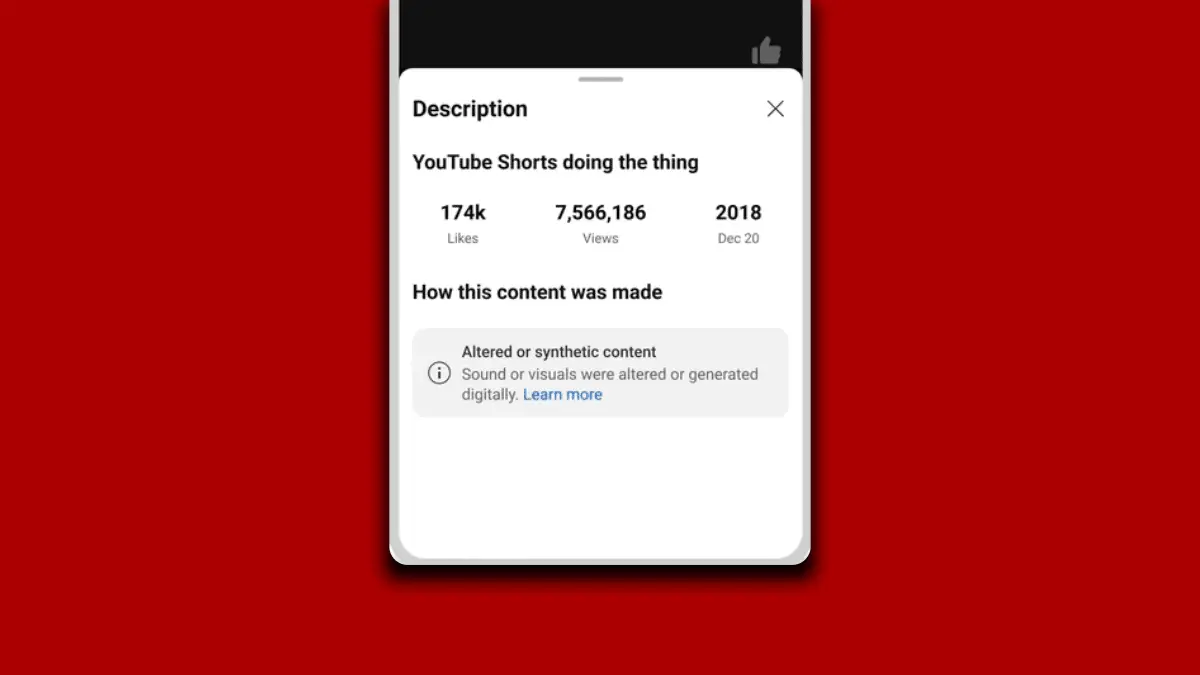

O novo sistema, para o qual a Microsoft contribuiu, reconhecerá esses sistemas raros com treinamento conflitante e pode aprender em uma situação em que pode ter, por exemplo, um desempenho aceitável em 90% das vezes, a situação ainda é ambígua o suficiente para merecer uma ver."

“Quando o sistema é implantado no mundo real, ele pode usar esse modelo aprendido para agir com mais cautela e inteligência. Se o modelo aprendido prevê que um estado seja um ponto cego com alta probabilidade, o sistema pode consultar um humano para a ação aceitável, permitindo uma execução mais segura”, disse Ramya Ramakrishnan, estudante de pós-graduação no Laboratório de Ciência da Computação e Inteligência Artificial.

Leia muito mais detalhes no MIT News aqui.