Co to jest GPT-3 i jak wpłynie na twoją obecną pracę

3 minuta. czytać

Zaktualizowano na

Przeczytaj naszą stronę z informacjami, aby dowiedzieć się, jak możesz pomóc MSPoweruser w utrzymaniu zespołu redakcyjnego Czytaj więcej

GPT to skrót od Generative Pre-training Transformer (GPT), modelu językowego napisanego przez Aleca Radforda i opublikowanego w 2018 roku przez OpenAI, laboratorium badawcze sztucznej inteligencji Elona Musksa. Wykorzystuje generatywny model języka (w którym dwie sieci neuronowe doskonalą się nawzajem poprzez konkurencję) i jest w stanie zdobywać wiedzę o świecie i przetwarzać długozasięgowe zależności poprzez wstępne uczenie się na różnych zestawach materiału pisanego z długimi odcinkami ciągłego tekstu.

GPT-2 (Generative Pretrained Transformer 2) został ogłoszony w lutym 2019 r. i jest nienadzorowanym modelem językowym transformatora wyszkolonym na 8 milionach dokumentów, co daje łącznie 40 GB tekstu z artykułów udostępnionych za pośrednictwem zgłoszeń Reddit. Elon Musk był znany z tego, że niechętnie go udostępniał, ponieważ obawiał się, że można go wykorzystać do spamowania sieci społecznościowych fałszywymi wiadomościami.

W maju 2020 r. OpenAI ogłosiło GPT-3 (Generative Pretrained Transformer 3), model, który zawiera dwa rzędy wielkości więcej parametrów niż GPT-2 (175 miliardów w porównaniu do 1.5 miliarda parametrów) i oferuje radykalną poprawę w porównaniu z GPT-2.

Po otrzymaniu dowolnego monitu tekstowego GPT-3 zwróci uzupełnienie tekstu, próbując dopasować wzorzec, który mu podałeś. Możesz go „zaprogramować”, pokazując mu tylko kilka przykładów tego, co chcesz, aby zrobił, a dostarczy kompletny artykuł lub historię, taką jak tekst poniżej, napisany w całości przez GPT-3.

GPT-3 osiąga wysoką wydajność w wielu zestawach danych NLP, w tym w zadaniach tłumaczenia, odpowiadania na pytania i zamykania, a także w kilku zadaniach, które wymagają rozumowania w locie lub adaptacji domeny, takich jak rozszyfrowywanie słów, przy użyciu nowego słowa w zdanie lub wykonywanie arytmetyki 3-cyfrowej. GPT-3 może generować próbki artykułów prasowych, które ludzie oceniający mają trudności z odróżnieniem od artykułów napisanych przez ludzi.

Ostatnia aplikacja zawsze martwiła OpenAI. GPT-3 jest obecnie dostępny jako otwarta beta, a płatna prywatna wersja beta ma być w końcu dostępna. OpenAI powiedział, że zamknie dostęp do API w przypadku oczywiście szkodliwych przypadków użycia, takich jak nękanie, spam, radykalizacja lub astroturfing.

Podczas gdy najbardziej zagrożoną populacją są ci, którzy tworzą prace pisemne, na przykład scenarzyści, twórcy sztucznej inteligencji znaleźli już zaskakujące aplikacje, takie jak używanie GPT-3 do pisania kodu.

Na przykład Sharif Shameem napisał generator układu, w którym opisujesz zwykłym tekstem, co chcesz, a model generuje odpowiedni kod.

To jest oszałamiające.

W GPT-3 zbudowałem generator układu, w którym po prostu opisujesz dowolny układ, a on generuje dla ciebie kod JSX.

— Sharif Shameem (@sharifshameem) 13 lipca 2020 r.

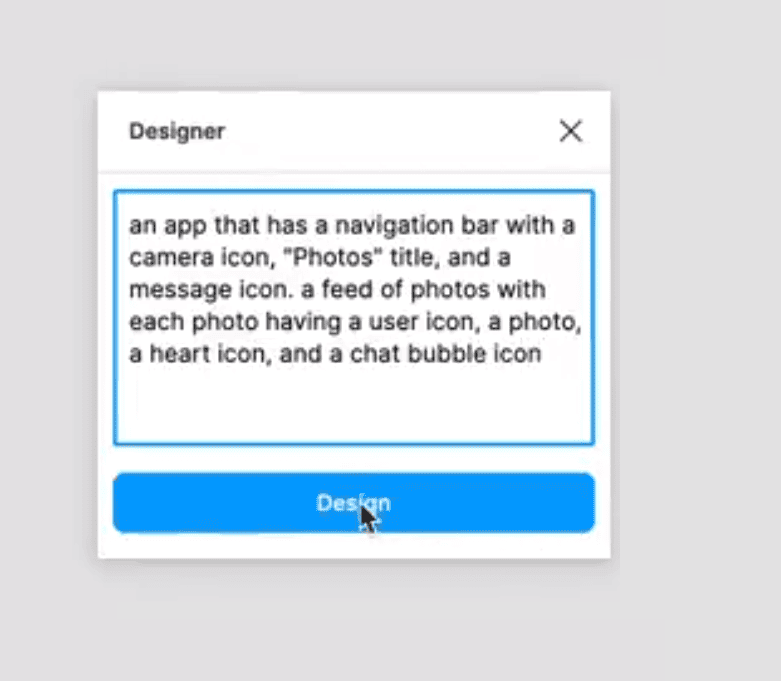

Podobnie Jordan Singer stworzył wtyczkę Figma, która umożliwia tworzenie aplikacji przy użyciu opisów tekstowych.

To wszystko zmienia. ?

W GPT-3 zbudowałem wtyczkę Figma do zaprojektowania dla Ciebie.

Nazywam to "Projektantem" pic.twitter.com/OzW1sKNLEC

— piosenkarka jordańska (@jsngr) 18 lipca 2020 r.

Może być nawet używany do diagnozowania astmy i przepisywania leków.

So @OtwarteAI dały mi wczesny dostęp do narzędzia, które pozwala programistom korzystać z najpotężniejszego generatora tekstu w historii. Pomyślałem, że przetestuję to, zadając pytanie medyczne. Tekst pogrubiony to tekst generowany przez sztuczną inteligencję. Niesamowite… (1/2) pic.twitter.com/4bGfpI09CL

— Qasim Munye (@qasimmunye) 2 lipca 2020 r.

Inne aplikacje działają jak wyszukiwarka lub swego rodzaju wyrocznia, a nawet mogą służyć do wyjaśniania i rozwijania trudnych pojęć.

Zrobiłem w pełni działającą wyszukiwarkę na GPT3.

W przypadku dowolnego zapytania zwraca dokładną odpowiedź ORAZ odpowiedni adres URL.

Obejrzyj cały film. To jest BARDZO dobre.

cc: @gdb @npw @gwerna pic.twitter.com/9ismj62w6l

— Paras Chopra (@paraschopra) 19 lipca 2020 r.

Chociaż wydaje się, że takie podejście może prowadzić bezpośrednio do ogólnej sztucznej inteligencji, która potrafi rozumieć, rozumować i rozmawiać jak człowiek, OpenAI ostrzega, że mogły napotkać fundamentalne problemy ze skalowaniem, przy czym GPT-3 wymaga kilku tysięcy petaflopów/s-dni obliczeń , w porównaniu z dziesiątkami petaflopów/s-dni dla pełnego GPT-2. Wydaje się, że kiedy jesteśmy bliżej, przełom, który sprawi, że wszystkie nasze miejsca pracy staną się przestarzałe, jest jeszcze w pewnej odległości.

Przeczytaj więcej o GPT-3 na GitHub tutaj.