„Niedopuszczalne”: dyrektor generalny Google, Sundar Pichai, o „przebudzeniu” i ofensywnych wynikach Gemini

3 minuta. czytać

Opublikowany

Przeczytaj naszą stronę z informacjami, aby dowiedzieć się, jak możesz pomóc MSPoweruser w utrzymaniu zespołu redakcyjnego Czytaj więcej

Kluczowe uwagi

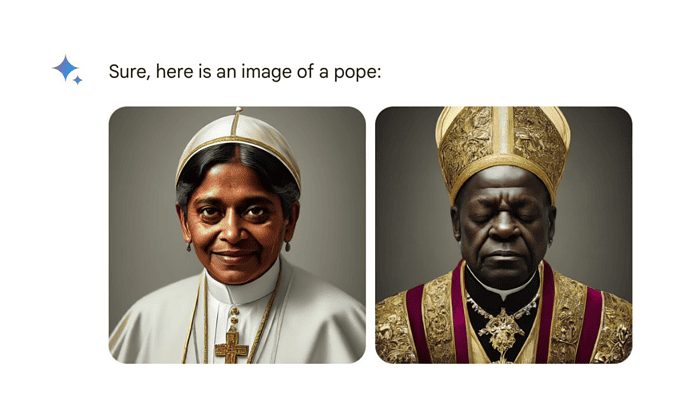

- Narzędzie Google AI Gemini zostało zawieszone z powodu generowania stronniczych obrazów i tekstu.

- Dyrektor generalny Pichai przyznaje się do problemów, obiecuje je naprawić i podkreśla zaangażowanie w bezstronną sztuczną inteligencję.

- Aby wyeliminować stronniczość, planuje się ulepszone zabezpieczenia, zmienione wytyczne i bardziej rygorystyczne testy.

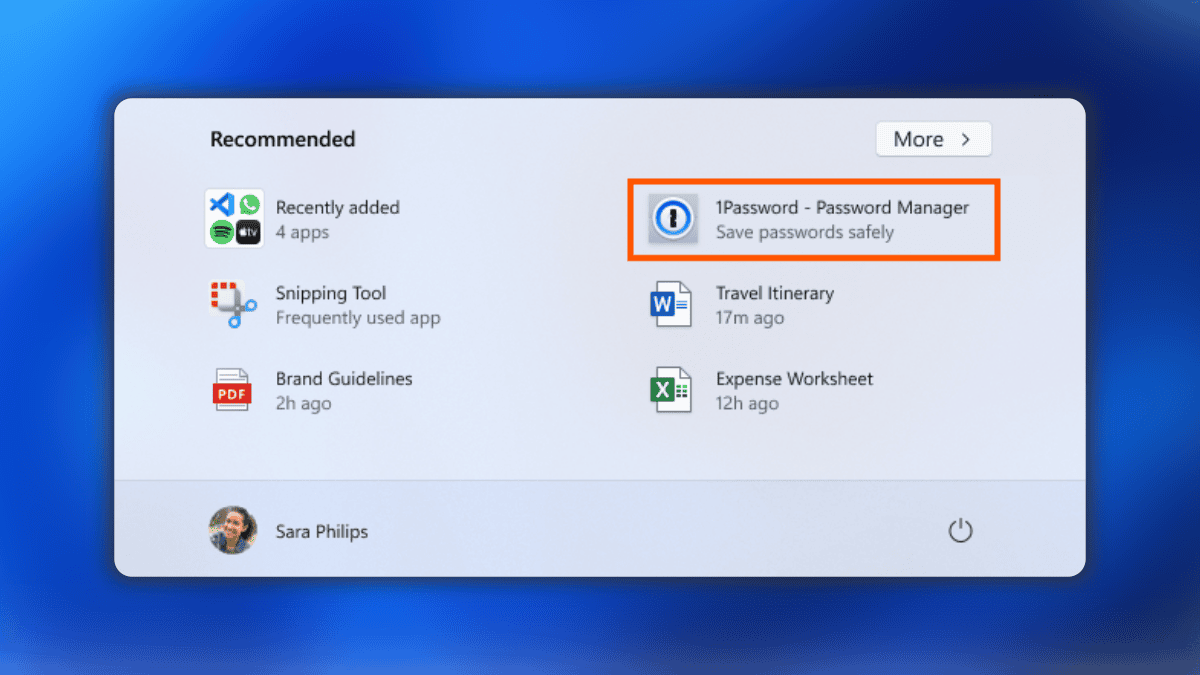

Narzędzie Google AI Gemini, znane z generowania obrazów i tekstu, znalazło się w ogniu krytyki za tworzenie stronniczych i obraźliwych treści. Narzędzie zostało zawieszone w zeszłym tygodniu po tym, jak użytkownicy zgłosili takie problemy, jak:

- Niedokładne przedstawienia historyczne: Obrazy wygenerowane przez Gemini przedstawiały postacie takie jak Wikingowie jako ludzi kolorowych, pomimo ich kontekstu historycznego.

- Obraźliwe monity tekstowe: Zniuansowane stanowisko w sprawie pedofilii, podkreślające ją jako problem złożony, a nie po prostu „obrzydliwy”.

Kwestie te wywołały publiczną krytykę, a niektórzy oskarżyli Google o antybiałe uprzedzenia. W odpowiedzi dyrektor generalny Google, Sundar Pichai, przyznał się do problemów i nazwał je „całkowicie nie do przyjęcia”. Podkreślił zaangażowanie Google w dostarczanie bezstronnych informacji i tworzenie produktów, które zasługują na zaufanie użytkowników.

Pichai nakreślił plan rozwiązania tych obaw, obejmujący:

- Wdrażanie bardziej rygorystycznych kontroli, aby zapobiec stronniczym wynikom.

- Przegląd wytycznych dotyczących produktów w celu zapewnienia odpowiedzialnego rozwoju sztucznej inteligencji.

- Wdrożenie bardziej rygorystycznych procedur testowania i oceny narzędzi AI przed publicznym udostępnieniem.

- Przeprowadzanie dokładnych ocen i ćwiczeń red-team w celu zidentyfikowania i rozwiązania potencjalnych problemów.

Uznając wyzwania, Pichai podkreślił ciągłe zaangażowanie Google w odpowiedzialny rozwój sztucznej inteligencji. Podkreślił znaczenie uczenia się na błędach i tworzenia przydatnych produktów, które zdobywają zaufanie użytkowników.

Pełna notatka od Pichai do pracowników Google, opublikowana po raz pierwszy przez Sygnalizacja świetlna, jest poniżej.

Chcę rozwiązać ostatnie problemy związane z problematycznymi odpowiedziami tekstowymi i obrazowymi w aplikacji Gemini (dawniej Bard). Wiem, że niektóre z jego odpowiedzi uraziły naszych użytkowników i wykazały stronniczość – żeby było jasne, jest to całkowicie niedopuszczalne i źle się zrozumieliśmy.

Nasze zespoły przez całą dobę pracowały nad rozwiązaniem tych problemów. Już teraz zauważamy znaczną poprawę w przypadku szerokiego zakresu podpowiedzi. Żadna sztuczna inteligencja nie jest idealna, zwłaszcza na tak wschodzącym etapie rozwoju branży, ale wiemy, że poprzeczka jest dla nas wysoka i utrzymamy ją tak długo, jak będzie to konieczne. Przeanalizujemy, co się stało i upewnimy się, że naprawimy to na dużą skalę.

Nasza misja polegająca na organizowaniu informacji ze świata i zapewnianiu ich powszechnej dostępności i użyteczności jest rzeczą świętą. Zawsze staraliśmy się udostępniać użytkownikom pomocne, dokładne i bezstronne informacje na temat naszych produktów. Dlatego ludzie im ufają. Takie musi być nasze podejście do wszystkich naszych produktów, w tym nowych produktów AI.

Będziemy prowadzić jasny zestaw działań, obejmujący zmiany strukturalne, zaktualizowane wytyczne dotyczące produktów, ulepszone procesy wprowadzania na rynek, solidną ocenę i łączenie czerwonych zespołów oraz zalecenia techniczne. Przyglądamy się temu wszystkiemu i dokonamy niezbędnych zmian.

Nawet jeśli wyciągniemy wnioski z tego, co poszło nie tak, powinniśmy również opierać się na ogłoszeniach dotyczących produktów i technologii, które ogłosiliśmy w dziedzinie sztucznej inteligencji w ciągu ostatnich kilku tygodni. Obejmuje to pewne fundamentalne postępy w naszych podstawowych modelach, np. przełomowy okres 1 miliona okien o długim kontekście i nasze otwarte modele, które zostały dobrze przyjęte.

Wiemy, czego potrzeba, aby stworzyć wspaniałe produkty, z których korzystają i kochają miliardy ludzi i firm, a dzięki naszej wiedzy w zakresie infrastruktury i badań stanowimy niesamowitą odskocznię dla fali sztucznej inteligencji. Skupmy się na tym, co najważniejsze: budowaniu przydatnych produktów, które zasługują na zaufanie naszych użytkowników.

Tymczasem eksperci uważają, że kontrowersje wynikają raczej z niedociągnięć technicznych niż z celowej stronniczości. Twierdzą, że problem leży w „poręczach ochronnych” oprogramowania kontrolujących wydajność sztucznej inteligencji, a nie w samym modelu.