Snowflake Arctic jest dumny z tego, że jest „najlepszym LLM dla sztucznej inteligencji dla przedsiębiorstw”. To dość duże twierdzenie

Możesz teraz wypróbować Snowflake na HuggingFace

2 minuta. czytać

Opublikowany

Przeczytaj naszą stronę z informacjami, aby dowiedzieć się, jak możesz pomóc MSPoweruser w utrzymaniu zespołu redakcyjnego Czytaj więcej

Kluczowe uwagi

- Snowflake wprowadza Arctic, twierdząc, że może konkurować z Llamą 3 70B niższymi kosztami.

- Arctic przoduje w zadaniach korporacyjnych, takich jak kodowanie i generowanie SQL.

- Korzystając z hybrydy Dense-MoE, Arctic optymalizuje wydajność dla różnych wielkości partii.

Snowflake, gigant przetwarzania w chmurze utworzony początkowo przez byłych naukowców Oracle, rzuca teraz wyzwanie wielkim graczom w wojnie ze sztuczną inteligencją. Firma wystartowała Arktyka płatka śniegu, swój najnowszy „najlepszy LLM dla sztucznej inteligencji dla przedsiębiorstw” i stwierdził, że jest lepszy niż na poziomie Llama 3 70B i lepszy niż wariant 8B tego ostatniego.

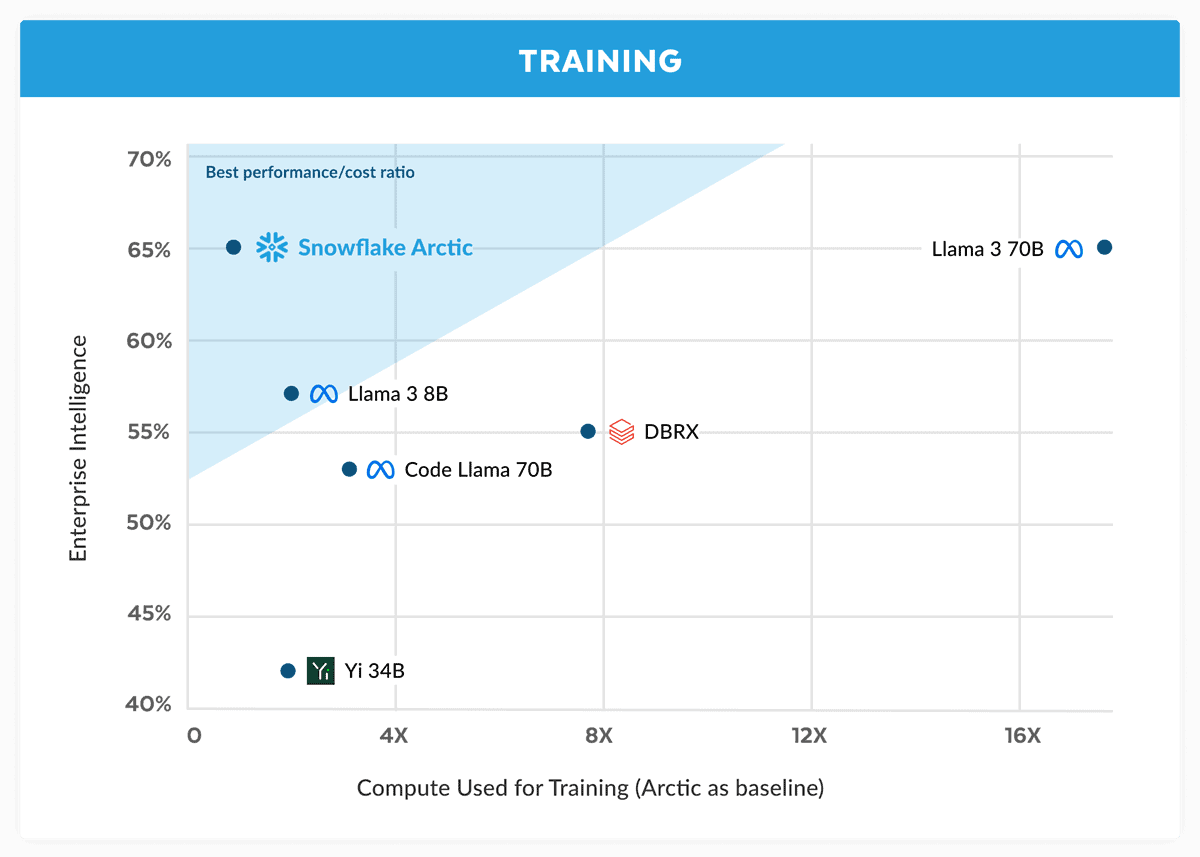

W swoim ogłoszeniu Snowflake twierdzi, że model Arctic dorównuje wydajnością Llama 3 70B, ale ma niższe wymagania obliczeniowe i koszty. Jest reklamowany jako idealny do zadań związanych z inteligencją przedsiębiorstwa w obszarach i testach porównawczych, takich jak kodowanie (HumanEval+ i MBPP+), generowanie SQL (Spider) i wykonywanie instrukcji (IFEval).

To duże twierdzenie, zwłaszcza biorąc pod uwagę to Lama 3 70B w ważnych testach wypadł dobrze w porównaniu z innymi głównymi modelami, takimi jak GPT-4 Turbo i Claude 3 Opus. Nadchodzący model Meta podobno dobrze wypada w testach porównawczych, takich jak MMLU (zrozumienie przedmiotów), GPQA (biologia, fizyka i chemia oraz HumanEval (kodowanie).

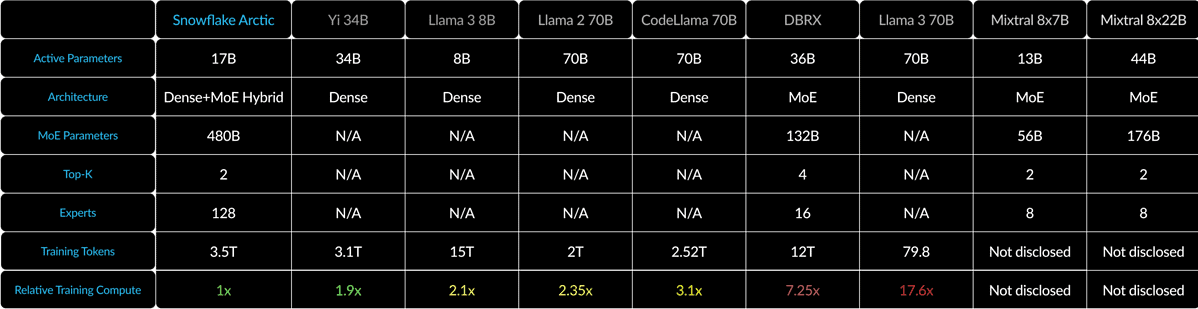

Snowflake Arctic łączy gęsty transformator 10B z 128×3.66B MoE MLP przy użyciu hybrydy Dense-MoE. Łącznie daje to 480B parametrów, ale aktywnie wykorzystywanych jest tylko 17B, wybranych przy użyciu bramkowania top-2.

W przypadku małych partii, takich jak 1, Arctic zmniejsza odczyty pamięci nawet 4 razy w porównaniu do Code-Llama 70B i do 2.5 razy mniej niż Mixtral 8x22B. Jednak w miarę znacznego wzrostu wielkości partii Arctic staje się ograniczony obliczeniami. Wymaga 4x mniej obliczeń niż CodeLlama 70B i Llama 3 70B.

Możesz wypróbować Snowflake Arctic Przytulanie twarzy. Firma obiecuje również, że model wkrótce pojawi się w innych ogrodach modelowych, takich jak AWS, Microsoft Azure, Perplexity i nie tylko.

Forum użytkowników

Wiadomości 0