Wreszcie pojawił się model open source Mixtral 8x22B, który można pobrać przez Torrent

Jak dotąd było kilka pracowitych dni w branży AI

2 minuta. czytać

Opublikowany

Przeczytaj naszą stronę z informacjami, aby dowiedzieć się, jak możesz pomóc MSPoweruser w utrzymaniu zespołu redakcyjnego Czytaj więcej

Kluczowe uwagi

- W miarę jak wyścig o sztuczną inteligencję nabiera tempa, Mistral wypuścił swój pionierski model, Mixtral 8x22B.

- Model open source ma 176B parametrów i długość kontekstu 65 tys. tokenów

- Można go pobrać przez Torrent.

Mistral powraca z wielkim ogłoszeniem. W środę francuska firma, wspierana przez Microsoft, wypuściła na rynek swój pionierski model Mixtral 8x22B, gdy wyścig o sztuczną inteligencję nabiera tempa.

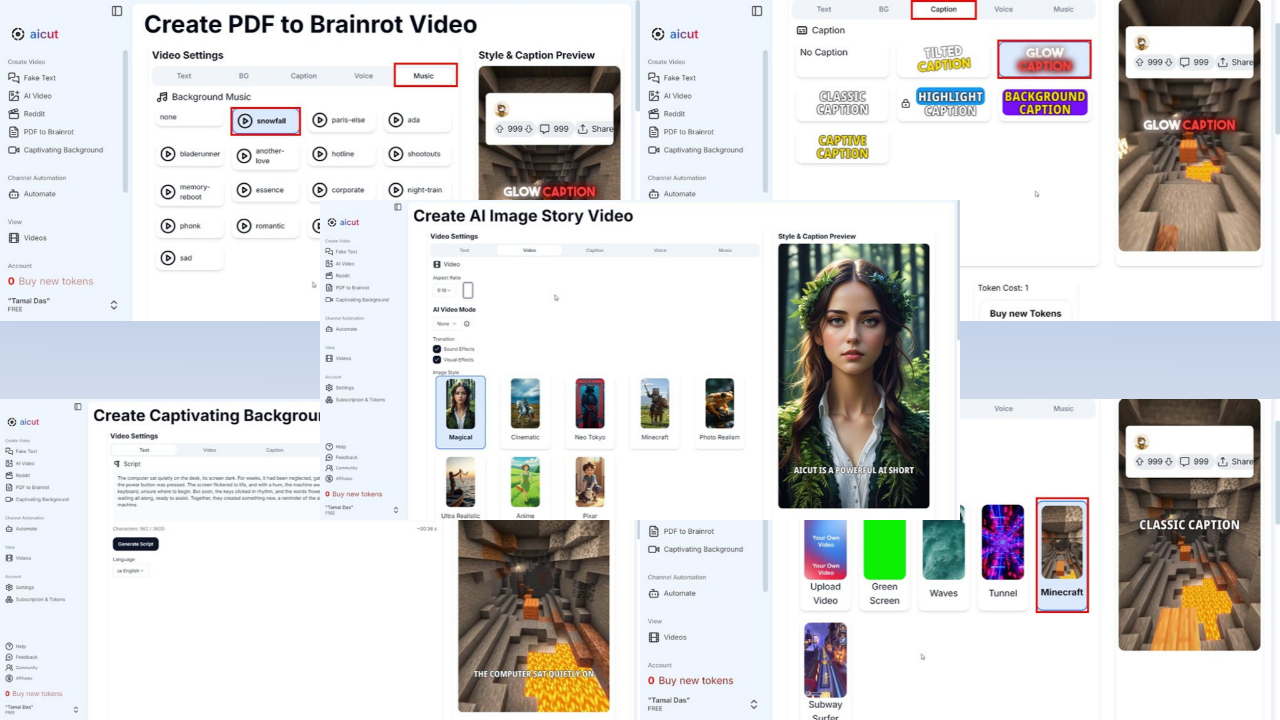

Najlepsza część? Jest to system typu open source, który można pobrać przez Torrent w rozmiarze pliku 281 GB podczas uruchamiania AI opublikował swój link do magnesu na X (dawniej znanym jako Twitter). Jest teraz dostępny także na Przytulanie twarzy i Laboratoria sztucznej inteligencji zakłopotania.

Mistral składa się głównie z byłych pracowników Google i Meta. Poprzednikiem firmy był model Mixtral 8x7B uruchomiona w grudniu ubiegłego roku, ale podobno przewyższał rywali, takich jak Llama-2 70B i GPT-3.5 OpenAI, w niektórych testach porównawczych, takich jak MMLU, ARC Challenge, MBPP i innych.

Teraz Mixtral 8x22B ma 176B parametrów i długość kontekstu 65 tys. tokenów. Mimo że jest ogromny, do każdego zadania wykorzystuje tylko mniejszą część (44B), co czyni go tańszym w użyciu.

To bez wątpienia jedna z najbardziej pracowitych 24 godzin w branży AI. Google w końcu stworzył Dostępny Gemini 1.5 Pro w większości krajów i zmienił nazwę Duet AI for Developers na Asystent kodu Bliźniąt, przenosząc swoją infrastrukturę z Codey do Gemini.

Kolejna wiadomość od Meta, Informacja wyłącznie poinformował, że właściciel Facebooka jest gotowy wypuścić w przyszłym tygodniu mniejszą wersję Lamy 3.

Forum użytkowników

Wiadomości 0