Hva er GPT-3 og hvordan vil det påvirke din nåværende jobb

3 min. lese

Oppdatert på

Les vår avsløringsside for å finne ut hvordan du kan hjelpe MSPoweruser opprettholde redaksjonen Les mer

GPT er forkortelse for Generative Pre-training Transformer (GPT), en språkmodell skrevet av Alec Radford og publisert i 2018 av OpenAI, Elon Musks forskningslaboratorium for kunstig intelligens. Den bruker en generativ språkmodell (hvor to nevrale nettverk perfeksjonerer hverandre ved konkurranse) og er i stand til å tilegne seg kunnskap om verden og behandle langdistanseavhengigheter ved å forhåndstrene på forskjellige sett med skriftlig materiale med lange strekninger med sammenhengende tekst.

GPT-2 (Generative Pretrained Transformer 2) ble annonsert i februar 2019 og er en uovervåket transformatorspråkmodell trent på 8 millioner dokumenter for totalt 40 GB tekst fra artikler delt via Reddit-innsendinger. Elon Musk var berømt motvillig til å gi den ut fordi han var bekymret for at den kunne brukes til å spamme sosiale nettverk med falske nyheter.

I mai 2020 annonserte OpenAI GPT-3 (Generative Pretrained Transformer 3), en modell som inneholder to størrelsesordener flere parametere enn GPT-2 (175 milliarder mot 1.5 milliarder parametere) og som tilbyr en dramatisk forbedring i forhold til GPT-2.

Gitt en tekstmelding, vil GPT-3 returnere en tekstfullføring, og forsøke å matche mønsteret du ga den. Du kan "programmere" den ved å vise den bare noen få eksempler på hva du vil at den skal gjøre, og den vil levere en komplett artikkel eller historie, for eksempel teksten nedenfor, skrevet utelukkende av GPT-3.

GPT-3 oppnår sterk ytelse på mange NLP-datasett, inkludert oversettelse, besvarelse av spørsmål og lukkede oppgaver, i tillegg til flere oppgaver som krever resonnement eller domenetilpasning underveis, for eksempel å rydde opp ord, bruke et nytt ord i en setning, eller utføre 3-sifret aritmetikk. GPT-3 kan generere prøver av nyhetsartikler som menneskelige evaluatorer har problemer med å skille fra artikler skrevet av mennesker.

Den siste applikasjonen har alltid bekymret OpenAI. GPT-3 er for øyeblikket tilgjengelig som en åpen beta, med en betalt privat beta som forventes å være tilgjengelig etter hvert. OpenAI sa at de vil avslutte API-tilgang for åpenbart skadelige brukstilfeller, for eksempel trakassering, spam, radikalisering eller astroturfing.

Mens den mest åpenbart truede befolkningen er de som produserer skriftlig arbeid, for eksempel manusforfattere, har AI-utviklere allerede funnet overraskende applikasjoner, som å bruke GPT-3 til å skrive kode.

Sharif Shameem skrev for eksempel en layoutgenerator der du beskriver i ren tekst hva du ønsker, og modellen genererer den passende koden.

Dette er tankegang.

Med GPT-3 bygde jeg en layoutgenerator der du bare beskriver hvilken layout du vil ha, og den genererer JSX-koden for deg.

HVA pic.twitter.com/w8JkrZO4lk

- Sharif Shameem (@sharifshameem) Juli 13, 2020

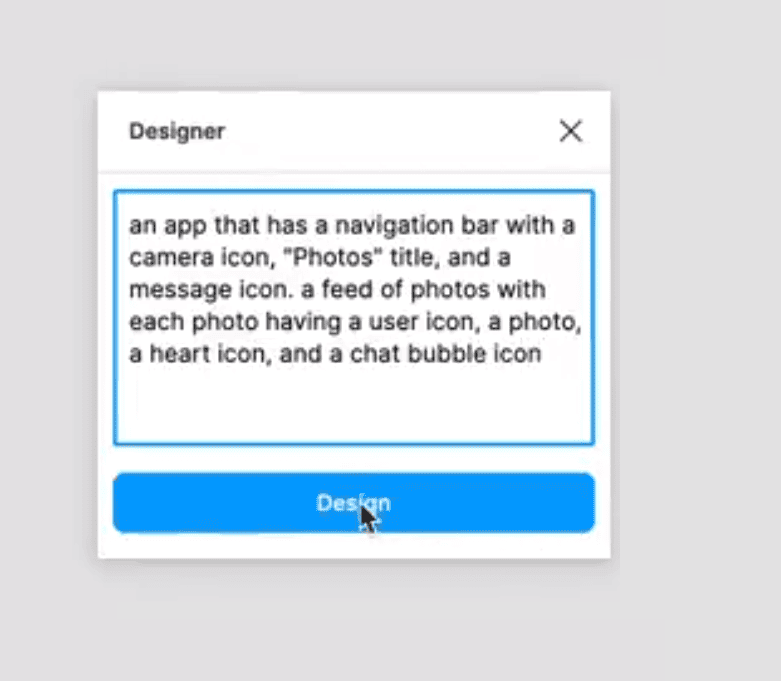

Jordan Singer opprettet på samme måte en Figma-plugin som lar en lage apper ved å bruke ren tekstbeskrivelser.

Dette endrer alt. ?

Med GPT-3 bygde jeg en Figma-plugin for å designe for deg.

Jeg kaller det "designer" pic.twitter.com/OzW1sKNLEC

— jordan sanger (@jsngr) Juli 18, 2020

Det kan til og med brukes til å diagnostisere astma og foreskrive medisiner.

So @OpenAI har gitt meg tidlig tilgang til et verktøy som lar utviklere bruke det som egentlig er den kraftigste tekstgeneratoren noensinne. Jeg tenkte jeg skulle teste det ved å stille et medisinsk spørsmål. Den fete teksten er teksten som genereres av AI. Utrolig... (1/2) pic.twitter.com/4bGfpI09CL

— Qasim Munye (@qasimmunye) Juli 2, 2020

Andre applikasjoner er som en søkemotor eller orakel, og kan til og med brukes til å forklare og utvide vanskelige konsepter.

Jeg laget en fullt fungerende søkemotor på toppen av GPT3.

For ethvert vilkårlig søk returnerer det det eksakte svaret OG den tilsvarende URL-en.

Se på hele videoen. Den er MEGET BLØSENDE bra.

cc: @gdb @npew @gwern pic.twitter.com/9ismj62w6l

— Paras Chopra (@paraschopra) Juli 19, 2020

Selv om det ser ut til at denne tilnærmingen kan føre direkte til en generell AI som kan forstå, resonnere og snakke som et menneske, advarer OpenAI om at de kan ha støtt på grunnleggende oppskaleringsproblemer, med GPT-3 som krever flere tusen petaflop/s-dager med beregning , sammenlignet med titalls petaflop/s-dager for hele GPT-2. Mens vi er nærmere ser det ut til at gjennombruddet som vil gjøre alle jobbene våre foreldet, fortsatt er et stykke unna.

Les mer om GPT-3 på GitHub her.